MiniOB 介绍

MiniOB 是 OceanBase 团队基于华中科技大学数据库课程原型,联合多所高校重新开发的、专为零基础的同学设计的数据库入门学习项目。我们的目标是为在校学生、数据库从业者、爱好者或对基础技术感兴趣的人提供一个友好的数据库学习项目。

MiniOB 整体代码简洁,容易上手,设计了一系列由浅入深的题目,帮助同学们从零基础入门,迅速了解数据库并深入学习数据库内核。MiniOB 简化了许多模块,例如不考虑并发操作、安全特性和复杂的事务管理等功能,以便更好地学习数据库实现原理。我们期望通过 MiniOB 的训练,同学们能够熟练掌握数据库内核模块的功能和协同关系,并具备一定的工程编码能力,例如内存管理、网络通信和磁盘 I/O 处理等, 这将有助于同学在未来的面试和工作中脱颖而出。

文档

MiniOB 提供了丰富的设计文档和代码注释。如果在阅读代码过程中遇到不容易理解的内容,并且没有相关的文档或文档描述不清晰,欢迎提出 issue,我们会尽快完善文档。

快速上手

为了帮助开发者更好地上手并学习 MiniOB,建议阅读以下内容:

为了帮助大家更好地学习数据库基础知识,OceanBase社区提供了一系列教程。更多文档请参考 MiniOB GitHub Pages。建议学习:

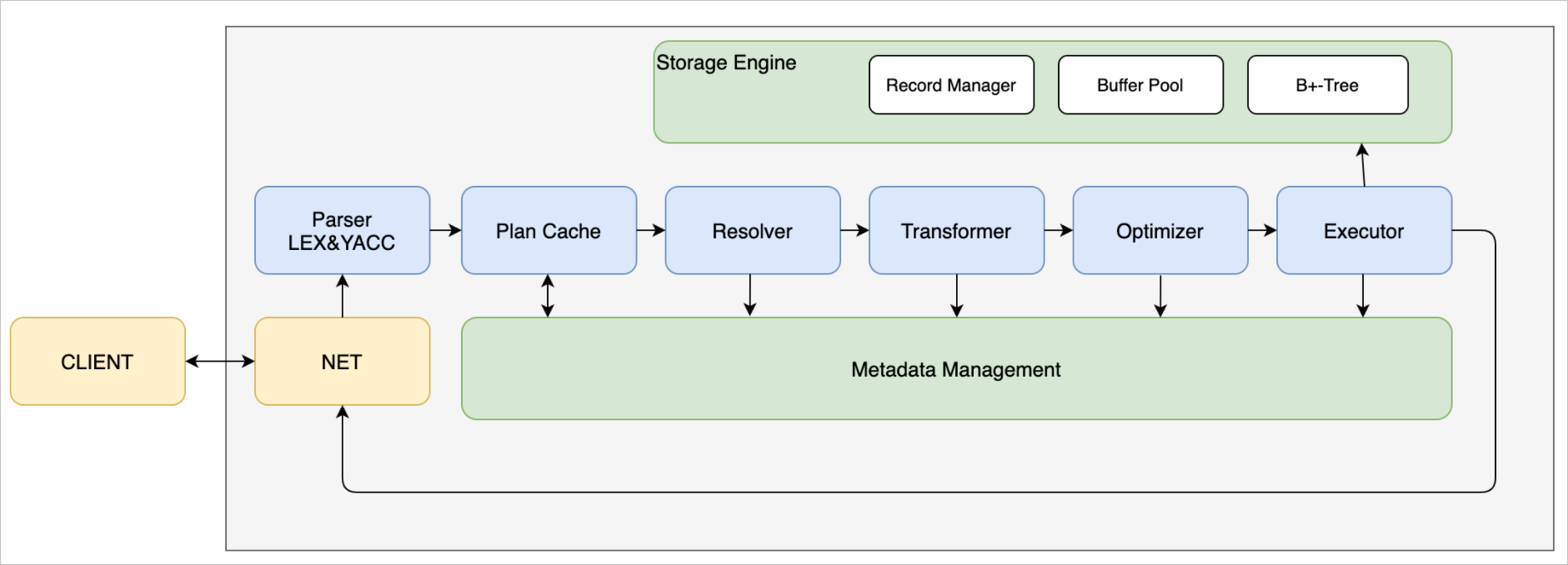

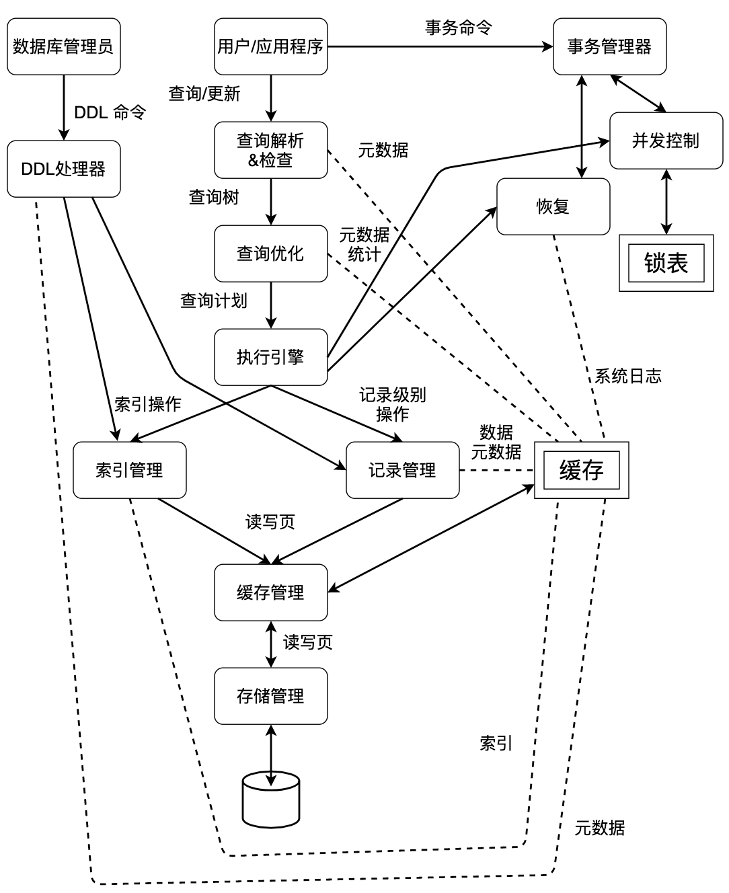

系统架构

其中:

- 网络模块(NET Service):负责与客户端交互,收发客户端请求与应答;

- SQL解析(Parser):将用户输入的SQL语句解析成语法树;

- 语义解析模块(Resolver):将生成的语法树,转换成数据库内部数据结构;

- 查询优化(Optimizer):根据一定规则和统计数据,调整/重写语法树。(部分实现);

- 计划执行(Executor):根据语法树描述,执行并生成结果;

- 存储引擎(Storage Engine):负责数据的存储和检索;

- 事务管理(MVCC):管理事务的提交、回滚、隔离级别等。当前事务管理仅实现了MVCC模式,因此直接以MVCC展示;

- 日志管理(Redo Log):负责记录数据库操作日志;

- 记录管理(Record Manager):负责管理某个表数据文件中的记录存放;

- B+ Tree:表索引存储结构;

- 会话管理:管理用户连接、调整某个连接的参数;

- 元数据管理(Meta Data):记录当前的数据库、表、字段和索引元数据信息;

- 客户端(Client):作为测试工具,接收用户请求,向服务端发起请求。

OceanBase 大赛

全国大学生计算机系统能力大赛(以下简称“大赛”)是由系统能力培养研究专家组发起,全国高等学校计算机教育研究会、系统能力培养研究项目示范高校共同主办、OceanBase 承办,面向高校大学生的全国性数据库大赛。 大赛面向全国爱好数据库的高校学生,以“竞技、交流、成长”为宗旨,搭建基于赛事的技术交流平台,促进高校创新人才培养机制,不仅帮助学生从0开始系统化学习 OceanBase 数据库理论知识,提升学生数据库实践能力,更能帮助学生走向企业积累经验,促进国内数据库人才的发展,碰撞出创新的火花。

OceanBase 初赛基于一套适合初学者实践的数据库实训平台 MiniOB,代码量少,易于上手学习,包含了数据库的各个关键模块,是一个系统性的数据库学习平台。基于该平台设置了一系列由浅入深的题目,以帮助同学们更好"零"基础入门。

为了帮助大家能在大赛中取得好成绩,我们提供了一系列的教程和指导,帮助大家更好地学习数据库基础知识,更好地完成大赛题目。 欢迎大家查看《从0到1数据库内核实战教程》 视频教程,视频中包含了代码框架的介绍和一些入门题目的讲解。

由于MiniOB是一个持续演进的产品,视频教程中有些内容会与最新代码有冲突,建议大家参考讲解中的思路。

大赛的初赛是在MiniOB上进行的,同学们可以在前几届的题目上进行提前训练,可以让自己比别人提前一步。大家在日常训练时可以在MiniOB 训练营 上提交代码进行测试。

在提交前, 请参考并学习 训练营使用说明。

如果大家在大赛中或使用训练营时遇到一些问题,请先查看大赛 FAQ。

如何编译

0. base

假设系统上已经安装了make等编译工具。

MiniOB 需要使用:

- cmake 版本 >= 3.13

- gcc/clang gcc建议8.3以上,编译器需要支持c++20新标准

- flex (2.5+), bison (3.7+) 用于生成词法语法分析代码

1. 环境初始化

如果是第一次在这个环境上编译miniob,需要安装一些miniob的依赖库,执行下面的命令即可安装:

bash build.sh init

脚本将自动拉取依赖库(可以参考 .gitmodules) 然后编译安装到系统目录。

如果执行用户不是root,需要在命令前加上 sudo:

sudo bash build.sh init

如果使用 GitPod 开发,可以跳过这步,会自动执行。

2. 编译

执行下面的命令即可完成编译:

bash build.sh

此命令将编译一个DEBUG版本的miniob。如果希望编译其它版本的,可以参考 bash build.sh -h,比如:

bash build.sh release

此命令将编译release版本的miniob。

3. 运行

参考 如何运行

FAQ

1. sudo找不到cmake

Q:

在“1. 环境初始化”中执行命令:

sudo bash build.sh init

时,报错:

build.sh: line xx: cmake: command not found

A:

1. 检查“0. base”中cmake版本要求是否满足。

cmake --version

2. 检查是否出现了“Linux系统下执行sudo命令环境变量失效现象”。

检查

在当前用户和root用户下均能找到cmake,而在当前用户下sudo cmake却找不到cmake,即:

[mu@vm-cnt8:~]$ sudo -E cmake --version

[sudo] password for mu:

sudo: cmake: command not found

则可能就出现了“Linux系统下执行sudo命令环境变量失效现象”,本例中具体是PATH环境变量实效(被重置),导致找不到cmake。

解决方法:建立软链接

- 找到执行sudo命令时的PATH变量中有哪些路径:

[mu@vm-cnt8:~]$ sudo env | grep PATH

PATH=/sbin:/bin:/usr/sbin:/usr/bin

- 找到cmake所在的路径:

[mu@vm-cnt8:~]$ whereis cmake

cmake: /usr/local/bin/cmake /usr/share/cmake

- 在PATH变量中的一个合适路径下建立指向cmake的软链接:

[root@vm-cnt8:~]# ls /usr/bin | grep cmake

[root@vm-cnt8:~]# ln -s /usr/local/bin/cmake /usr/bin/cmake

[root@vm-cnt8:~]# ll /usr/bin | grep cmake

lrwxrwxrwx. 1 root root 20 Sep 1 05:57 cmake -> /usr/local/bin/cmake

验证

$ sudo -E cmake --version

cmake version 3.27.4

发现sudo时能找到cmake了,此时再执行

sudo bash build.sh init

则不会因为找不到cmake而报错。

更多信息:

关于该问题的更多细节,请参考问题来源。 关于该问题的进一步分析,请参考Linux系统下执行sudo命令环境变量失效现象。 也可以将cmake所在路径添加到sudo的PATH变量中来解决上述问题,请参考sudo命令下环境变量实效的解决方法。

如何运行

编译完成后,可以在build目录(可能是build_debug或build_release)下找到bin/observer,就是我们的服务端程序,bin/obclient是自带的客户端程序。 当前服务端程序启动已经支持了多种模式,可以以TCP、unix socket方式启动,这时需要启动客户端以发起命令。observer还支持直接执行命令的模式,这时不需要启动客户端,直接在命令行输入命令即可。

以直接执行命令的方式启动服务端程序

./bin/observer -f ../etc/observer.ini -P cli

这会以直接执行命令的方式启动服务端程序,可以直接输入命令,不需要客户端。所有的请求都会以单线程的方式运行,配置项中的线程数不再有实际意义。

以监听TCP端口的方式启动服务端程序

./bin/observer -f ../etc/observer.ini -p 6789

这会以监听6789端口的方式启动服务端程序。 启动客户端程序:

./bin/obclient -p 6789

这会连接到服务端的6789端口。

以监听unix socket的方式启动服务端程序

./bin/observer -f ../etc/observer.ini -s miniob.sock

这会以监听unix socket的方式启动服务端程序。 启动客户端程序:

./bin/obclient -s miniob.sock

这会连接到服务端的miniob.sock文件。

并发模式

默认情况下,编译出的程序是不支持并发的。如果需要支持并发,需要在编译时增加选项 -DCONCURRENCY=ON:

cmake -DCONCURRENCY=ON ..

或者

bash build.sh -DCONCURRENCY=ON

然后使用上面的命令启动服务端程序,就可以支持并发了。

启动参数介绍

| 参数 | 说明 |

|---|---|

| -h | 帮助说明 |

| -f | 配置文件路径。如果不指定,就会使用默认值 ../etc/observer.ini。 |

| -p | 服务端监听的端口号。如果不指定,并且没有使用unix socket或cli的方式启动,就会使用配置文件中的值,或者使用默认值。 |

| -s | 服务端监听的unix socket文件。如果不指定,并且没有使用TCP或cli的方式启动,就会使用TCP的方式启动服务端。 |

| -P | 使用的通讯协议。当前支持文本协议(plain,也是默认值),MySQL协议(mysql),直接交互(cli)。 使用plain协议时,请使用自带的obclient连接服务端。 使用mysql协议时,使用mariadb或mysql客户端连接。 直接交互模式(cli)不需要使用客户端连接,因此无法开启多个连接。 |

| -t | 事务模型。没有事务(vacuous,默认值)和MVCC(mvcc)。 使用mvcc时一定要编译支持并发模式的代码。 |

| -T | 线程模型。一个连接一个线程(one-thread-per-connection,默认值)和一个线程池处理所有连接(java-thread-pool)。 |

| -n | buffer pool 的内存大小,单位字节。 |

更多

observer还提供了一些其它参数,可以通过./bin/observer -h查看。

FAQ

- 运行observer出现找不到链接库

A: 由于安装依赖时,默认安装在

/usr/local/目录下,而环境变量中没有将这个目录包含到动态链接库查找路径。可以将下面的命令添加到 HOME 目录的.bashrc中:

export LD_LIBRARY_PATH=/usr/local/lib64:$LD_LIBRARY_PATH

然后执行 source ~/.bashrc 加载环境变量后重新启动程序。

LD_LIBRARY_PATH 是Linux环境中,运行时查找动态链接库的路径,路径之间以冒号':'分隔。

将数据写入 bashrc 或其它文件,可以在下次启动程序时,会自动加载,而不需要再次执行 source 命令加载。

NOTE: 如果你的终端脚本使用的不是bash,而是zsh,那么就需要修改 .zshrc。

搭建开发环境

MiniOB 当前可以在Linux/MacOS上编译,所以开发环境最好是Linux或者MacOS。Windows上可以使用WSL2,或者使用Docker。这里有几个文档,大家可以参考并选择自己的开发环境。另外,很多同学喜欢使用visual studio code开发,MiniOB 中也将vscode的一些配置文件放在了仓库中,比如 .vscode/tasks.json 和 .vscode/launch.json,可以参考使用。

- 使用 GitPod 开发 MiniOB

- 开发环境搭建(本地调试, 适用 Linux 和 Mac)

- 开发环境搭建(远程调试, 适用于 Window, Linux 和 Mac)

- Windows 使用Docker开发MiniOB

- 手把手教你在windows上用docker和vscode配置环境

- 使用Docker开发MiniOB

- MiniOB 调试

MiniOB 是 OceanBase 联合华中科技大学推出的一款用于教学的小型数据库系统,希望能够帮助数据库爱好者系统性的学习数据库原理与实战。

本篇文章介绍如何使用 GitPod 开发 MiniOB。 也可以参考这篇文章了解如何使用 Visual Studio Code 来开发调试 MiniOB。

GitPod 简介

GitPod 是一个能让我们在任何地方都能方便开发自己代码的云平台。在开发时,GitPod会提供一个虚拟机一样的开发环境,开发平台是Linux,并且GitPod可以直接打开GitHub项目,支持很多IDE,比如Visual Studio Code、Clion、VIM等。

本篇文章将介绍如何在GitPod上使用Visual Studio Code(浏览器版)来开发MiniOB。

在 GitPod 上开发自己的 MiniOB

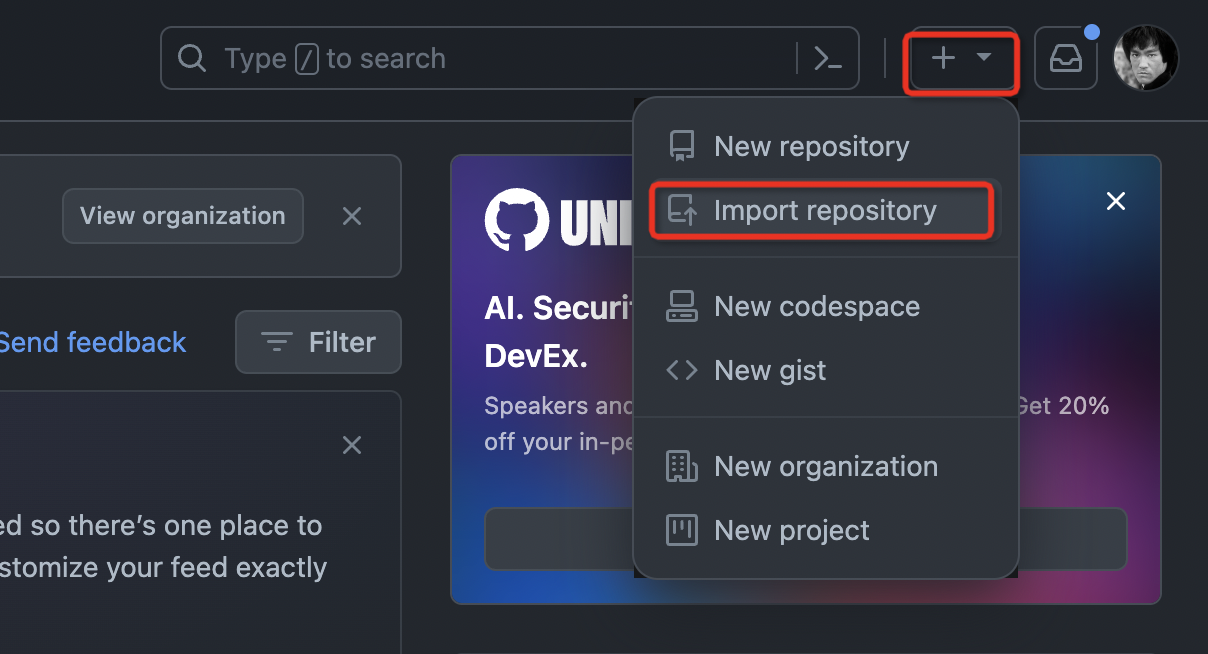

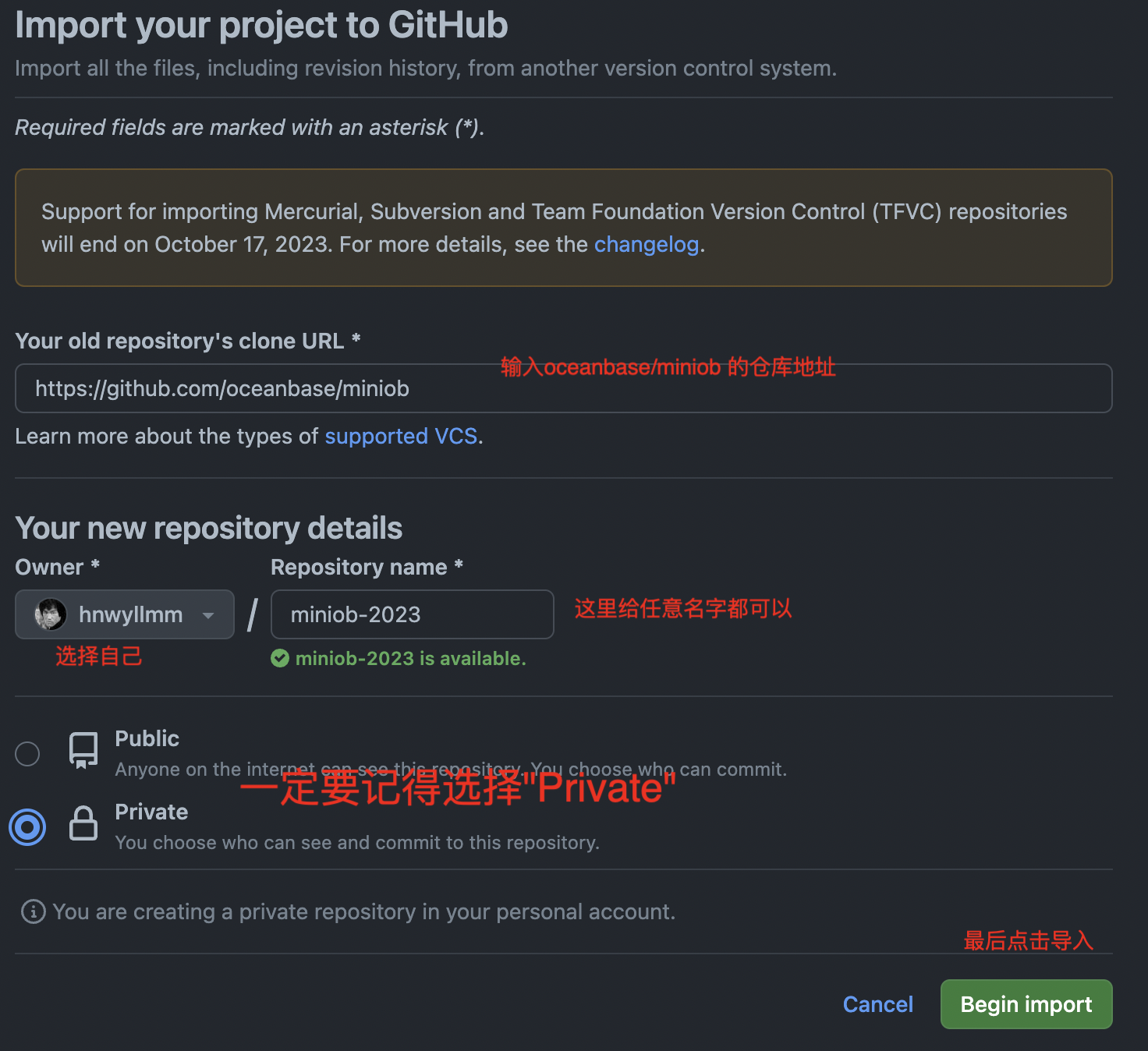

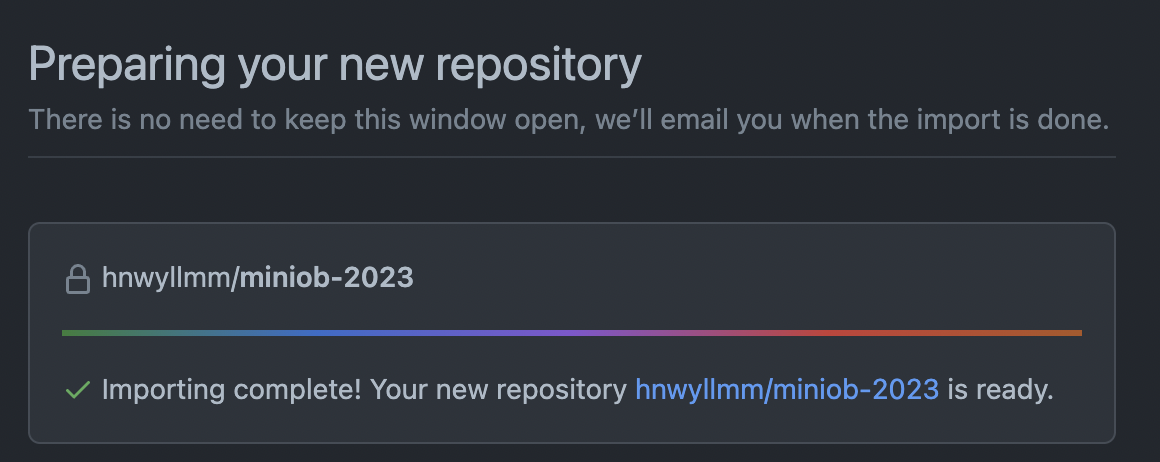

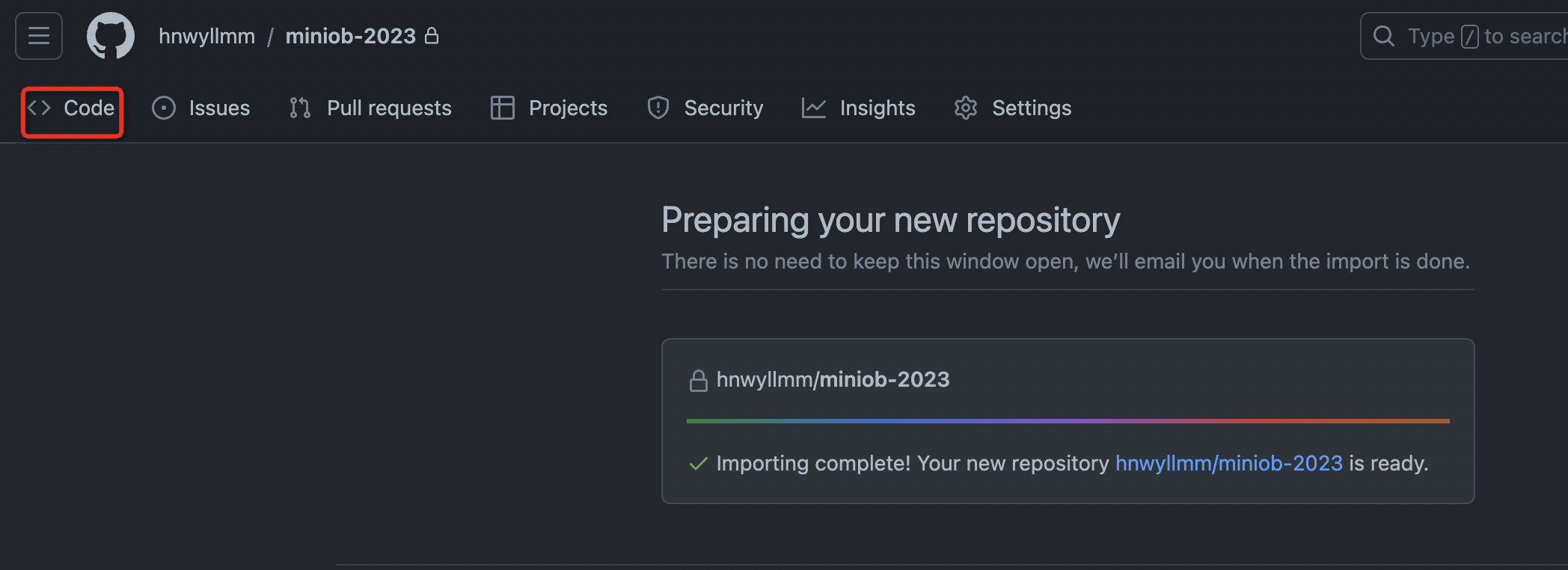

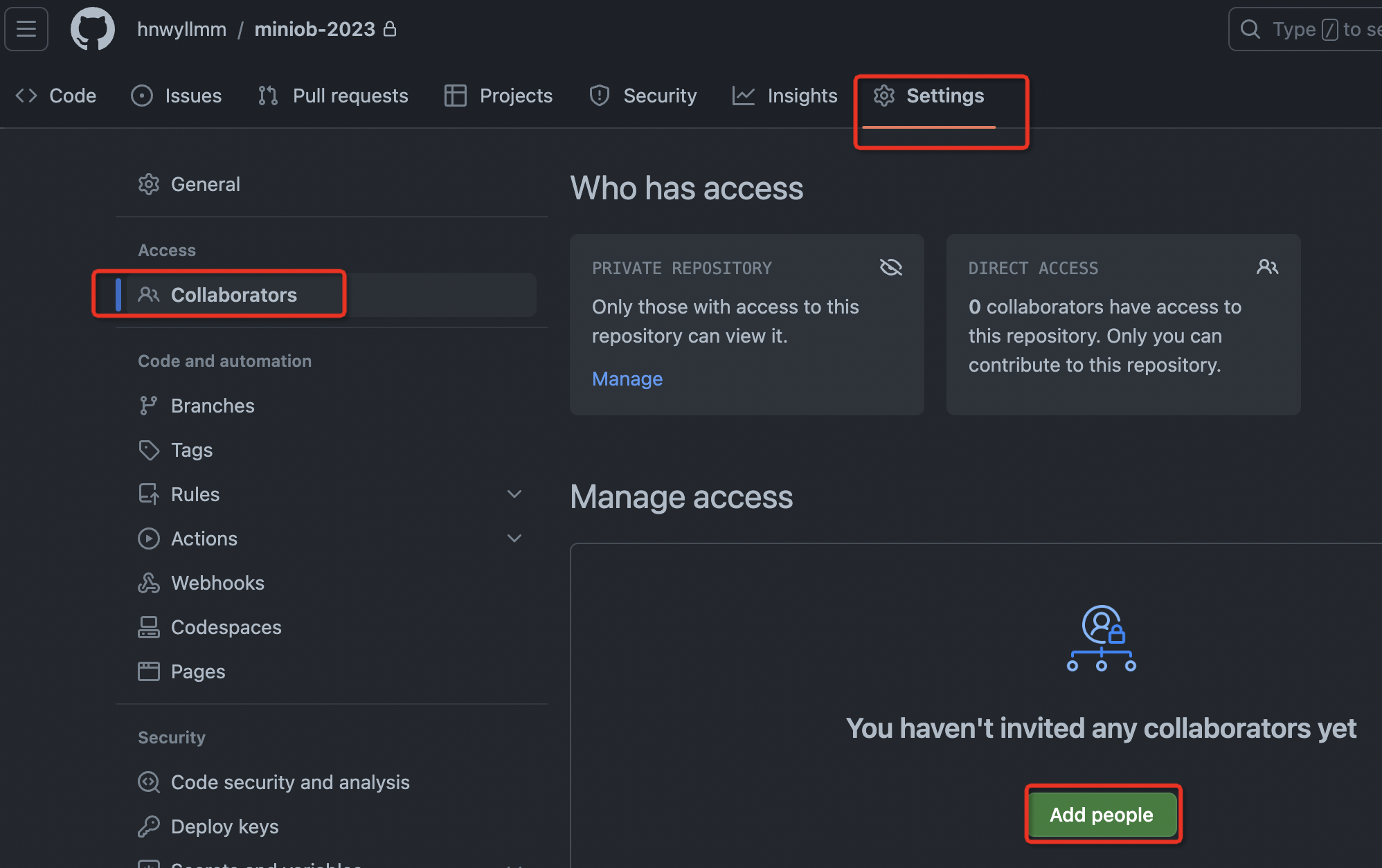

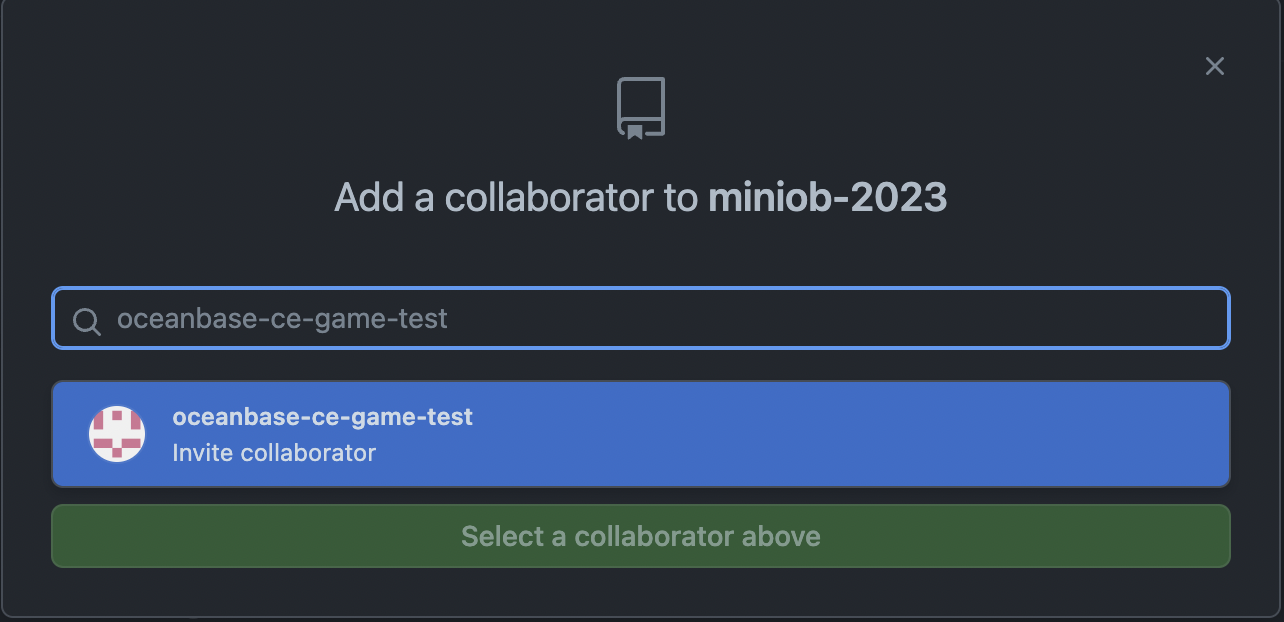

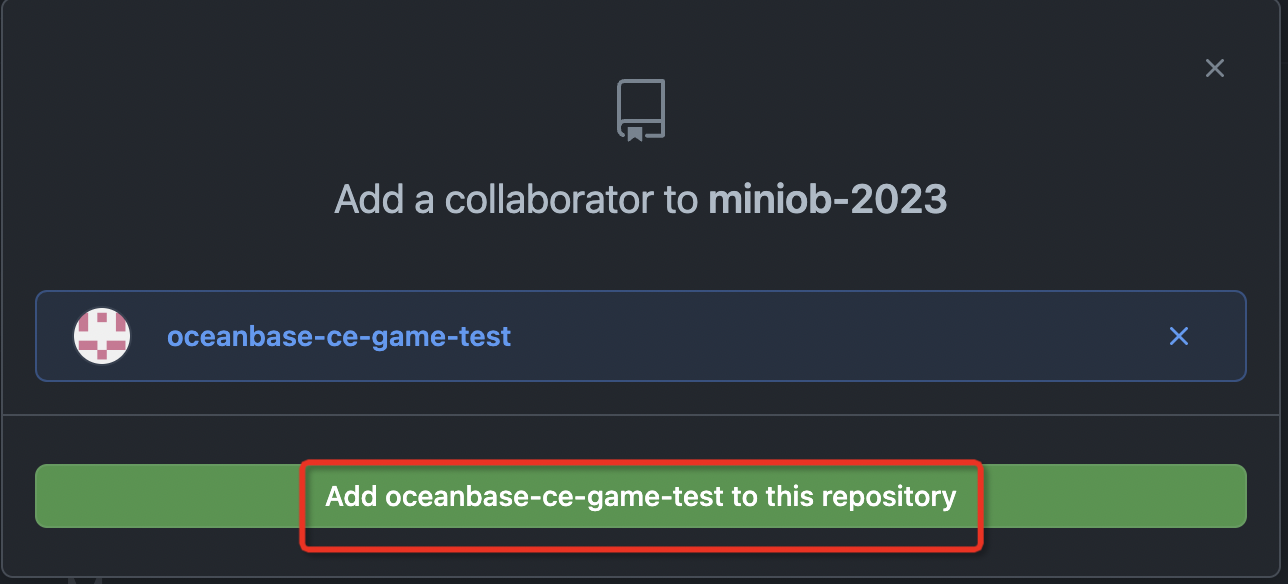

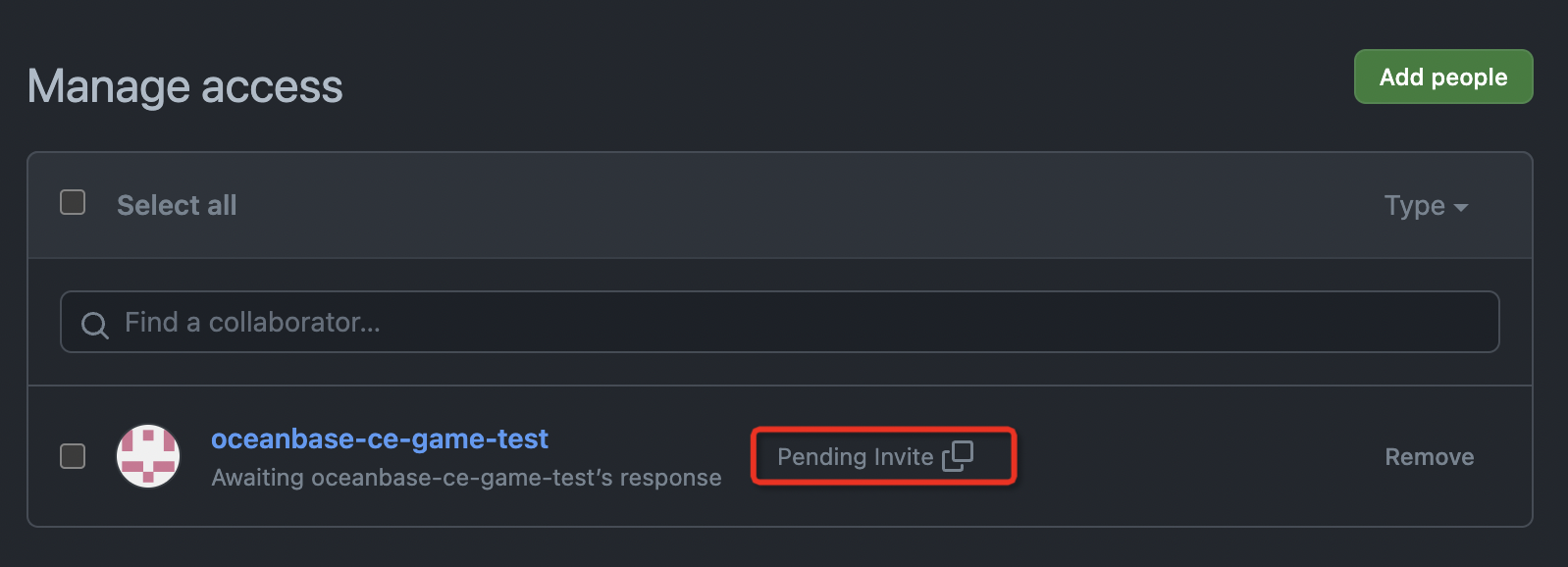

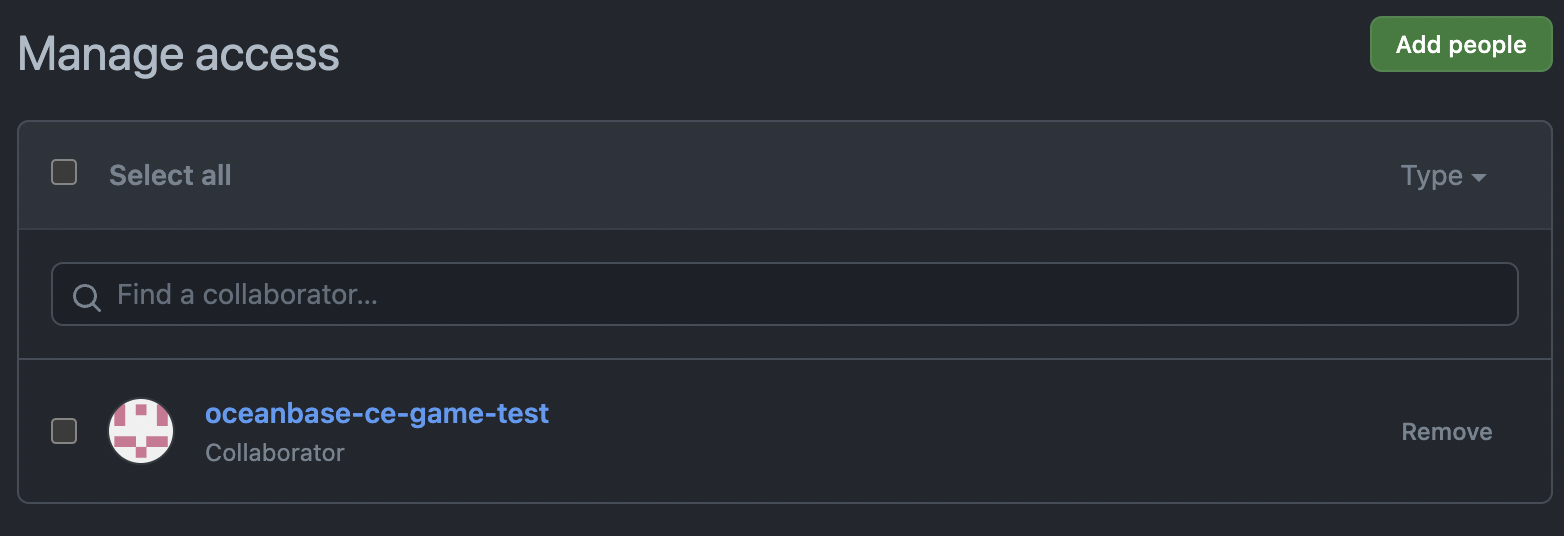

创建自己的GitHub项目

在开发MiniOB之前,应该先在GitHub上将MiniOB放在自己的私有仓库中。为了方便演示,我这里直接使用fork的方式,在自己的个人仓库中创建一个共有(public)仓库。

在浏览器中打开 MiniOB 然后fork仓库

fork后就会在自己的个人名下有一个miniob仓库代码

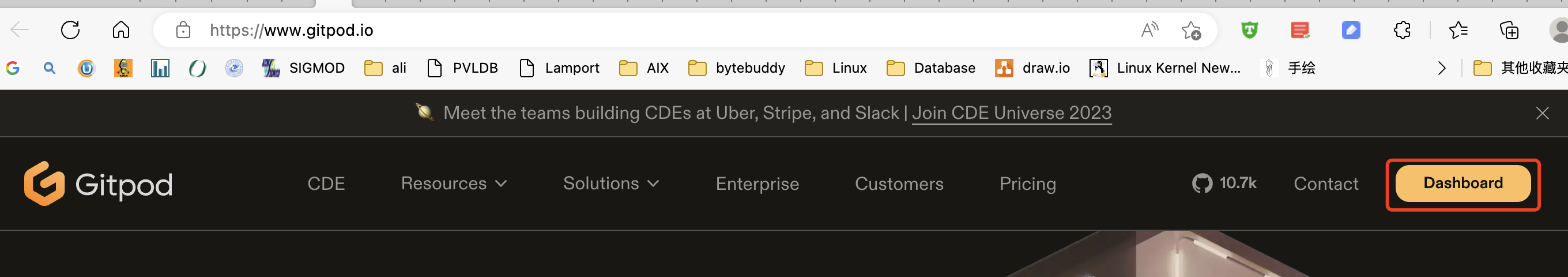

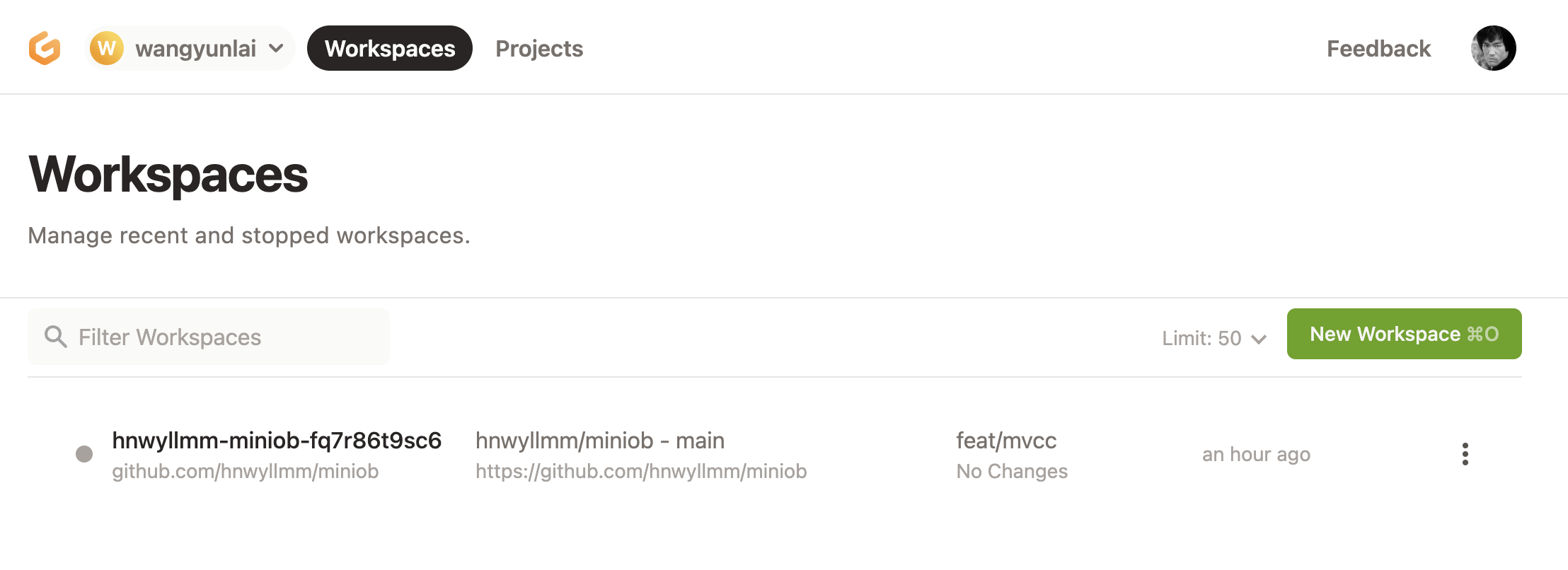

在 GitPod 上打开自己的项目

使用 GitPod 打开自己的项目

如果是第一次使用,需要输入一些额外的信息,按照GitPod的引导来走就行,最终会引导你打开你的项目。

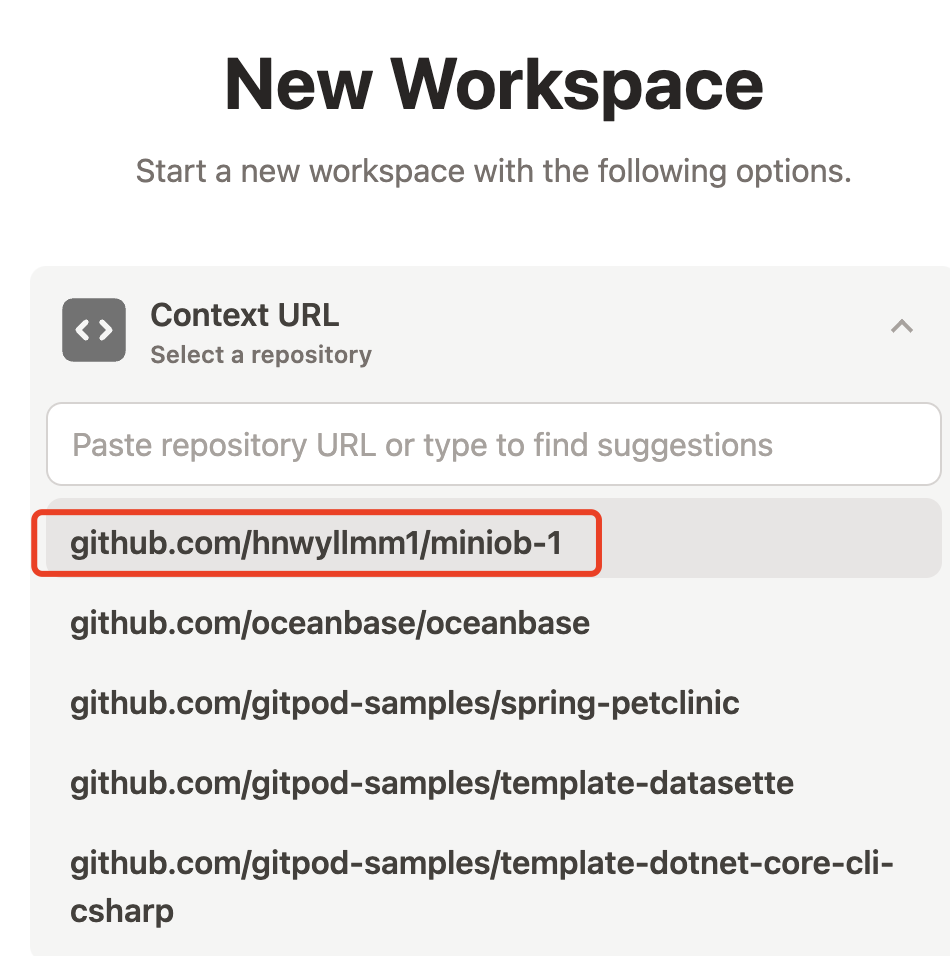

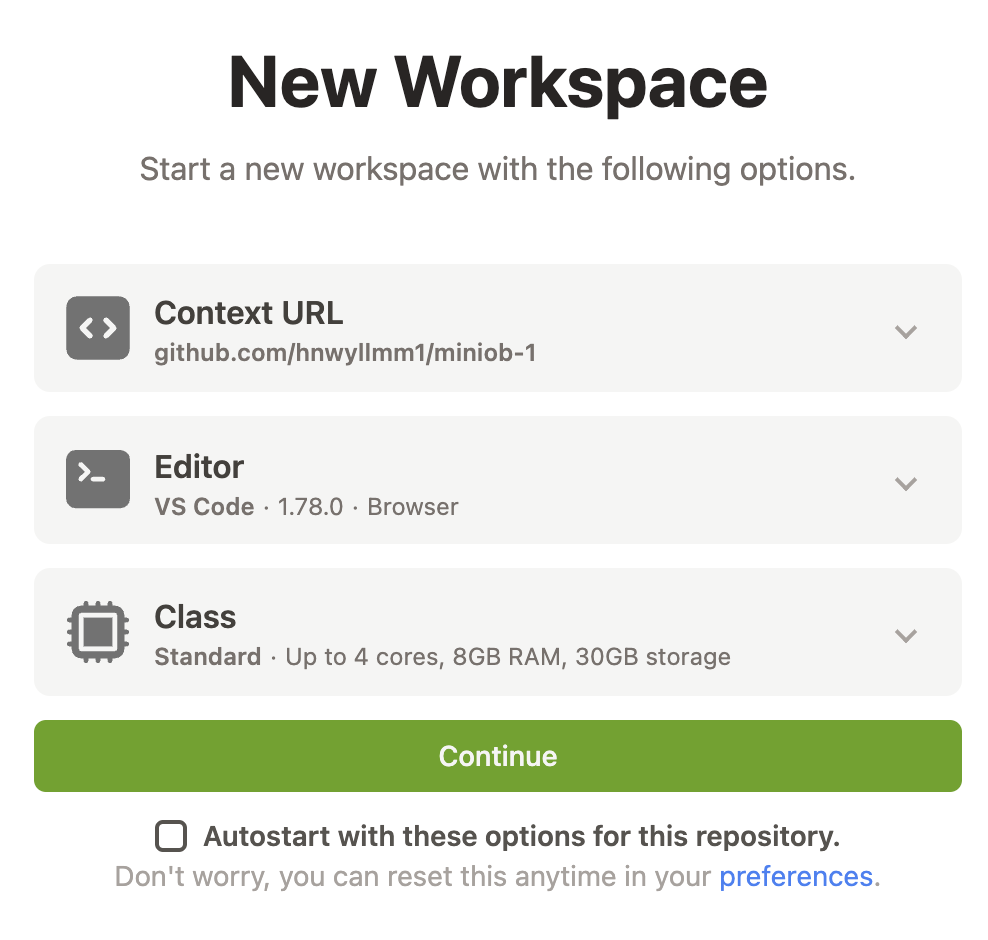

这里选择自己的代码项目,并且使用vscode浏览器版本,容器规格也选择最小的(最小的规格对miniob来说已经非常充足)

如果以前已经操作过上面的步骤,可以直接从gitpod的首页找到自己的项目。

代码构建

环境初始化

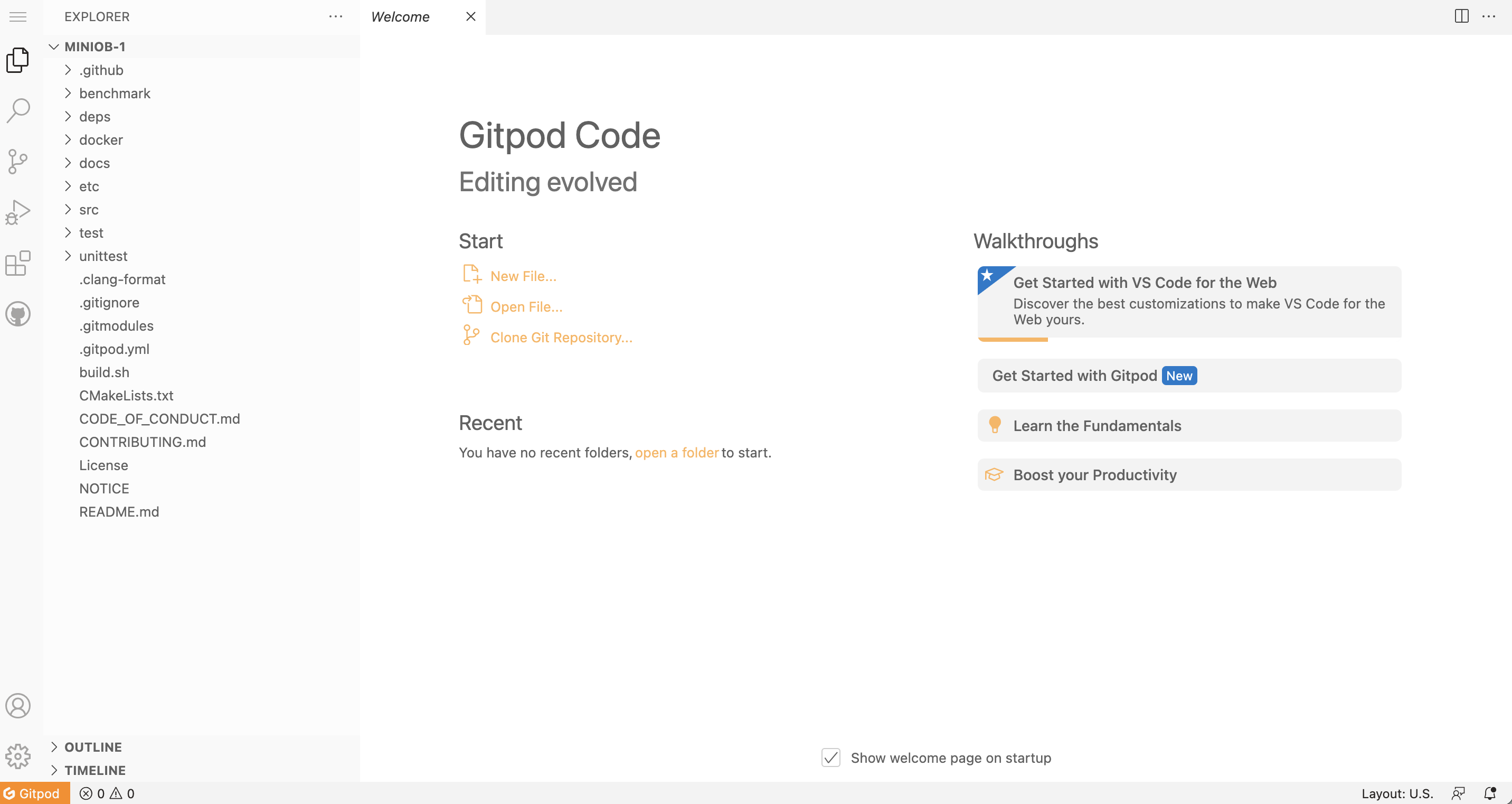

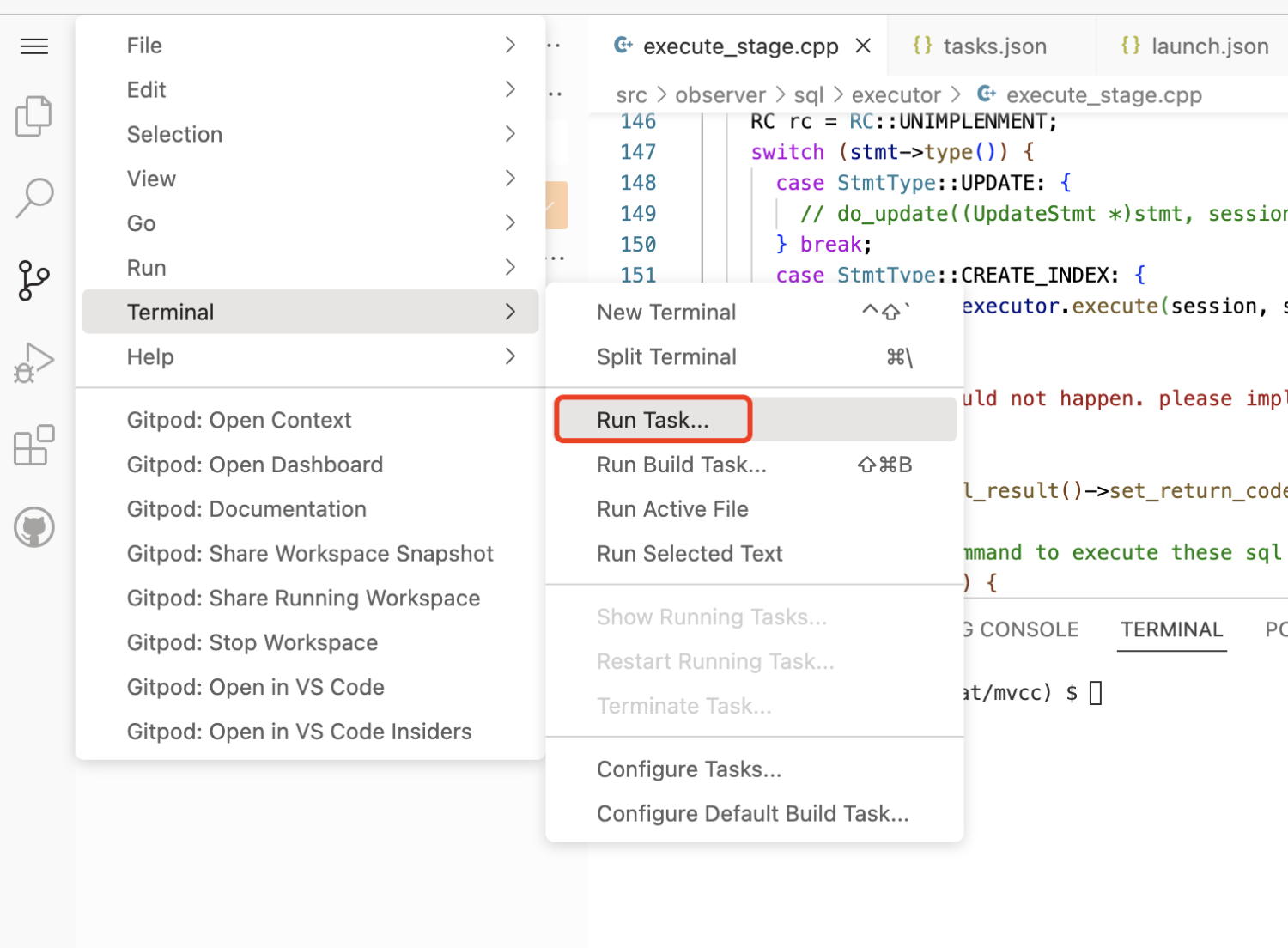

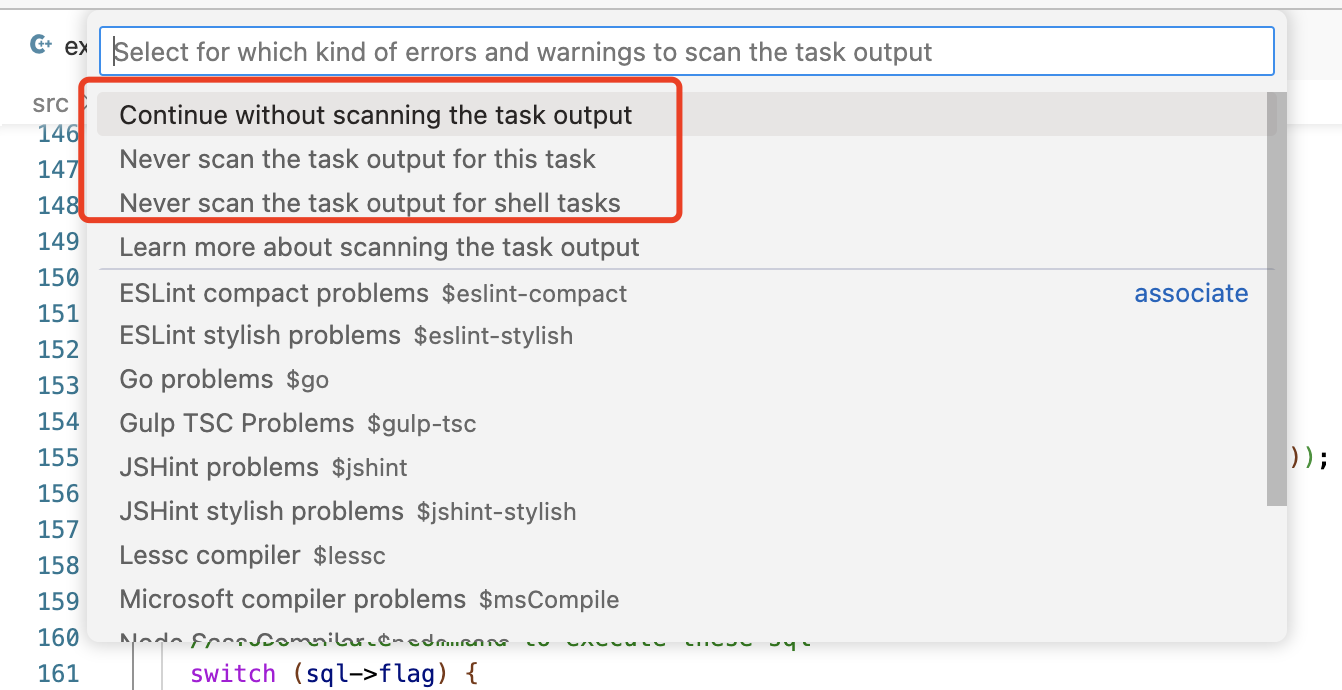

因为MiniOB当前已经将.vscode文件加入到项目中,所以可以直接使用当前已有的一些命令(task)来构建代码。

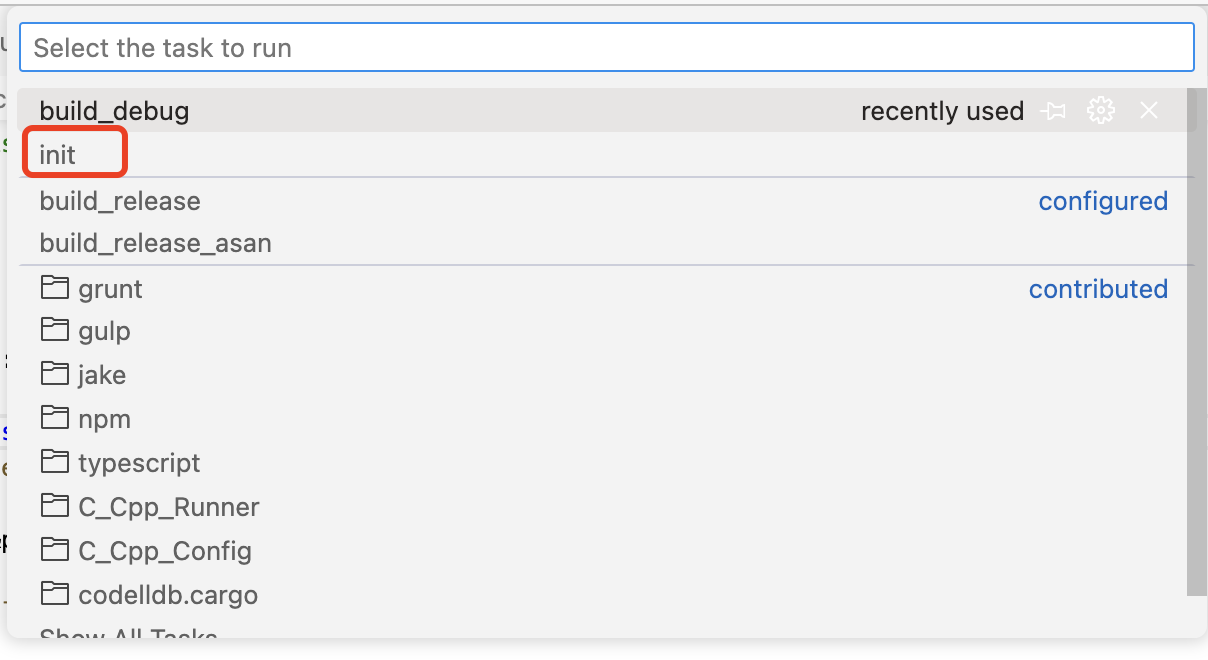

如果是一个全新的机器环境,那么先要运行 init 任务。init 任务会在当前的机器上安装一些依赖,比如 google test、libevent等。

NOTE: gitpod 项目启动时,就会自动运行初始化。如果没有运行,可以手动执行一下。可以参考 .gitpod.yml 文件

编译miniob

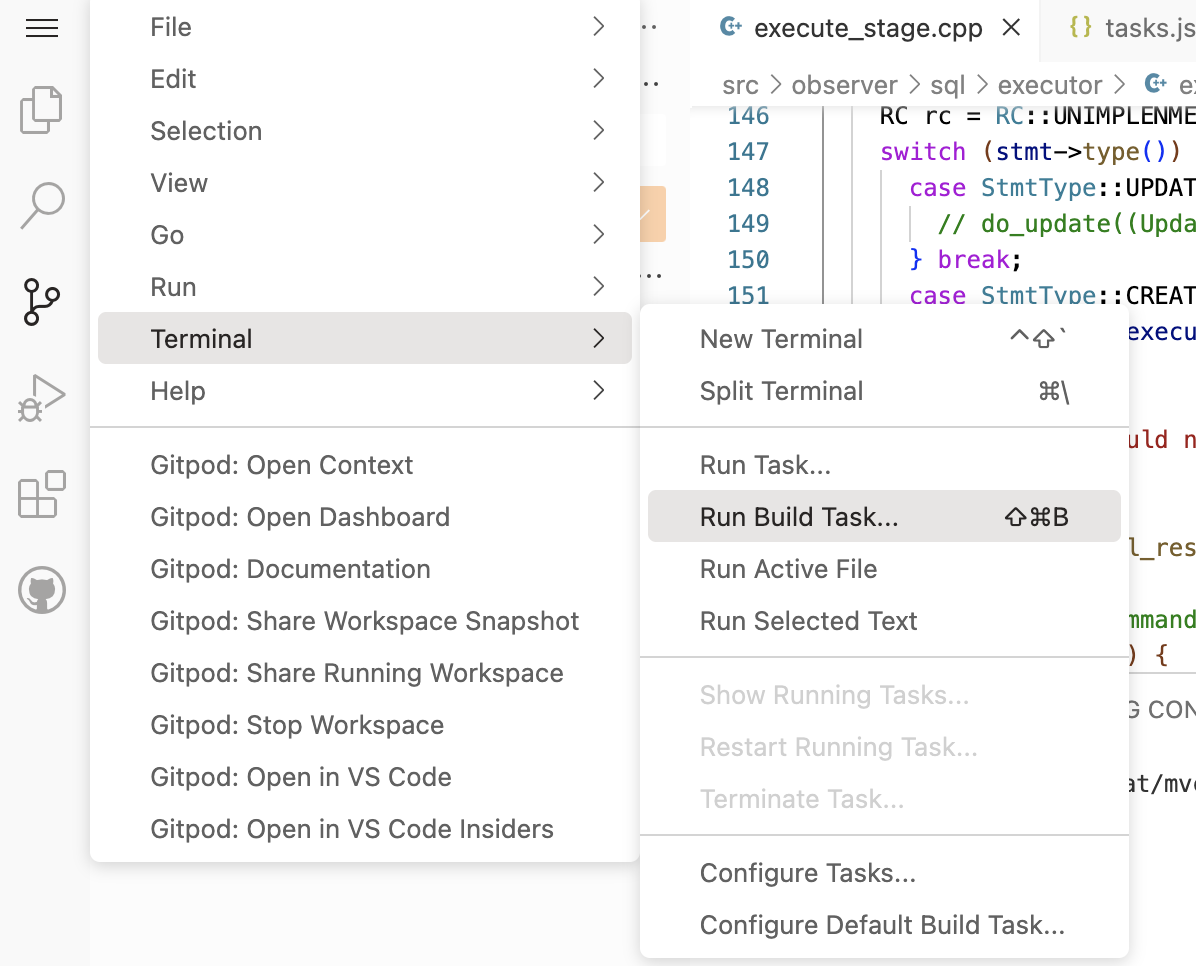

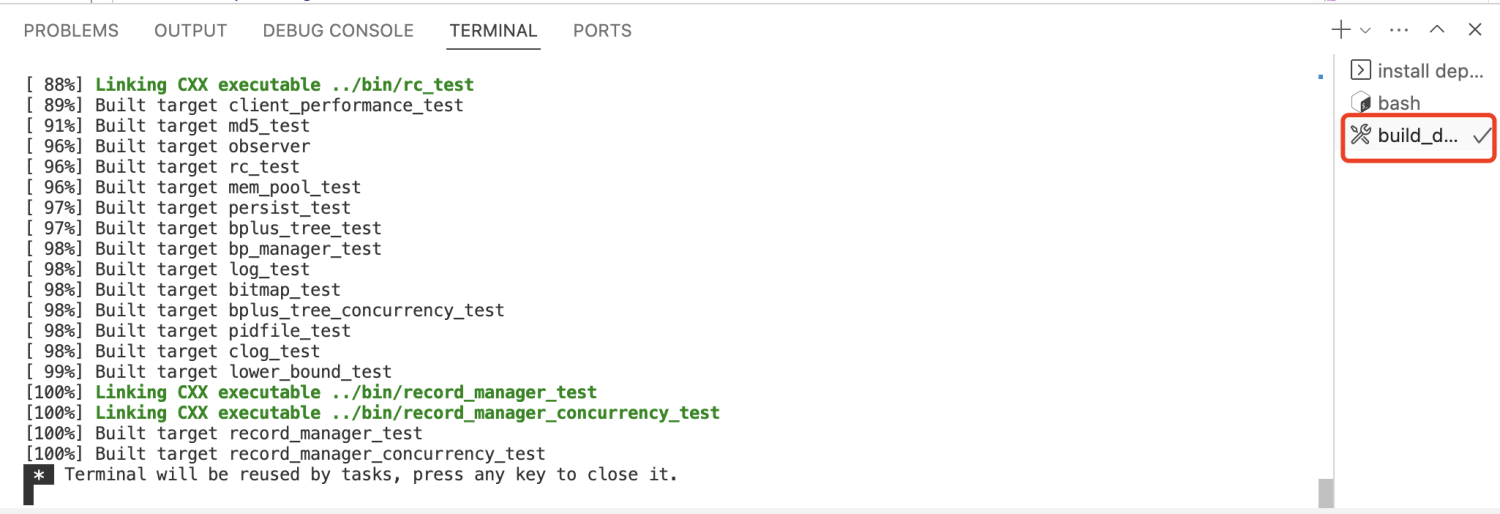

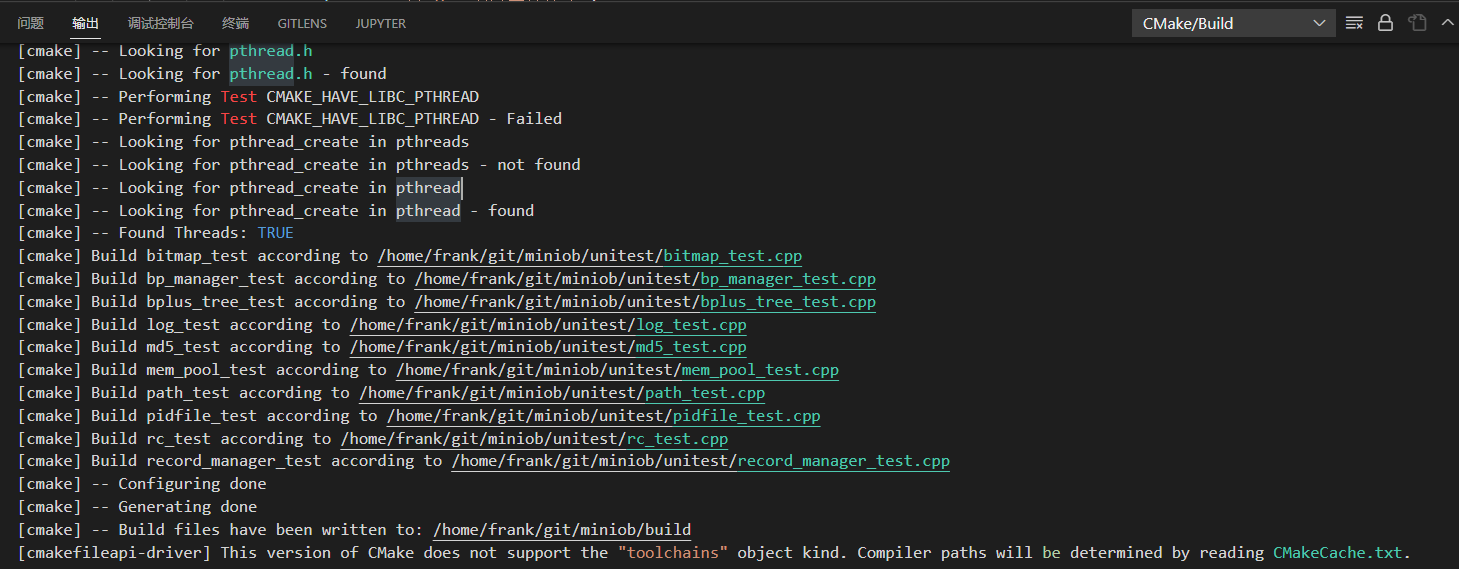

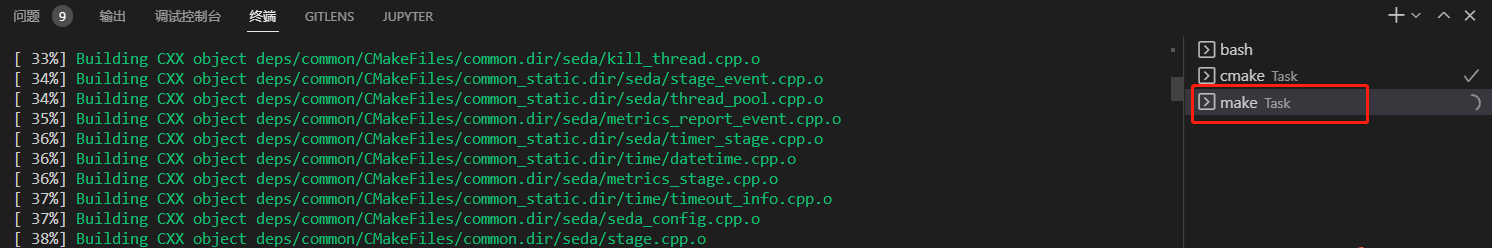

初始化完成,可以运行 Build 任务,即可构建。

这些构建方法,也可以通过命令行的方式手动执行。

所有的任务都可以从这里找到入口。

运行 init 命令的入口。

运行构建(编译)的入口。需要设置默认构建的任务,vscode才能运行。这里已经设置过了。

构建(编译)时,会有一些输出,如果有编译错误,也可以直接使用鼠标点击跳转到错误的地方。

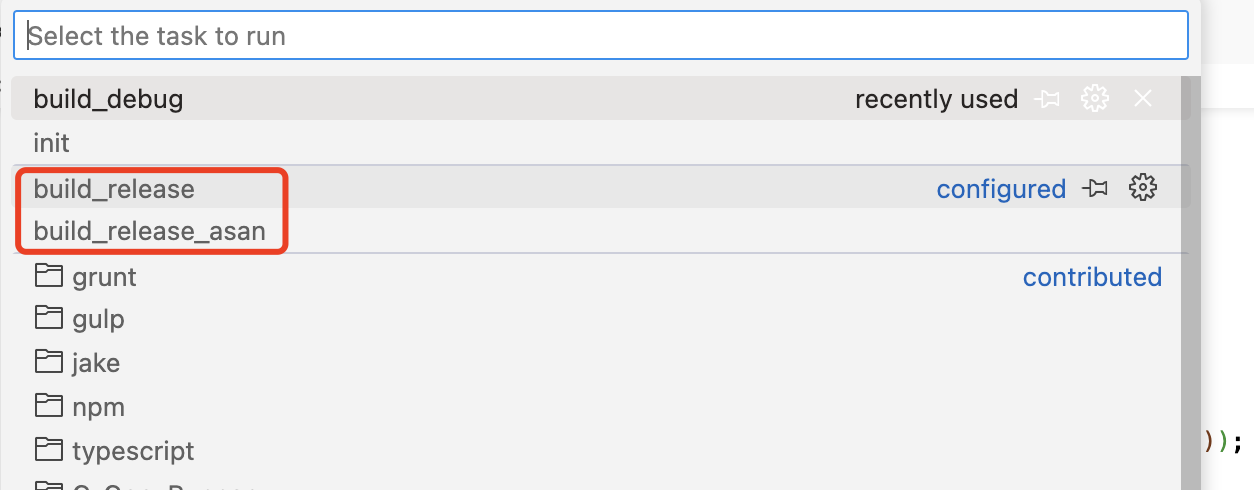

还可以构建其它模式。

WARNING: 不要在gitpod的终端上,执行 sh build.sh,而是执行 bash build.sh 或者直接运行 ./build.sh

miniob 虽然是cmake功能,可以使用vscode带的cmake配置,但是miniob在编译时,会使用一些变量来控制编译什么版本,比如是否编译UNITTEST,是否开启ASAN等。因此这里使用build.sh脚本来简化项目的编译命令。

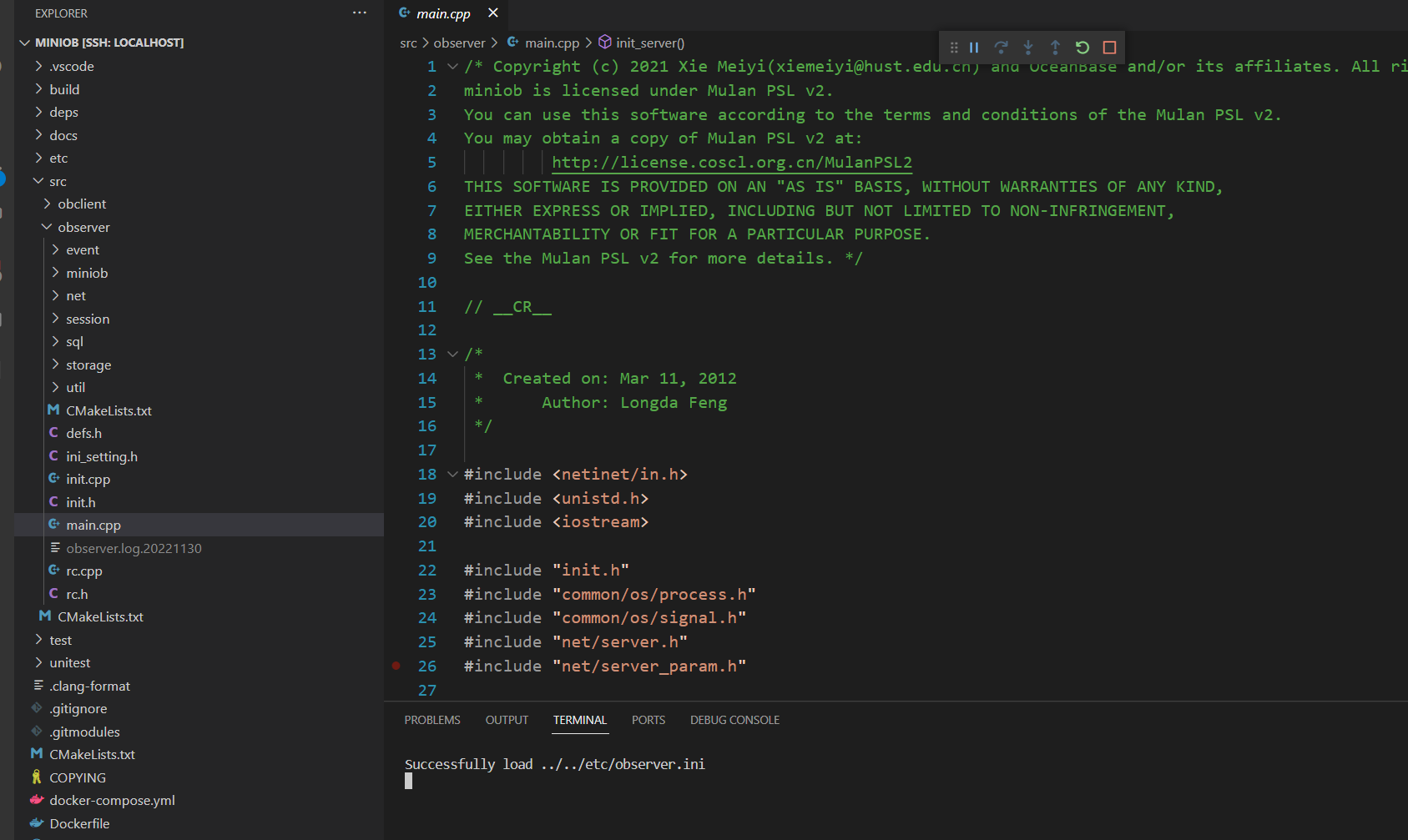

代码调试

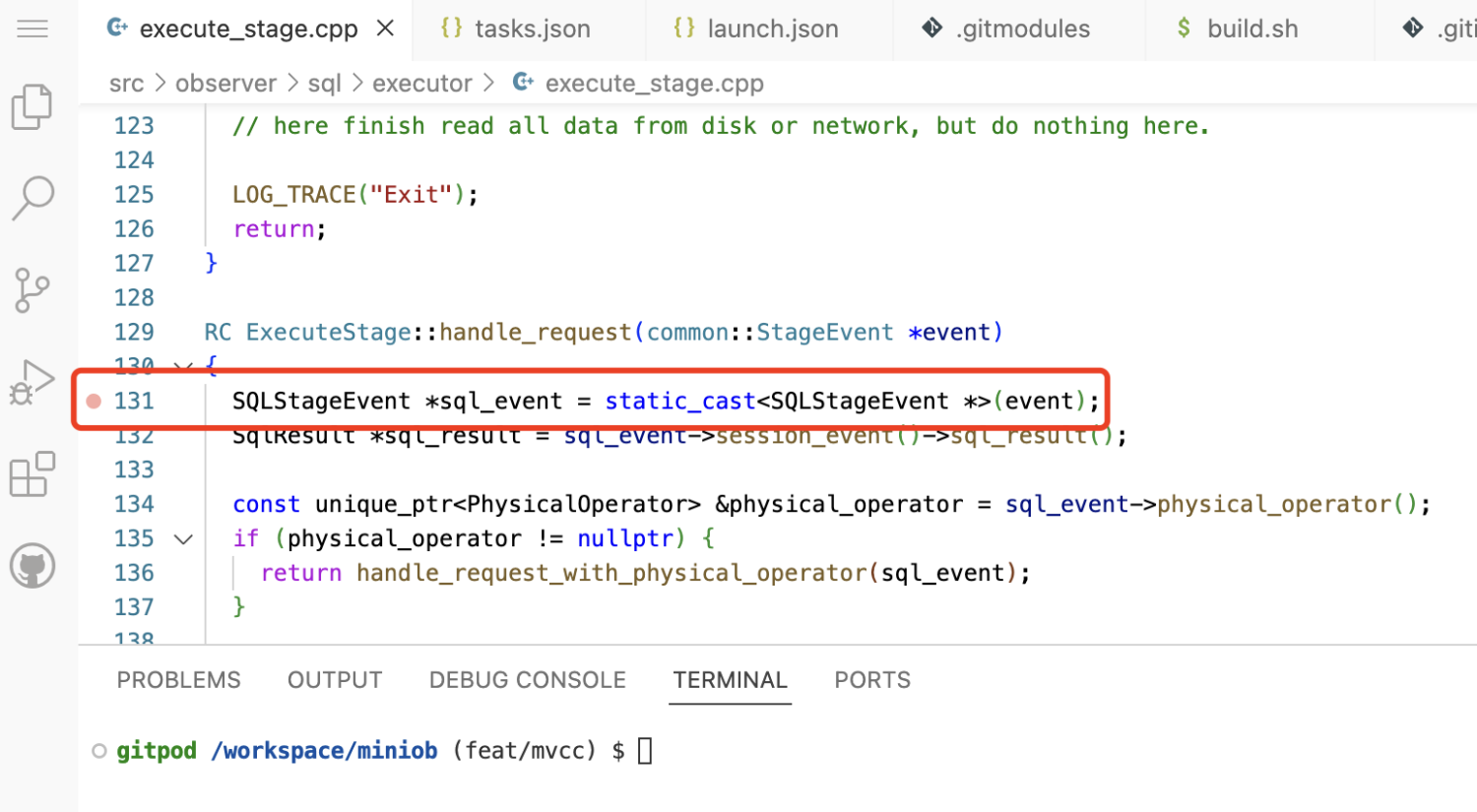

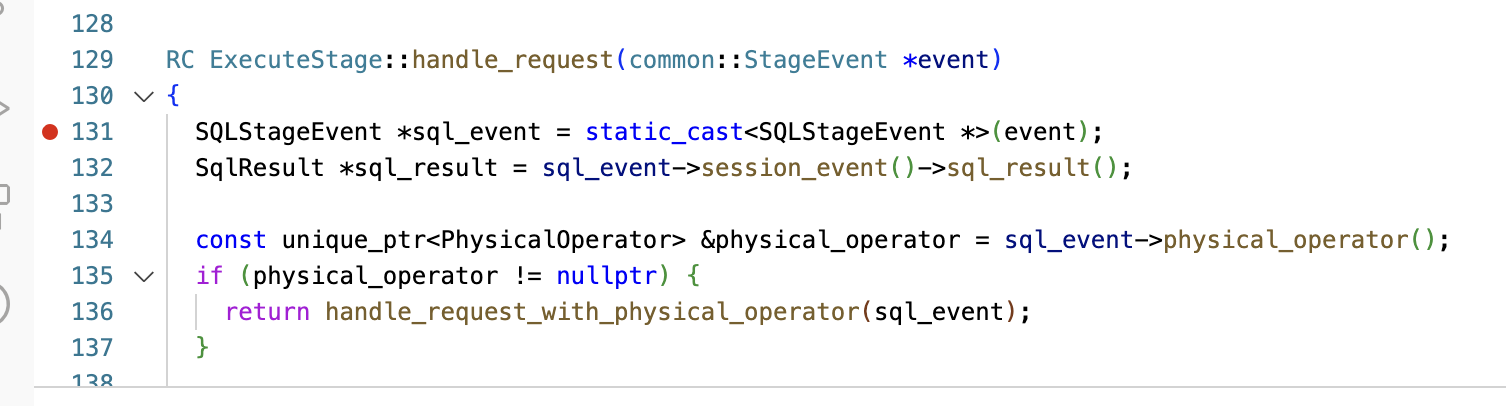

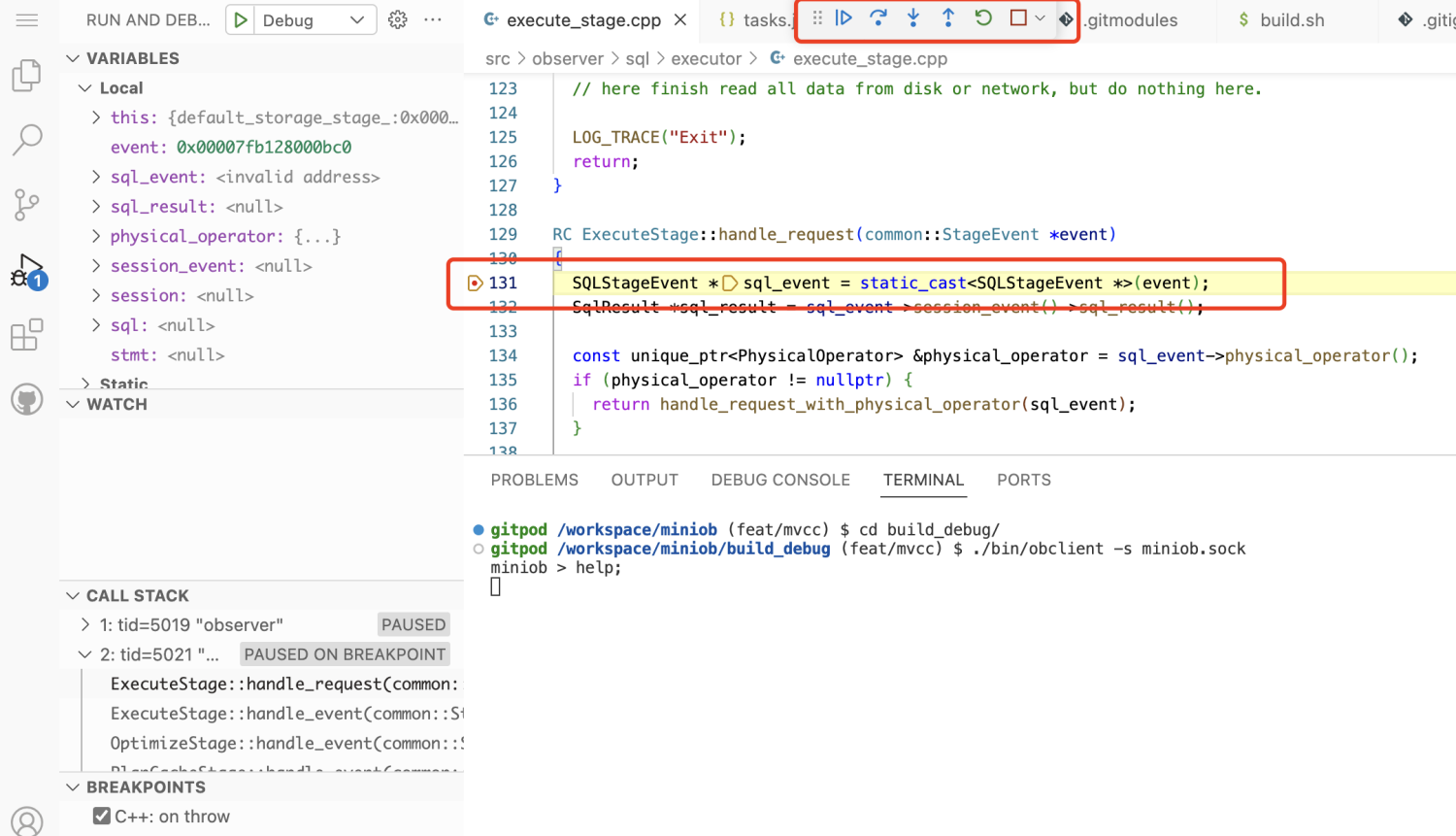

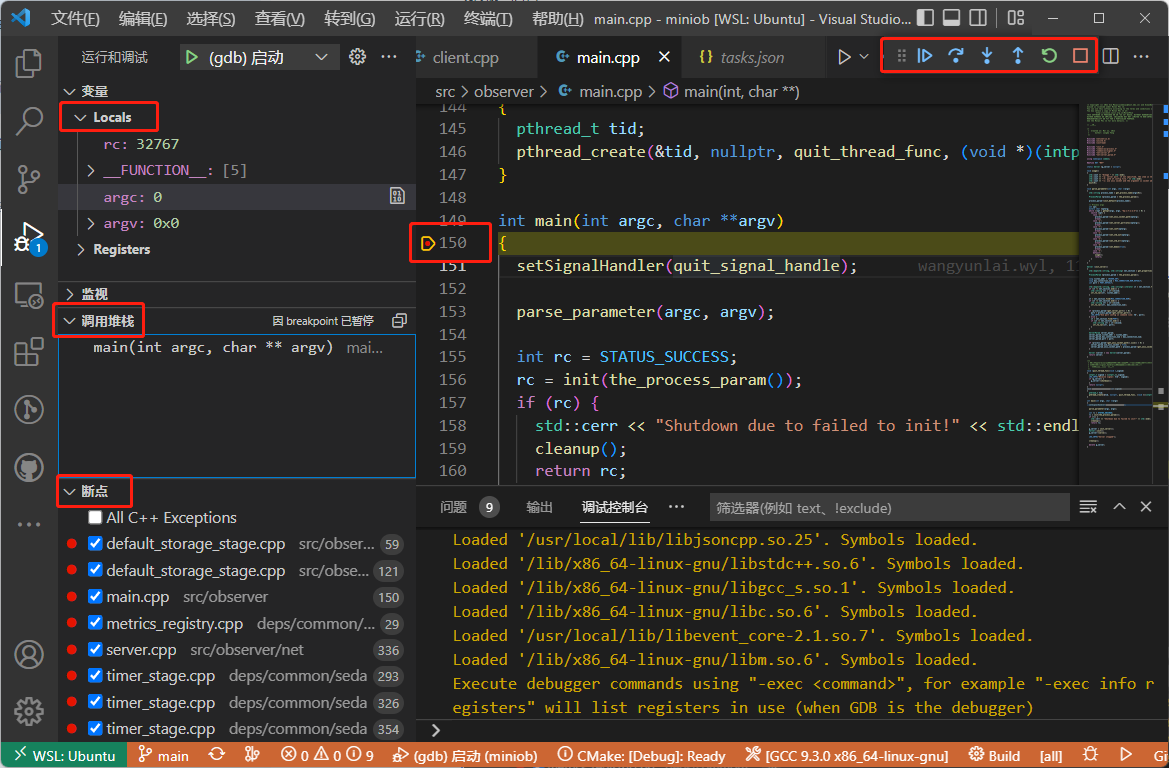

与代码构建类似,MiniOB 可以支持在vscode中直接启动调试程序。启动的调试程序为默认构建项目,当前是 debug 模式编译的miniob。 与普通的调试类似,可以自行设置断点。断点可以在运行程序之前也可以在其后。 启动调试服务端后,打开一个新的终端,来运行客户端,以便向服务端发起命令。

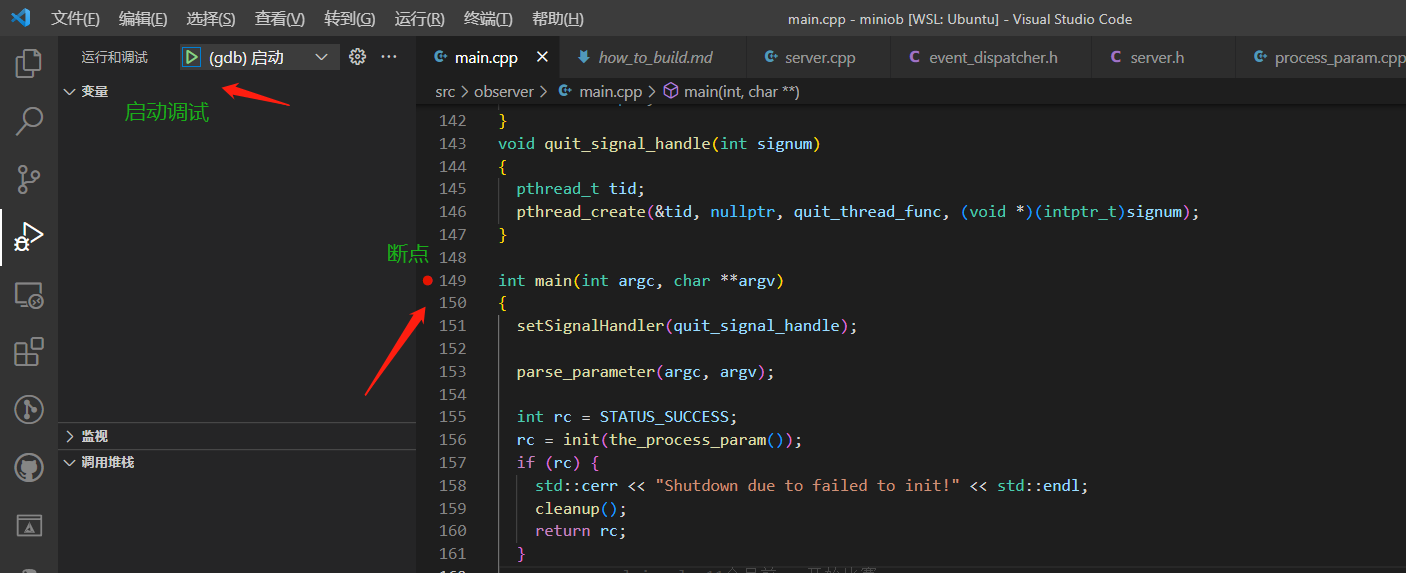

下断点

光标放到某一行,vscode编辑框的左边就会出现一个粉红色的圆点,点击圆点就可以下断点

圆点变成红色,断点下成功了。

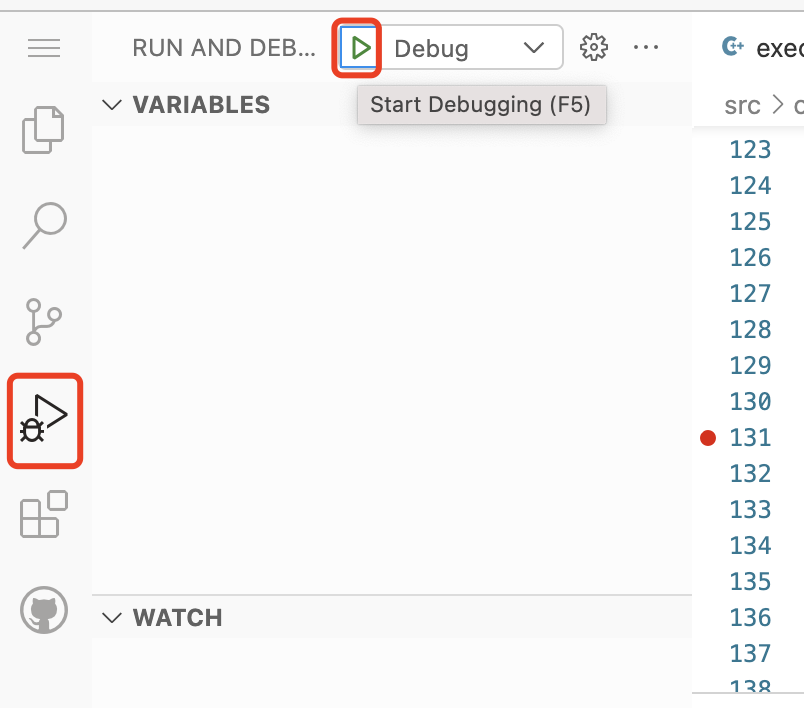

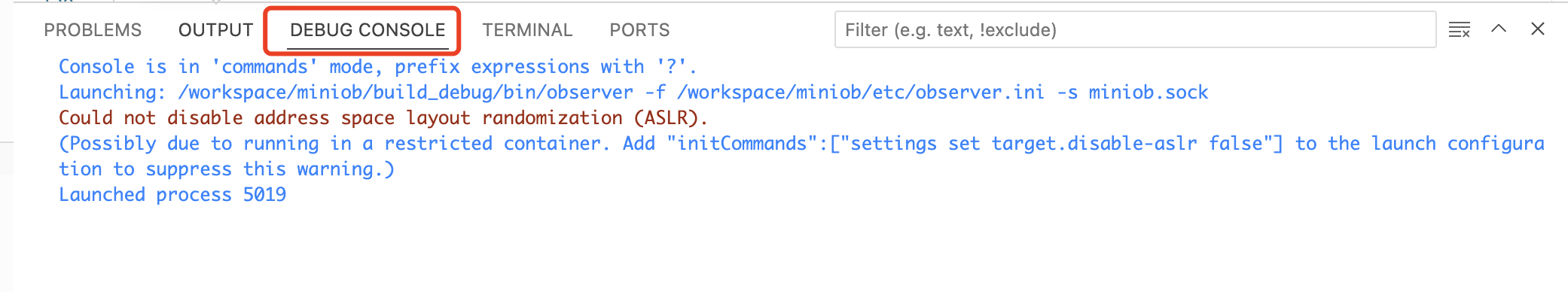

启动调试

vscode 为调试进程也创建了一个终端,可以在这里看到observer运行期间在控制台上的输出。

调试时显示的界面。可以看到最上面中央处,有一个调试的界面,可以执行单步调试,或者跳转到函数内。这与普通的调试器界面类似。左边有一些变量的展示。

另外,我这里开了一个终端,运行客户端连接服务端发起命令请求。

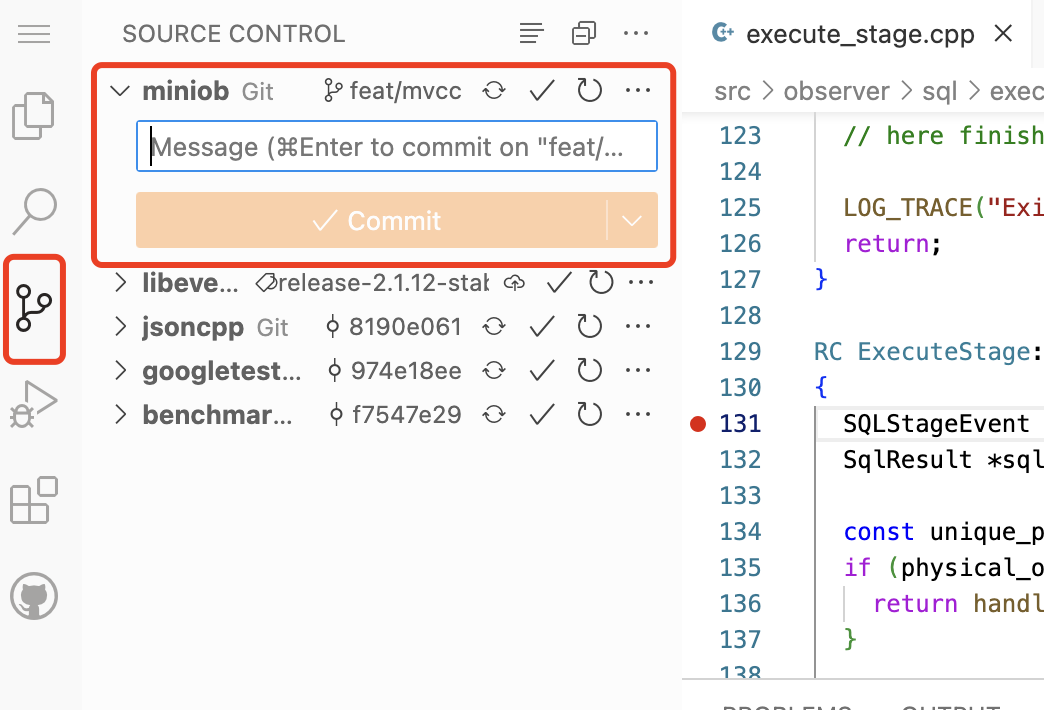

代码提交

作为一个GitHub项目,一个功能或者BUG开发完成后,需要将代码推送到远程仓库。vscode已经集成了GitHub和git插件,可以方便的进行操作。

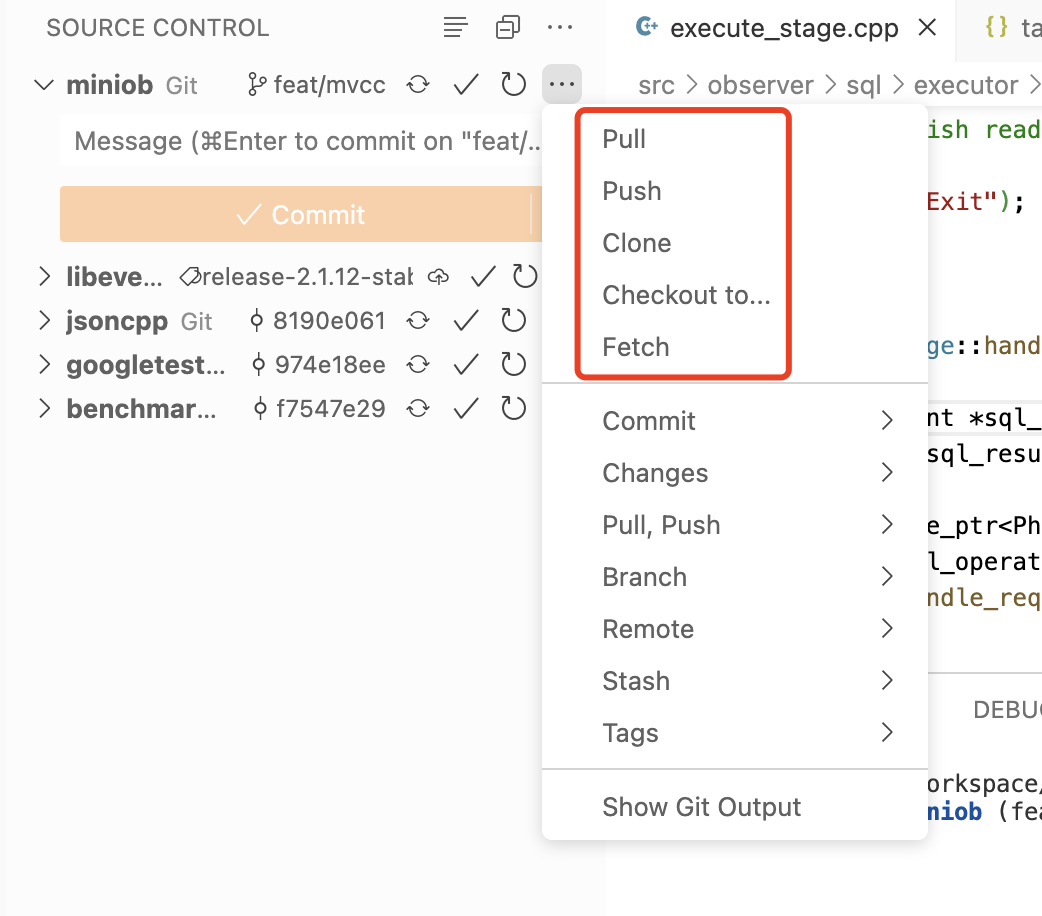

完成一个功能,就提交一次。这里输入commit message后直接提交即可。

注意这里仅仅提交到了本地,如果要提交到GitHub(远程仓库),需要执行”推送“,即 git push。

Git的其它操作链接在这里

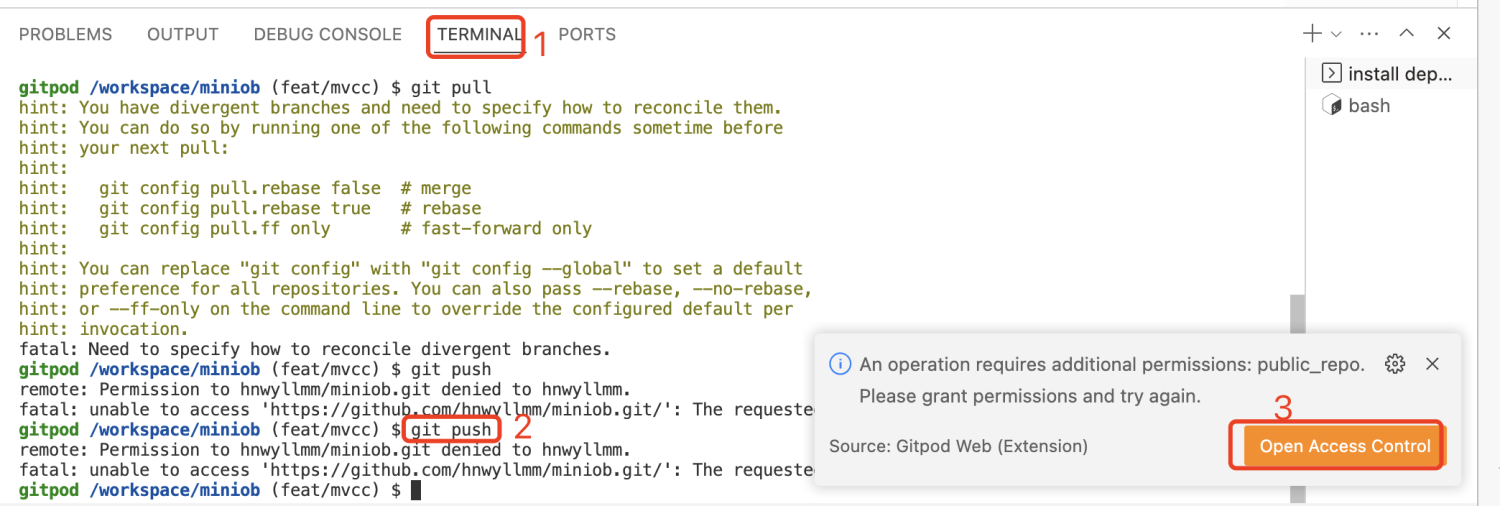

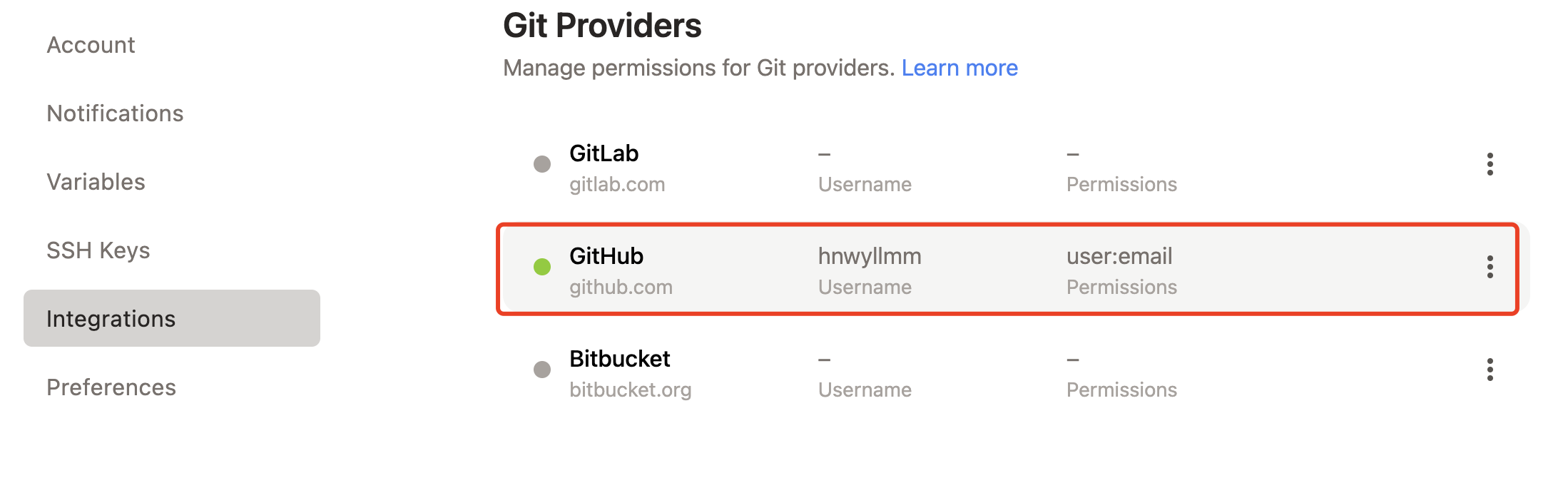

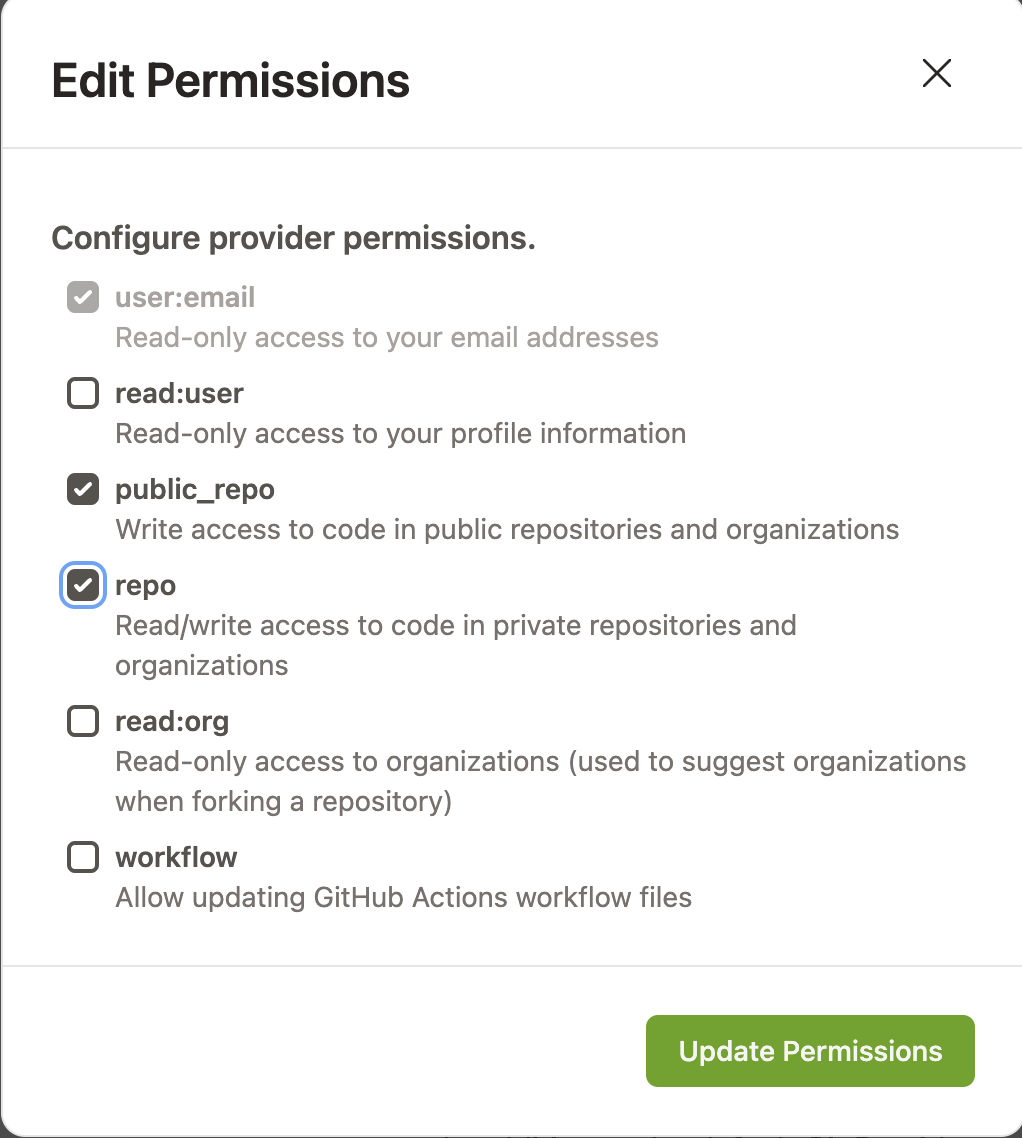

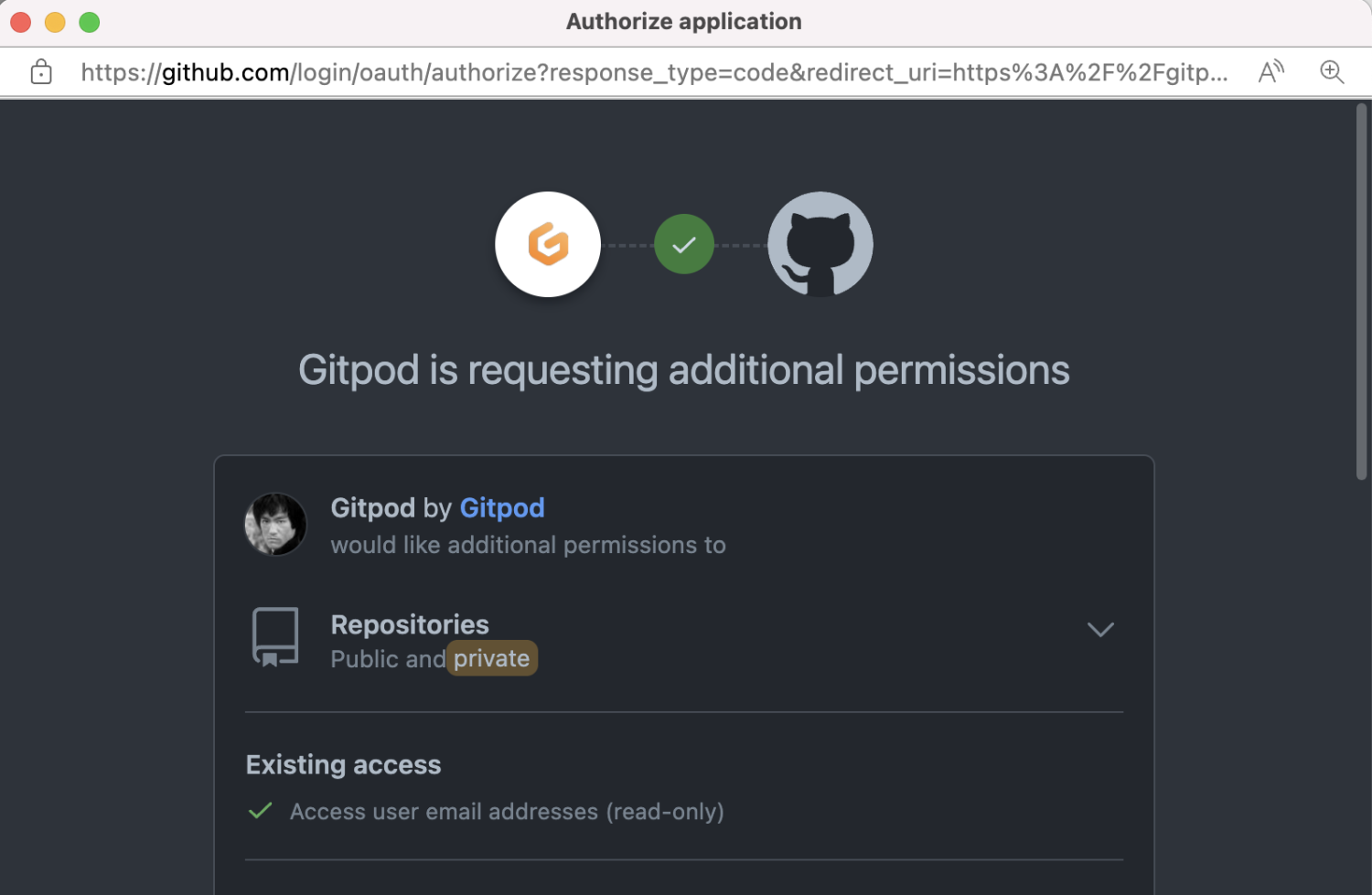

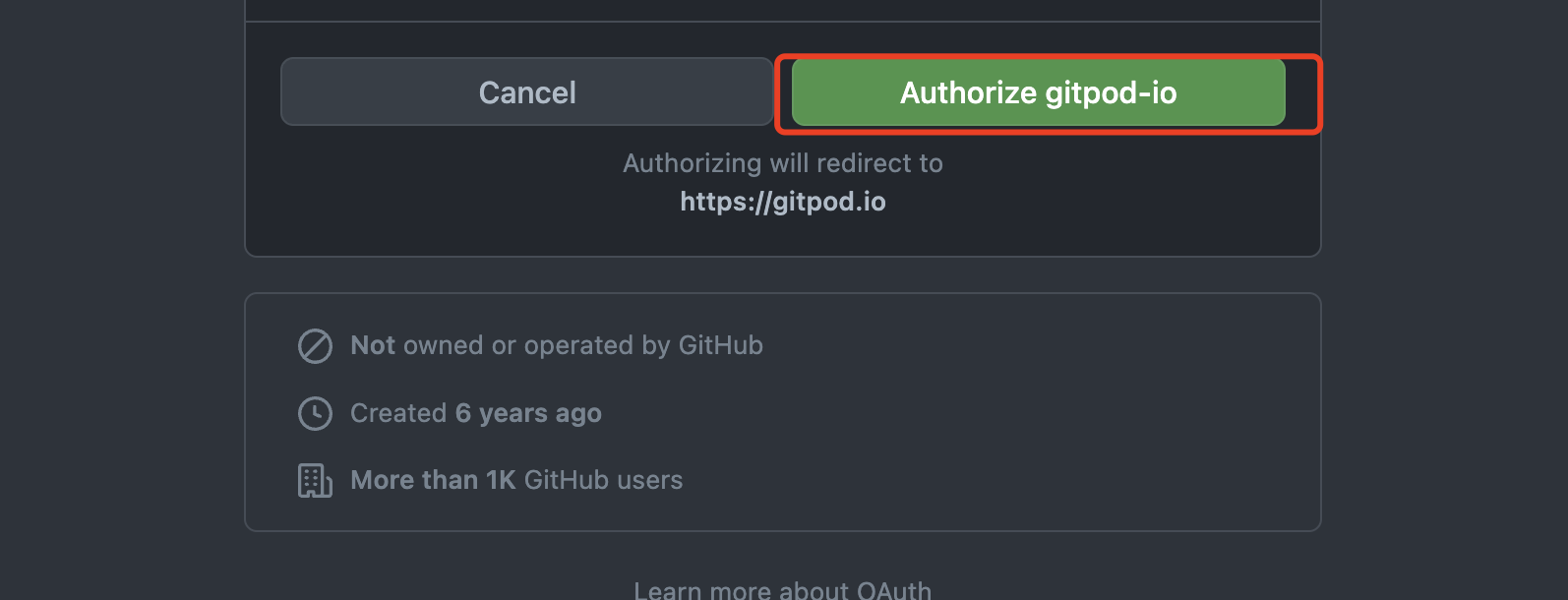

如果推送时出现这样的错误,可能是没有权限。gitpod 会自动提示然后跳转过去设置权限即可。

我这里就是没有写权限,所以无法推送到远程仓库。

信息介绍

MiniOB 中的 tasks

vscode 可以非常方便的运行任务(task)来运行预配置的命令,比如shell。 miniob 的编译也可以通过脚本来执行(build.sh)。这里预配置了几个编译任务,可以按需自取,也可以按照需要,增加新的配置,运行自己的参数。

下面是一个 debug 模式编译的示例,也是vscode工程默认的Build配置。这里做个简单介绍,以方便大家有需要的时候,修改配置满足自己需要。 其中

label是一个任务名字,在Run task的时候,可以看到type表示任务的类型。这里是一个shell脚本command这里是一个shell脚本的话,那command就是运行的命令,跟我们在终端上执行是一样的效果problemMatcher告诉vscode如何定位问题。这里不用设置,vscode可以自动检测group使用vscode将此任务设置为默认Build任务时,vscode自己设置上来的,不需要调整。

{

"label": "build_debug",

"type": "shell",

"command": "bash build.sh debug",

"problemMatcher": [],

"group": {

"kind": "build",

"isDefault": true

}

}

MiniOB 中的 launch

很多同学不习惯使用gdb的终端界面来调试程序,那么在 vscode 中调试miniob非常方便,与Visual Studio、Clion中类似,都有一个操作界面。 vscode中启动调试程序是通过launch.json来配置的,这里简单介绍一下主要内容。

下面是截取的一段关键内容。这里介绍一些关键字段

type当前调试使用哪种类型。这里是lldb (我个人习惯了gdb,但是我没有找到,也不想找了)name这里会显示在vscode调试窗口启动时的名字中program要调试的程序。对miniob来说,我们通常都是调试服务端代码,这里就是observer的路径。workspaceFolder 是当前工程的路径,defaultBuildTask 是默认构建的任务名称,与我们的构建路径刚好一致。observer 是编译完成安装在构建路径的bin下。args启动程序时的命令行参数。在终端上,大家也可以这么启动observer: `./bin/observer -f ../etc/observer.ini -s miniob.sockcwdobserver 运行时的工作目录,就是在observer程序中获取当前路径时,就会是这个路径。

{

"type": "lldb",

"request": "launch",

"name": "Debug",

"program": "${workspaceFolder}/${defaultBuildTask}/bin/observer",

"args": ["-f", "${workspaceFolder}/etc/observer.ini", "-s", "miniob.sock"],

"cwd": "${workspaceFolder}/${defaultBuildTask}/"

}

注意,如果要调试 release 或者其它任务编译出来的observer,就需要调整这个文件,或者新增一个配置,因为这个配置文件指定的observer路径是默认的build。

环境准备

运行环境

- 操作系统

frank@DESKTOP-6NF3B9K:~/git/miniob$ cat /etc/os-release

NAME="Ubuntu"

VERSION="20.04.5 LTS (Focal Fossa)"

ID=ubuntu

ID_LIKE=debian

PRETTY_NAME="Ubuntu 20.04.5 LTS"

VERSION_ID="20.04"

HOME_URL="https://www.ubuntu.com/"

SUPPORT_URL="https://help.ubuntu.com/"

BUG_REPORT_URL="https://bugs.launchpad.net/ubuntu/"

PRIVACY_POLICY_URL="https://www.ubuntu.com/legal/terms-and-policies/privacy-policy"

VERSION_CODENAME=focal

UBUNTU_CODENAME=focal

注:这里直接用的windows的WSL,

软件要求

- vscode

- cmake

- make

- gcc/g++

- libevent

- googletest

- jsoncpp

- git

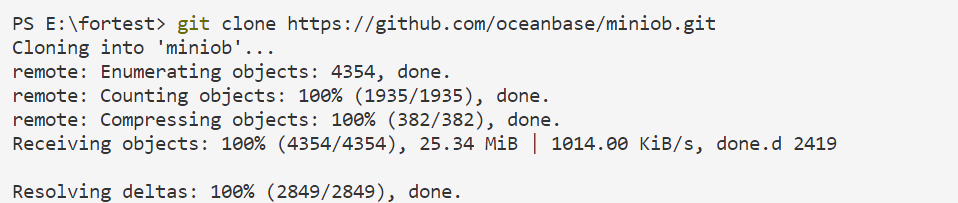

获取代码

git clone https://github.com/oceanbase/miniob.git

安装软件

可以参考miniob/docs/how_to_build.md。

vscode配置

使用vscode打开miniob工程目录。

cd miniob

code .

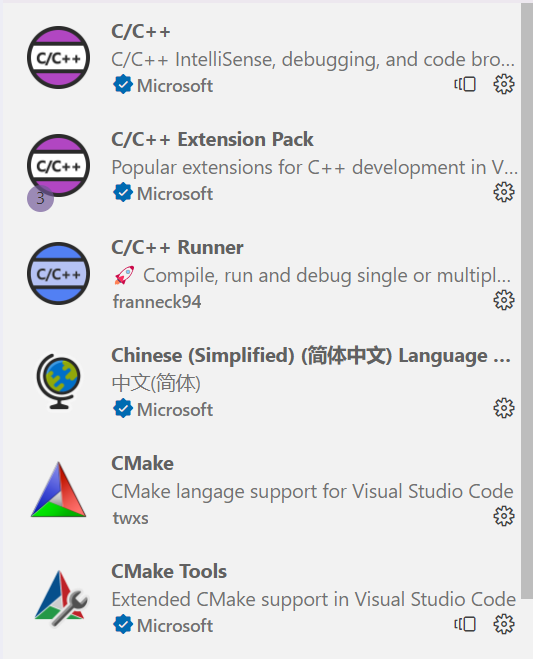

安装插件

|  |

|---|

配置编译tasks.json

在工程的.vscode目录下新建tasks.json

{

"options": {

"cwd": "${workspaceFolder}/build"

},

"tasks": [

{

"label": "cmake",

"command": "cmake",

"args": [

"-DDEBUG=ON",

".."

]

},

{

"label": "make",

"command": "make"

},

{

"label": "CMake Build",

"dependsOn": [

"cmake",

"make"

]

}

],

"version": "2.0.0"

}

注意:

- options:cmake临时文件的目录

- args:cmake需要的参数

配置调试launch.json

在工程的.vscode目录下新建launch.json

{

// 使用 IntelliSense 了解相关属性。

// 悬停以查看现有属性的描述。

// 欲了解更多信息,请访问: https://go.microsoft.com/fwlink/?linkid=830387

"version": "0.2.0",

"configurations": [

{

"name": "(gdb) 启动",

"type": "cppdbg",

"request": "launch",

"program": "${workspaceFolder}/build/bin/observer",

"args": ["-f", "../../etc/observer.ini"],

"stopAtEntry": false,

"cwd": "${fileDirname}",

"environment": [],

"externalConsole": false,

"MIMode": "gdb",

"setupCommands": [

{

"description": "为 gdb 启用整齐打印",

"text": "-enable-pretty-printing",

"ignoreFailures": true

},

{

"description": "将反汇编风格设置为 Intel",

"text": "-gdb-set disassembly-flavor intel",

"ignoreFailures": true

}

],

"preLaunchTask": "CMake Build"

}

]

}

注意:

- program:编译出来的可执行文件

- args:运行参数

- preLaunchTask:

"label": "CMake Build"对应

演示

- 重新使用vscode打开,打开后会自动运行tasks的cmake。

- 设置断点、启动调试

注意:启动是会触发make,对工程进行编译。因为是单线程编译,所以第一次惦记启动gdb时需要时间较长,后续如果没有修改源码的操作,则直接踢动gdb进行调试。如果想使用多线程编译可以在tasks.json中配置make参数。

{

"label": "make",

"command": "make",

"args": [

"-j",

"4"

]

},

args中配置相当于make -j 4

终端输出如下:

- 调试

注意:同种标记部分包括调试常用的功能,如:查看变量、调用栈、断点,以及n, s, finish, r等命令。

使用 Docker 和 VSCode 远程开发 Miniob

本文档阐述如何使用 Docker 构建一个具备 Miniob 开发环境的容器,并且通过 VSCode 的 Remote-SSH 插件 SSH 到容器中进行远程开发。Docker 和 VSCode 可以安装在不同机器上。

方法简单易行,仅需配置 2 个 环境变量(仓库 URL、SSH秘钥)及安装必要的 VSCode 开发插件即可。

- 使用 Docker 和 VSCode 远程开发 Miniob

安装 Docker 和 Docker-compose

Windows

参考本仓库文档 在 Windows 上使用 Docker 安装 Docker Desktop 即可。只需执行 安装 Docker 这一小节。

Linux

如果你选择在远程建议参考官方文档安装 Docker Engine 和 Docker Compose.

安装 VSCode

前往官网下载 Visual Studio Code,正常安装即可。

配置 Dockerfile

文件在 docker/Dockerfile.

配置 Root 密码

默认密码 root,可在 64 行自行修改。不需修改可跳过。

若镜像于服务器运行建议使用强密码,并在第一次登录后关闭密码登录,改用秘钥登录。

配置 Docker Compose

Fork 仓库

Fork 本仓库,复制 Fork 后仓库的 HTTPS 地址,如 https://github.com/oceanbase/miniob.git.

也可以不 Fork,用本仓库 Git HTTPS 地址,后续自行进行 git remote add.

下面配置镜像中的仓库 URL 及克隆方式。

修改 docker/docker-compose.yml 文件的最后两行。注意等号前后不要有空格。

Clone by SSH

REPO_ADDR 设置为 SSH URL, 如:git@github.com:oceanbase/miniob.git

Clone by HTTPS

私有仓库

如果 fork 出来的是私有仓库。

假设仓库 HTTPS 地址为:https://github.com/oceanbase/miniob.git.

REPO_ADDR 格式:https://<username>:<password>@github.com/oceanbase/miniob.git

username 和 password GitHub / Gitee(GitHub 不支持 password,需要创建 token,见链接)。

用户名如果是邮箱,字符 '@' 需要转义为 '%40'.

# example

REPO_ADDR=https://oceanbase%40email.com:mypassword@github.com/oceanbase/miniob.git

公有仓库

如果 fork 出的是公有仓库,直接将 REPO_ADDR 设置为仓库地址即可。

REPO_ADDR=https://github.com/oceanbase/miniob.git

配置映射端口

默认映射本机端口 10000 到容器端口 22. 可在 docker-compose.yml 中自行修改。不许修改可跳过此步骤。

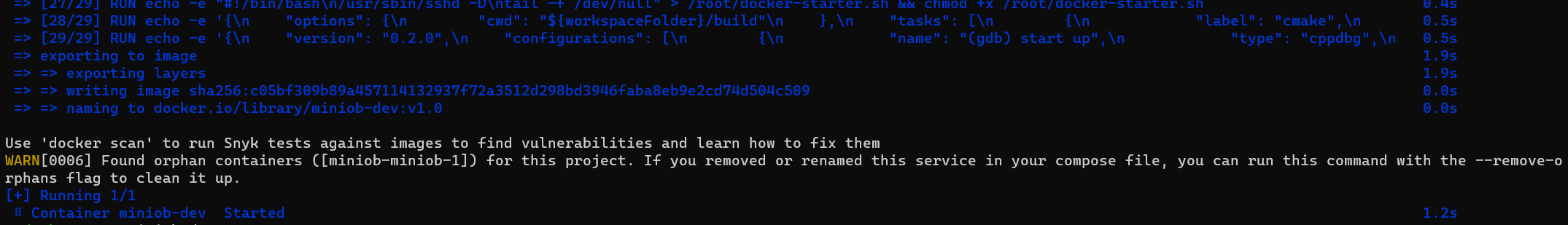

启动容器

Clone by SSH

如果用 SSH 的方式 clone,需要将 Github/Gitee 对应的 SSH 私钥设置到环境变量内再启动 Container.

假设 Github/Gitee 上传的公钥对应的秘钥位于 ~/.ssh/id_rsa.

terminal 进入本仓库 docker 目录,在 docker 目录下执行命令启动容器。

Linux Shell

export PRIVATE_KEY=$(cat ~/.ssh/id_rsa) && docker-compose up -d --build

Windows Powershell

$env:PRIVATE_KEY=$(cat ~/.ssh/id_rsa) && docker-compose up -d --build

Clone by HTTPS

不需要 PRIVATE_KEY 环境变量。

docker-compose up -d --build

此输出表示容器启动成功。

管理容器

一些管理容器的命令。

# 停止容器

docker stop miniob-dev

# 启动容器

docker start miniob-dev

# 重启容器

docker restart miniob-dev

使用 VSCode 远程开发

打开 VSCode,设置远程开发及调试。

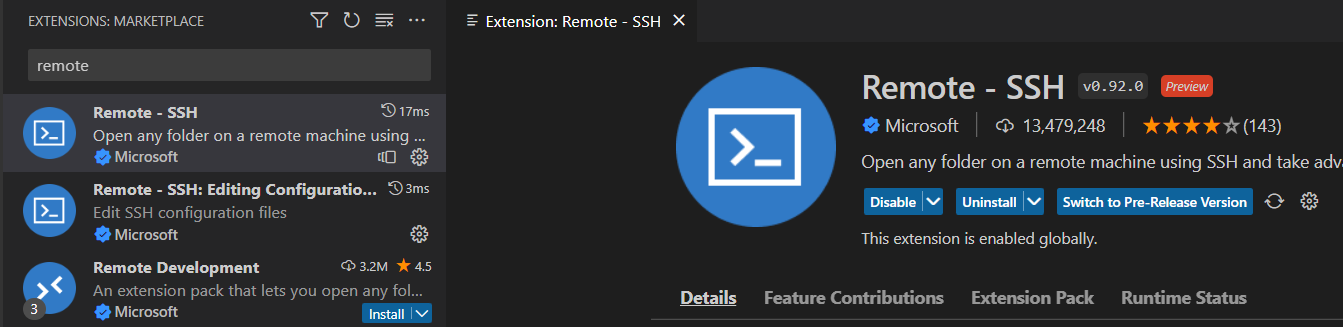

安装 Remote-SSH 插件

一般会默认安装。快捷键组合 Ctrl + Shift + x 打开 VSCode 插件面板,检查 Remote - SSH 插件是否安装,如果没有安装就安装此插件。

连接 Docker 容器

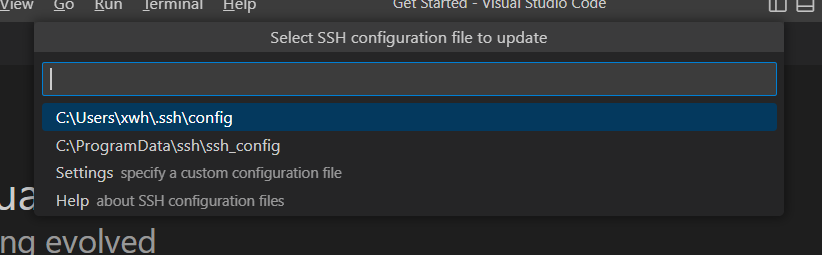

配置 SSH Host

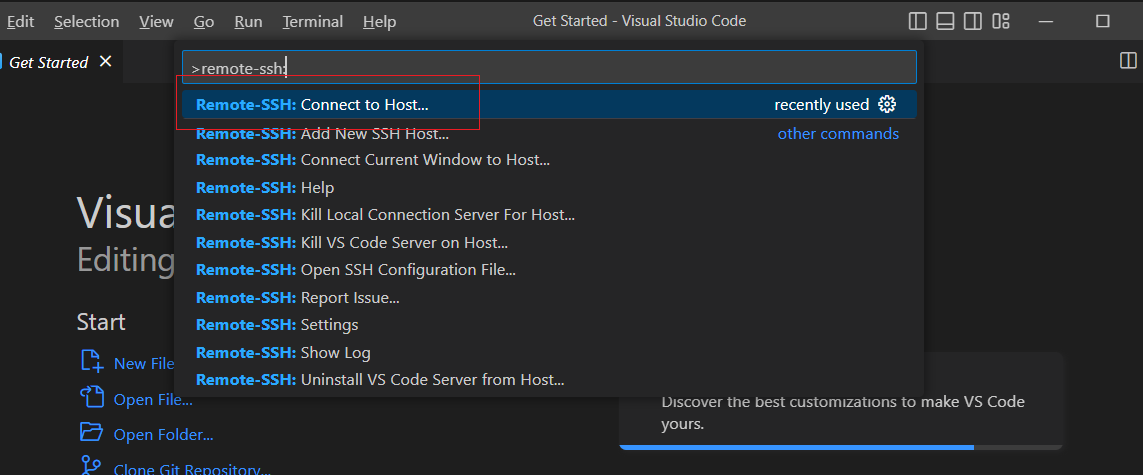

按快捷键 Ctrl + p, 输入 remote-ssh: connect to host 连接远程主机。

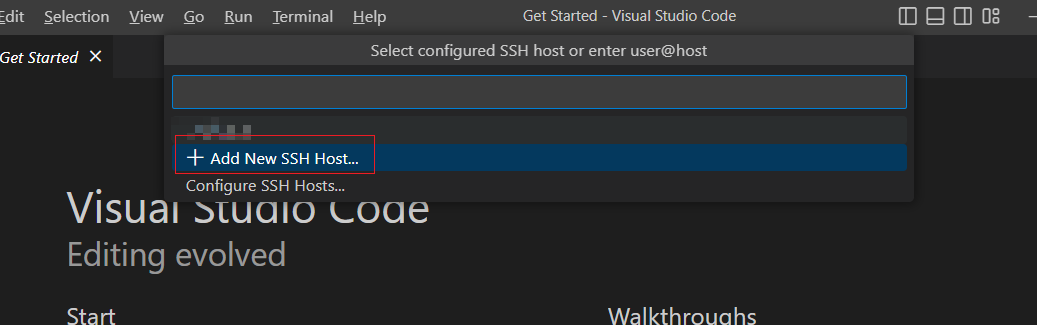

选择 Add new ssh host.

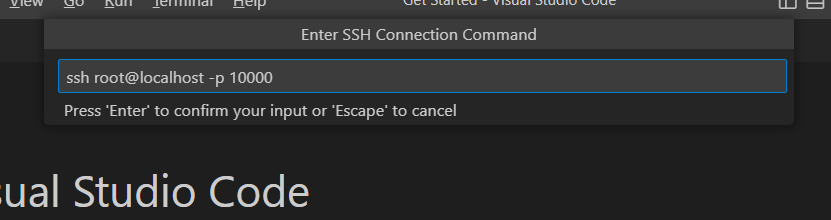

输入命令.

ssh root@localhost -p 10000

以 root 用户连接容器的 10000 端口.

选择写入哪个配置文件,默认第一个就行。

连接容器

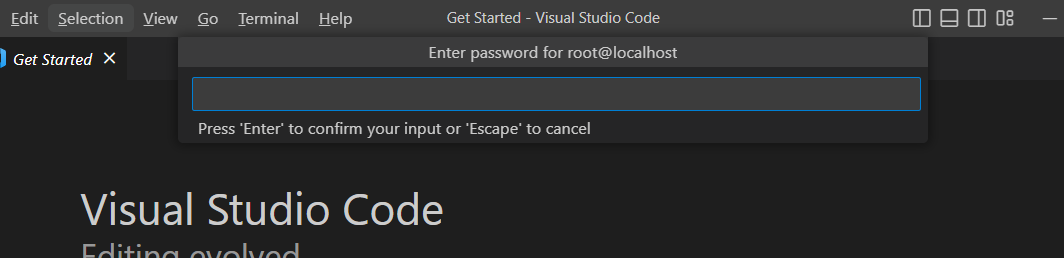

按快捷键 Ctrl + p, 输入 remote-ssh: connect to host 连接远程主机。

主机选 localhost 并回车,跳出密码输入页面。若在之前步骤没有修改,密码默认为 root.

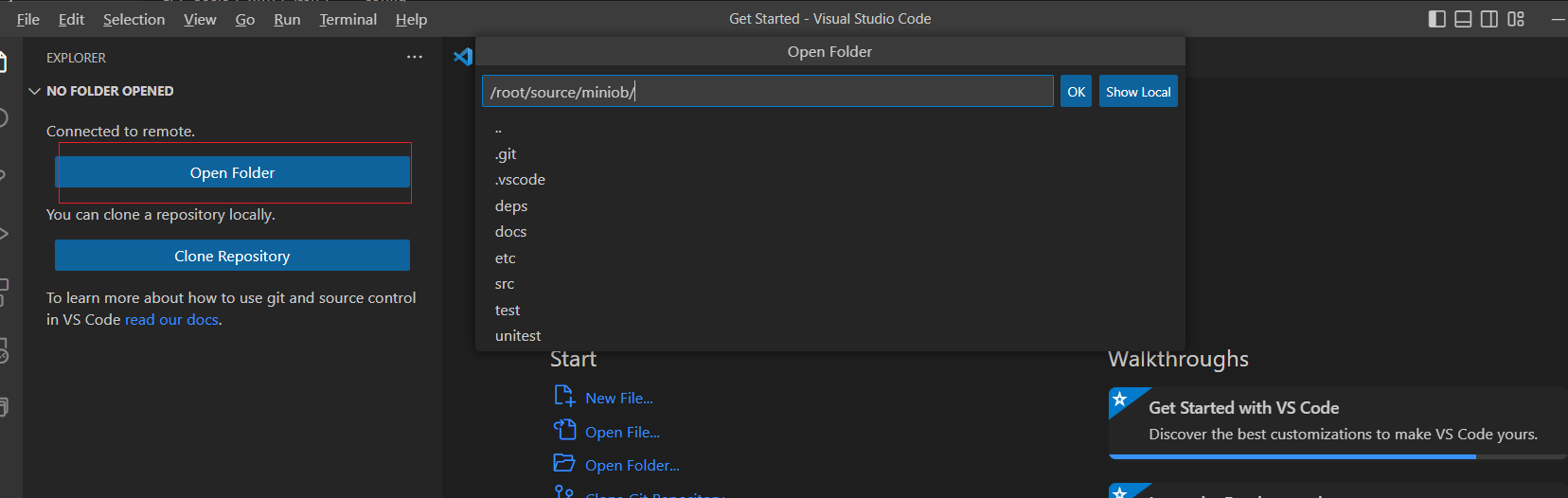

打开代码目录

代码位于 /root/source/miniob. 点击左侧 open folder,进入该目录。需要再输入一次密码。

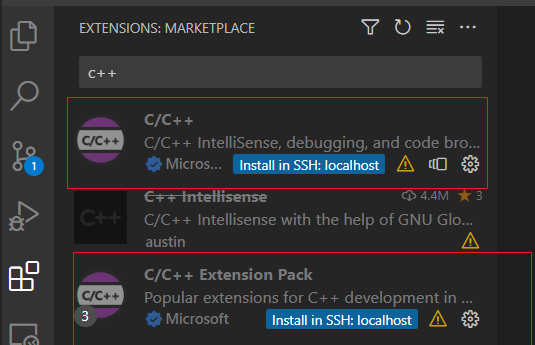

安装开发插件

Ctrl + Shift + x 打开 VSCode 插件面板, 安装如下插件. 注意要安装在 Docker 容器中,点击 install in SSH:localhost.

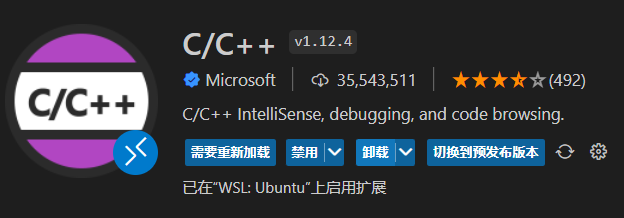

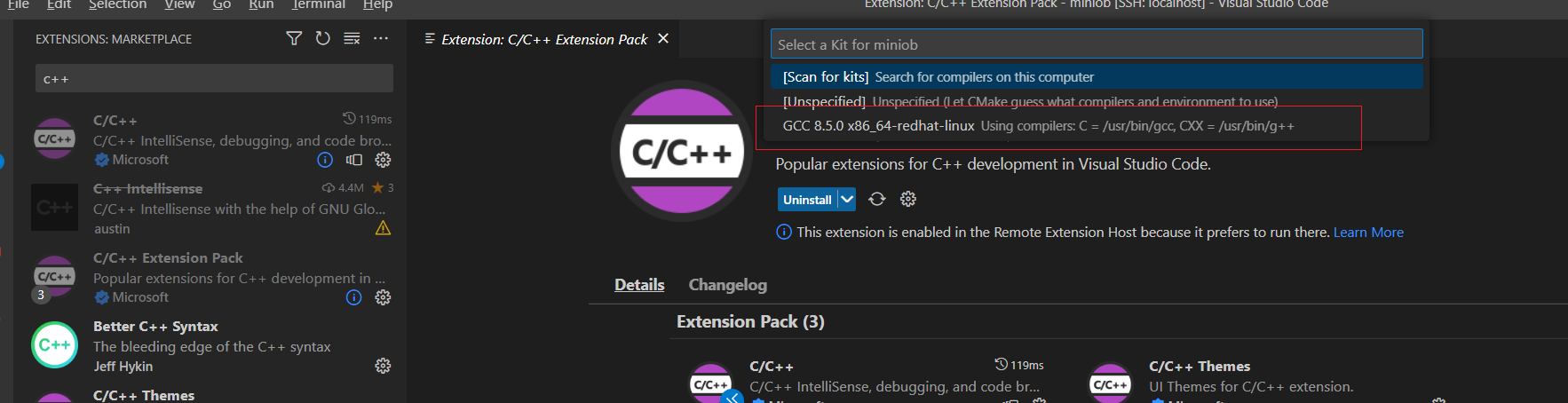

C/C++ 和 C/C++ Extension Pack.

C/C++ Extension Pack 安装好后会让你选择 kits, 选 GCC 8.5 这个。

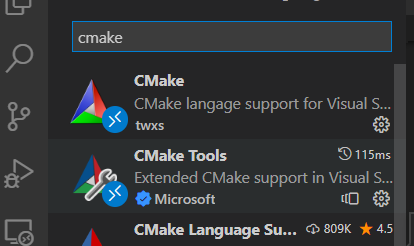

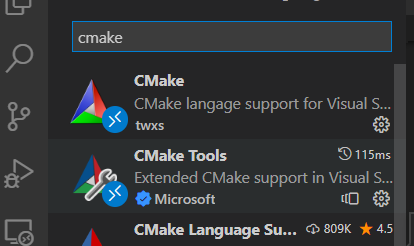

CMake 和 CMake Tools.

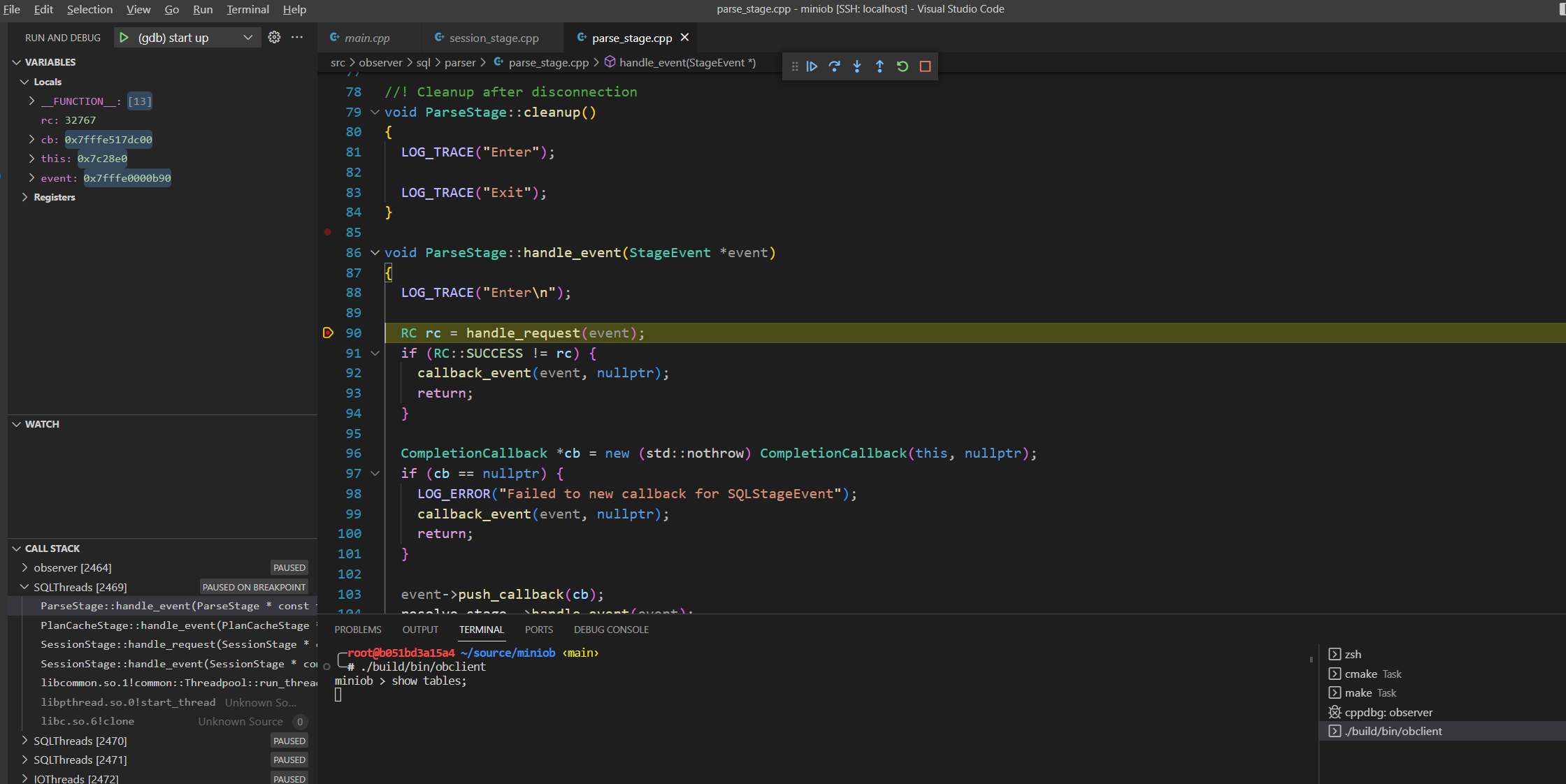

进行 Debug

启动 Server

在 src/observer/sql/parser/parse_stage.cpp 的 handle_event 函数开头打个断点, 也就是第 90 行。

按 F5 开始调试。出现如下界面表示 miniob 的 server 端启动成功。

启动 Client

Ctrl + Shift + ` 新启动一个 shell.

执行 ./build/bin/obclient 启动客户端.

执行 SQL

执行一句 SQL 测试断点是否正常工作。

show tables;

正常进入断点。后续可以配置 Git 进行开发了。

Windows 如何使用 Docker 开发miniob

miniob 是 OceanBase联合华中科技大学开发的一款帮助零基础开发者数据库开发实战的系统,目前已经开源,可以在GitHub网站查看:miniob github首页。

Miniob 是一个基于Linux的系统,可以在Linux和Mac上开发测试。使用Windows的同学,可以尝试Docker、Linux 子系统或者Cygwin等方式。本篇文章介绍在Windows系统上如何使用Docker来开发miniob。

安装Docker

Windows系统上默认不会安装Docker,需要自行安装。安装Docker有一些依赖,比如要开启电脑的虚拟化功能、Windows的Hyper-V 功能,具体操作可以参考这篇文档在Windows系统上安装Docker。

虽然文档已经比较详细,而且网上可以搜到大量的教程,这里还是给一些步骤提示。

如何开启电脑的虚拟化

以ThinkPad X1 Carbon 为例(不同的电脑可能会有些不同)

开机按 F1 进入:BIOS (不同的电脑进入BIOS的方式可能不同)

- 选择:Security

- 选择:Virtualization

- 选择:

- Intel(R) Virturalization Technology=Enable

- Intel(R) VT-d Feature=Enable

下载Docker Desktop

这个步骤没有什么特殊的,下载即可。

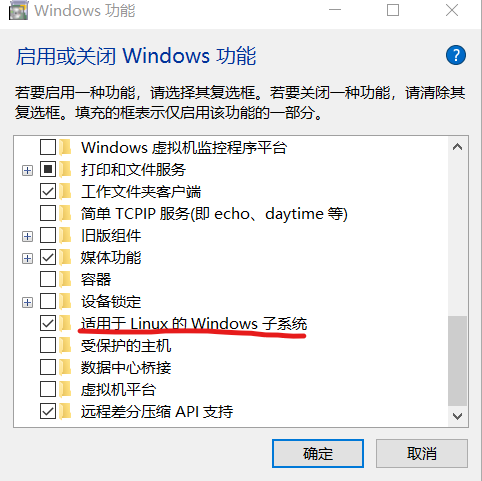

开启Windows 子系统

可以在Windows应用中找到Windows功能的开关,具体步骤以Windows 10为例,参考下面的步骤。

安装Docker

Windows应用程序的典型安装,点击下载好的安装包即可。

运行Docker

在PowerShell 中执行以下命令,下载并启动miniob镜像

docker run -d --name miniob --privileged oceanbase/miniob

其中 privileged 参数是为了方便在容器中进行调试。

运行下面的命令可以进入到容器并进行开发

docker exec -it miniob bash

这个命令可以在终端上执行多次,开启多个窗口方便操作。

到这里就可以结束了,但是为了方便后续的开发,还有一些建议。

- 将代码放在自己的电脑上,Docker仅作为一个开发环境。启动镜像时这么做

docker run -d --name miniob --privileged -v $PWD/miniob:/root/miniob oceanbase/miniob

其中 -v $PWD/miniob:/root/miniob 是说将本地的 $PWD/miniob 目录映射到容器中的/root/miniob 目录,这里假设 $PWD/miniob 是你本地代码存放的位置,需要按照实际目录来调整。

代码放在自己的电脑上,好处是如果容器出现什么异常,自己最重要的数据不会丢失。

- 启动镜像时忘记增加一些参数,但是又不想重新创建怎么办?

有时候启动镜像时(docker run),忘记增加一些参数,比如 privileged,但是又在容器中做了蛮多操作,对环境做了调整,不希望启动全新的容器,可以这么做

- 提交当前的容器,创建新的镜像

docker commit -m 'commit message' -t miniob:vx miniob

docker stop miniob

docker rm miniob

- 启动新的镜像

docker run -d --name miniob xxxx miniob:vx

NOTE: 参数中 miniob:vx 中的vx 是一个版本号,你可以自己设置,每次使用不同的名字即可。

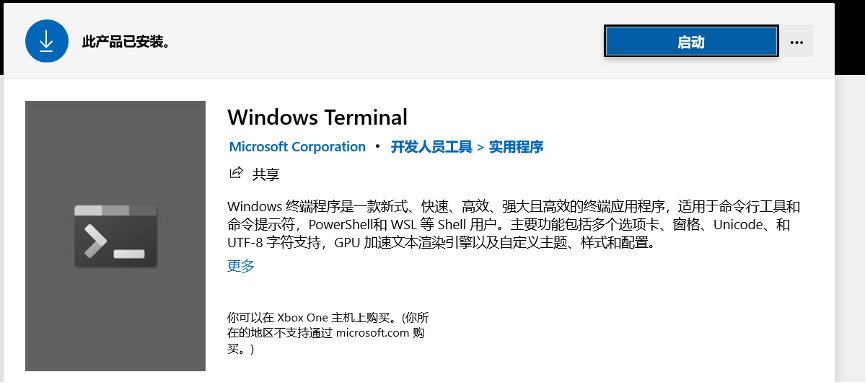

- 在Windows上安装 Windows Terminal 应用

说实话,Windows自带的PowerShell和命令提示符实在太丑了,而且不支持配置。可以在应用商城中下载Windows Terminal 应用,此应用免费,默认界面非常漂亮并且支持多种终端。

FAQ

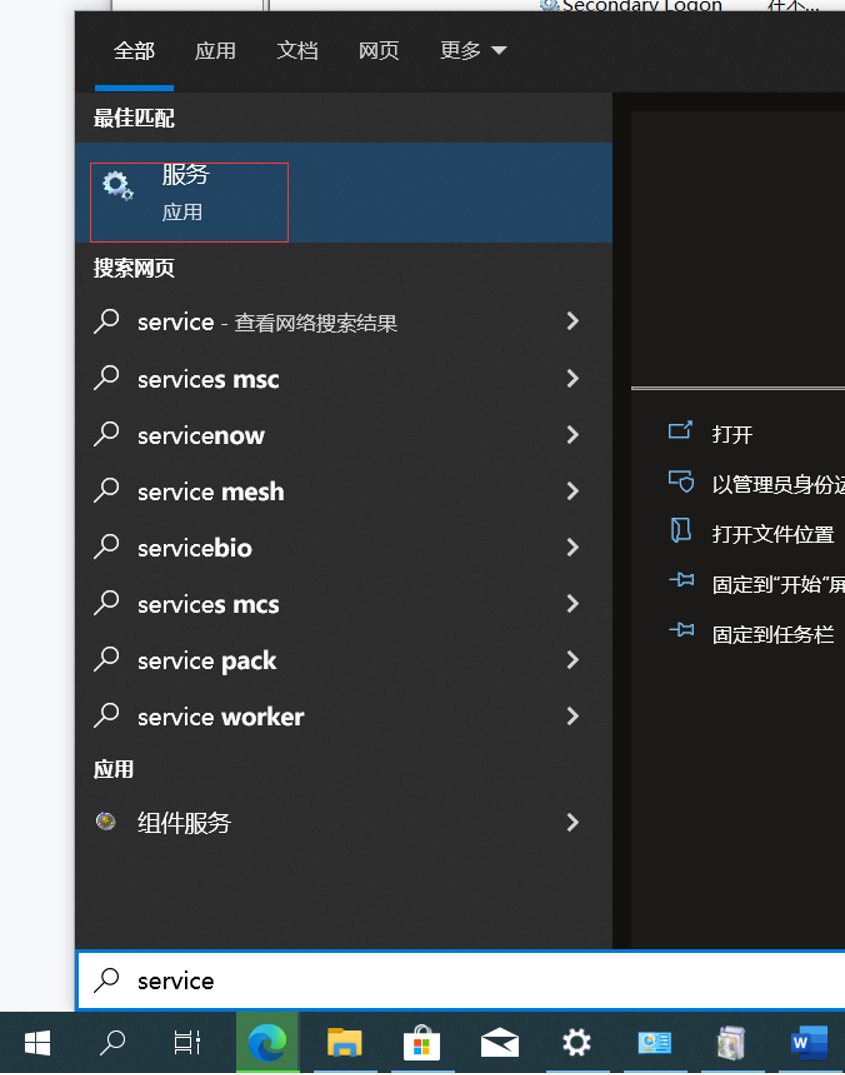

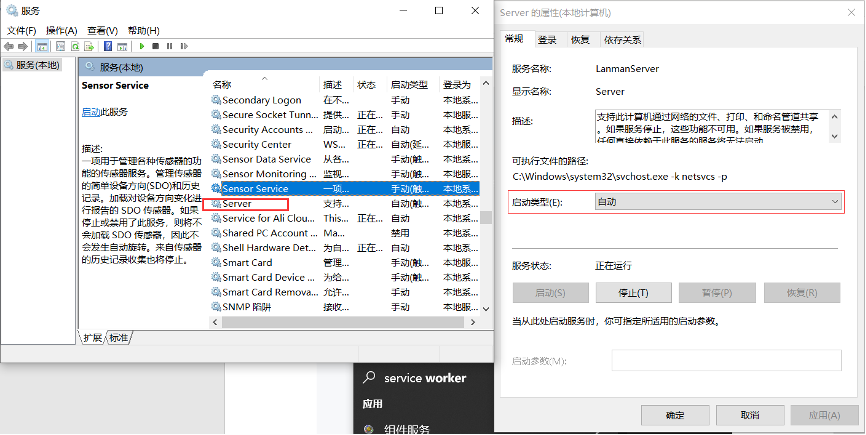

- Docker Desktop requires the Server service to be enabled. 开启Windows服务即可

-

搜索 service 应用

-

开启server应用

- miniob 镜像中当前包含哪些信息 可以参考miniob镜像的网站首页:miniob 镜像首页

在windows上通过docker配置环境并利用vscode调试代码(手把手版)

-- 由严奕凡编写,就读于重庆大学.

系统情况: windows操作系统,版本win11

个人情况: from 0 to 1 不想用虚拟机,不想用gitpod

参考资料: https://oceanbase.github.io/miniob 、小伙伴们的讨论、亲身经历

配置思路: 1、使用docker提供linux编译环境 2、使用vscode进行代码编辑 3、使用vscode的docker插件,在vscode终端调试

个人理解1: docker对我来说就是在windows系统上提供一个虚拟的linux环境,它只在build和调试时起到作用

个人理解2: vscode用来编辑代码

个人理解3: vscode里面docker插件的attach功能可以在vscode的终端实现一个linux的虚拟环境,使得miniob的build.sh能在其中通过bash指令运行

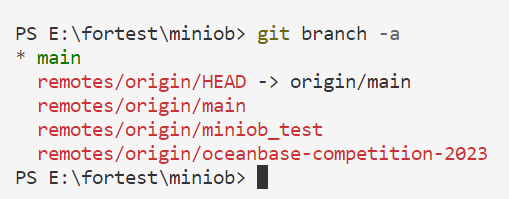

实操:

1、下载docker

2、获取oceanbase/miniob的docker环境

方法是在任意位置启动 终端(cmd或者powershell)

运行以下代码

docker run --privileged -d --name=miniobtest oceanbase/miniob

其中 --name=miniobtest 这个“miniobtest”是自己容器的名字 可以自己改 这个代码大概理解成从远程oceanbase/miniob拉取适合miniob的配置好的环境

这一步之后先把docker放一放,后面需要将本地文件与docker进行一个连接,先不放代码以免产生误解

3、在vscode中使用git 对官网miniob进行clone ,在本地创建一个代码仓库

PS:这一步部分小伙伴可能会遇到网络问题,提示您clone的时候连接到github失败,有两种解决办法,其一是解决访问github的问题,其二是直接从github上下载源代码下来,另外还可以用ssh的方式clone代码,速度比https快很多(本文档暂未给出ssh使用办法,有兴趣的小伙伴可以进行补充)

1)准备工作(有vscode和git,并且配置好环境变量的小伙伴可以看下一步):

下载vscode Visual Studio Code - Code Editing. Redefined

下载git Git (git-scm.com)

配置vscode设置 ,下载所需插件:例如docker

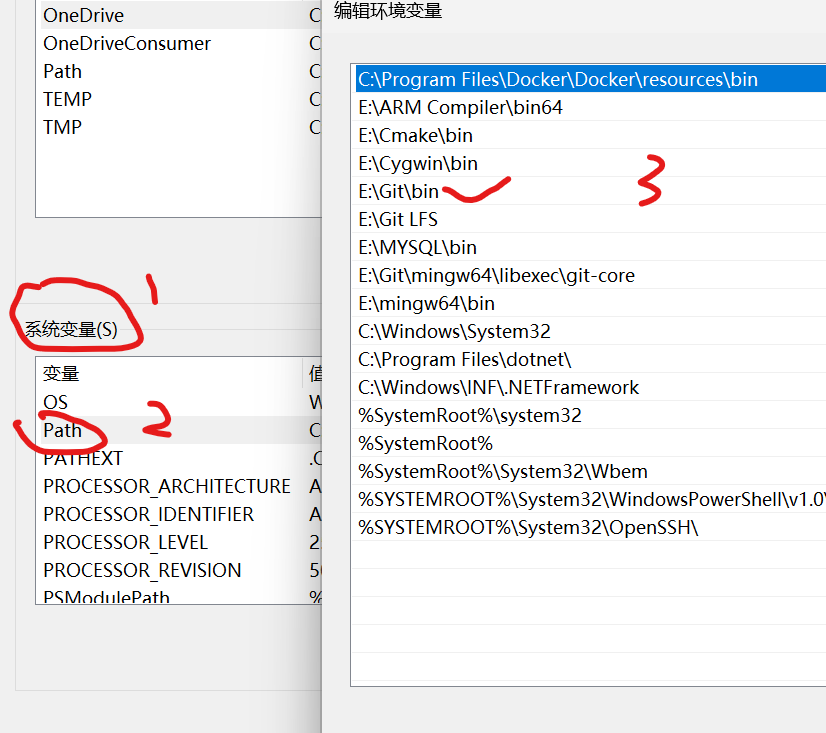

配置环境变量(这是为了让git能在vscode终端中使用):

验证以下路径是否存在(如果没有,请添加文件路径)

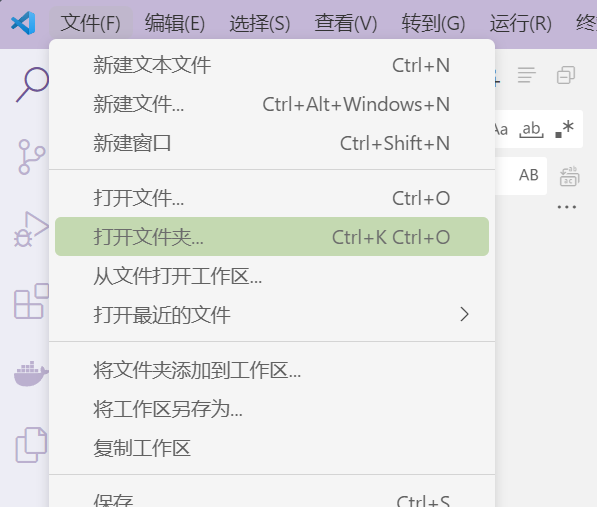

2)进入vscode clone 代码

文件-打开文件夹,选取一个用于保存代码的文件夹

然后ctrl+shift+~ (快速新建一个终端) (PS:Mac 系统 Command + J)

在终端里输入

git clone https://github.com/oceanbase/miniob.git

如果git配置正确并且能成功连接到github

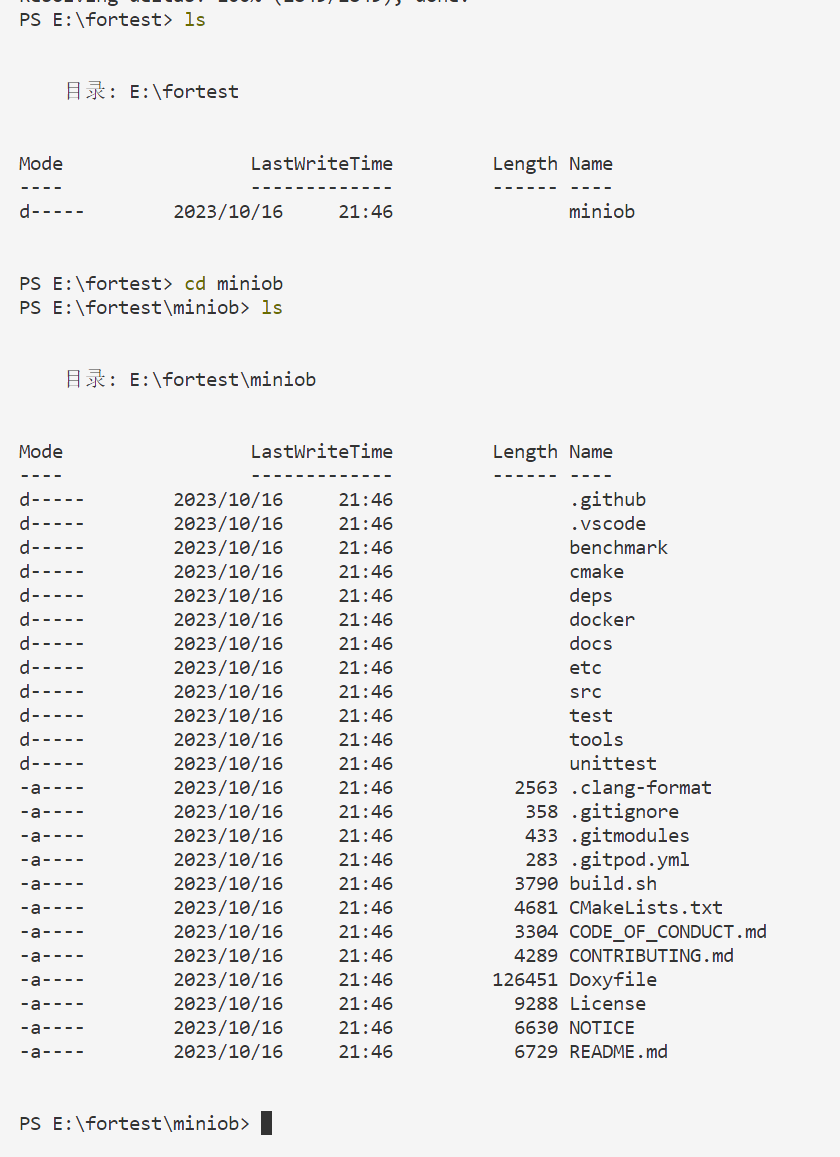

您可以得到

然后您可以进入得到的代码文件查看分支信息:例如

ls --查看当前目录

cd ‘文件名’ --进入

您可以输入 (要先进入clone得到的代码文件里面,才能读取到.git文件)

git branch -a

查看所有分支

4、将获取到的文件与docker容器 映射连接

创建一个container(映射方式)

恭喜!您已经获取到代码文件,并且实现了大部分配置!

接下来我们进入clone得到的文件夹的上一层目录,在那打开终端(这是方便后续代码的实现)

您也可以用cd 指令进入得到的文件夹的上一层目录

像这样

然后输入

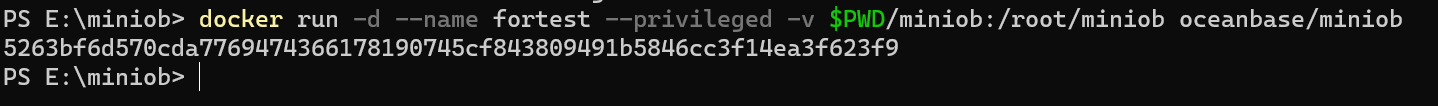

docker run -d --name fortest --privileged -v $PWD/miniob:/root/miniob oceanbase/miniob

分析如下:

您提供的命令

docker run用于运行具有特定选项和配置的 Docker 容器,但它还指定要运行的映像。让我们分解一下命令:

docker run:这是启动新 Docker 容器的基本命令。-d:此选项以分离模式运行容器,这意味着它在后台运行,允许您继续使用终端。--name fortest:此选项指定容器的名称为“fortest”。--privileged:这是一个与安全相关的选项,可授予容器额外的权限,从而有效地赋予其对主机系统的更高访问权限。使用时要小心,--privileged因为它可能会带来安全风险。-v $PWD/miniob:/root/miniob:此选项用于创建卷安装。它将主机系统上的目录或文件映射到容器内的目录。在本例中,它将主机系统上miniob当前工作目录 ( ) 中的目录映射到容器内的目录。这是向容器提供数据或配置的常见方法。$PWD``/root/minioboceanbase/miniob:指定要运行的 Docker 映像。镜像“oceanbase/miniob”用于创建容器。如果您的系统上尚未提供该映像,Docker 将尝试从 Docker Hub 中提取该映像。因此,总体命令是以分离模式运行名为“fortest”的 Docker 容器,授予其提升的权限,将目录

miniob从主机系统安装到/root/miniob容器内的目录,并使用“oceanbase/miniob”映像作为容器。此命令对于运行基于具有特定配置的“oceanbase/miniob”映像的容器非常有用。

得到的结果如图

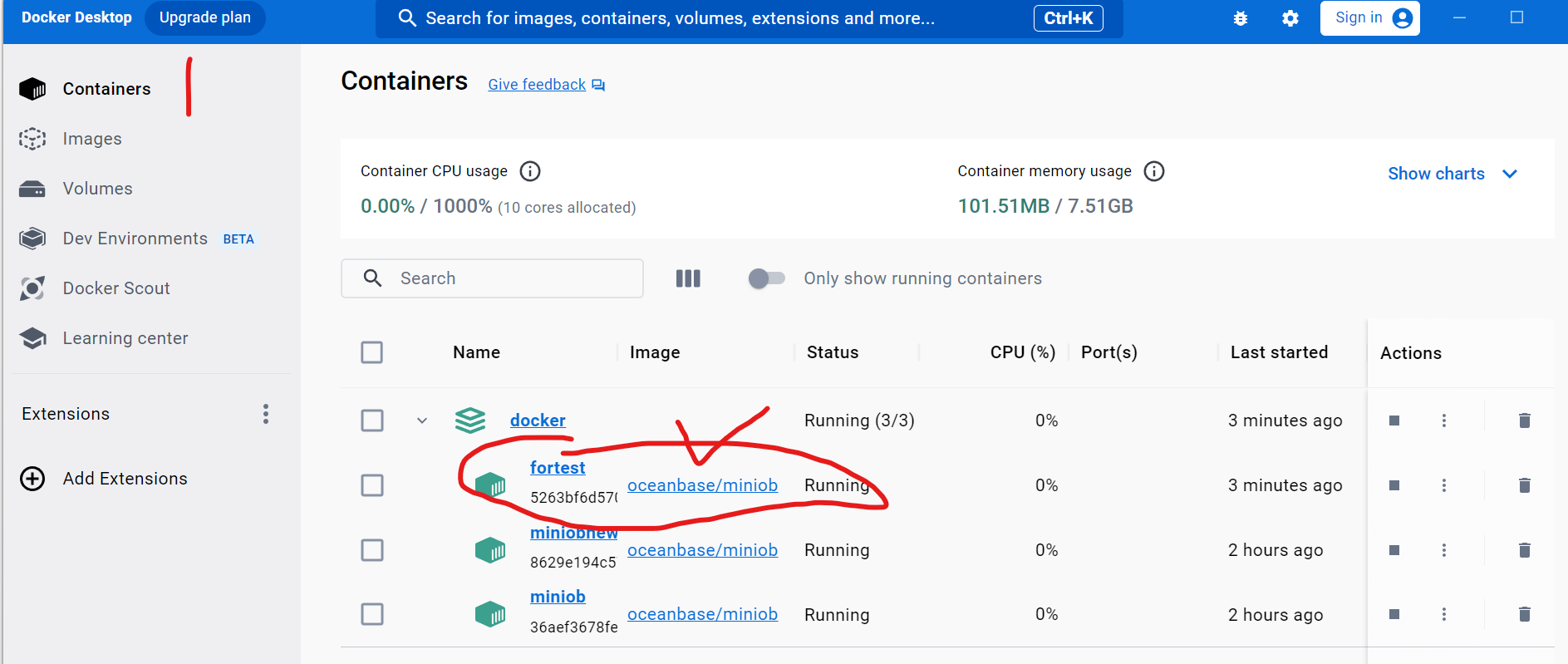

此时您应该可以在docker里面查看到container

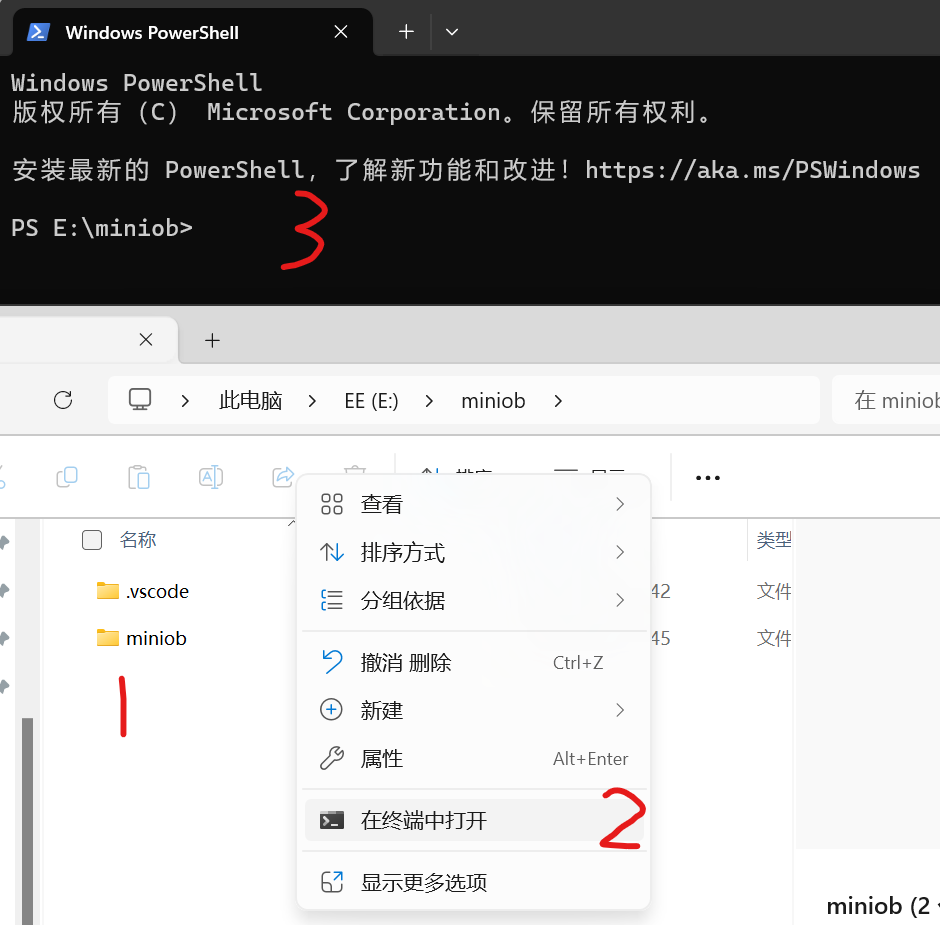

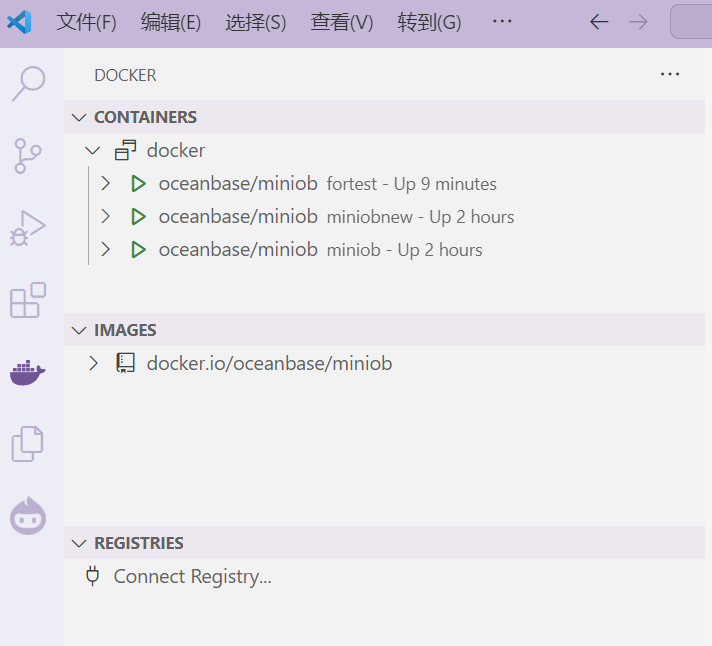

5、在vscode中启动docker

1)先打开docker软件(每次重启电脑后都需要做)

2)打开vscode,在左侧边栏找到下载好的docker插件

然后选中您刚才用以下代码生成的容器,如果是初次生成,您可能只会显示一个容器

docker run -d --name fortest --privileged -v $PWD/miniob:/root/miniob oceanbase/miniob

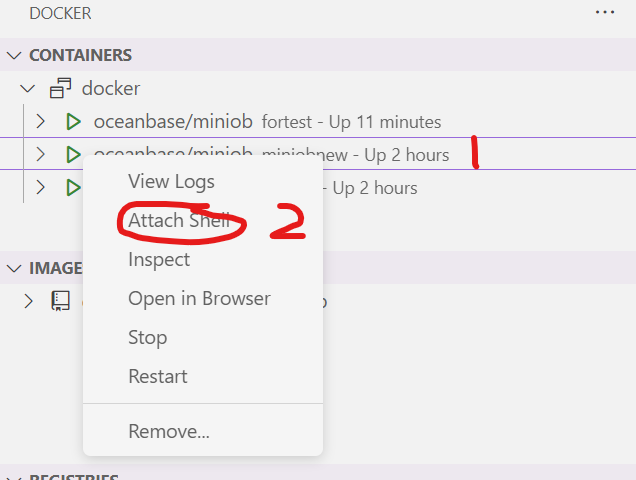

右键选中容器然后attach shell

然后在打开的终端中就可以编译miniob了!

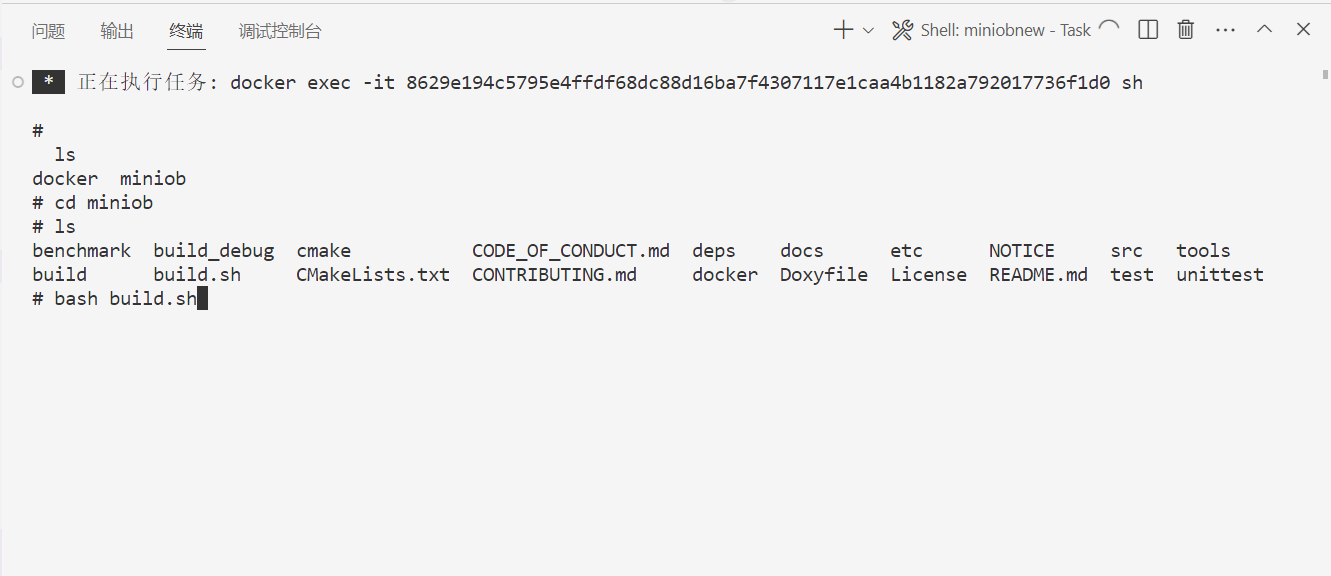

(注意,一开始是不会有build 和build_debug文件的,这两个是通过运行bash.sh生成的)

综合运用以下代码运行build.sh文件

ls

cd miniob

bash build.sh

解释如下

您提供的命令是类 Unix 操作系统终端(例如 Linux)中使用的典型命令。让我分解一下命令:

ls:该命令是“list”的缩写。它用于列出当前目录中的文件和目录。运行ls将显示当前工作目录中的文件和文件夹列表。cd miniob:此命令将当前工作目录更改为名为“miniob”的子目录。您将导航到“miniob”目录。bash build.sh:此命令正在运行名为“build.sh”的 Bash 脚本。该脚本可能用于构建或编译某些软件、设置开发环境或执行与“miniob”项目或应用程序相关的其他任务。运行此脚本将执行其中定义的命令。假设“build.sh”是“miniob”项目的构建脚本,则运行这些命令是构建或设置项目的常见顺序。该

ls命令用于检查当前目录的内容,cd用于更改到“miniob”目录,并bash build.sh用于执行构建脚本。

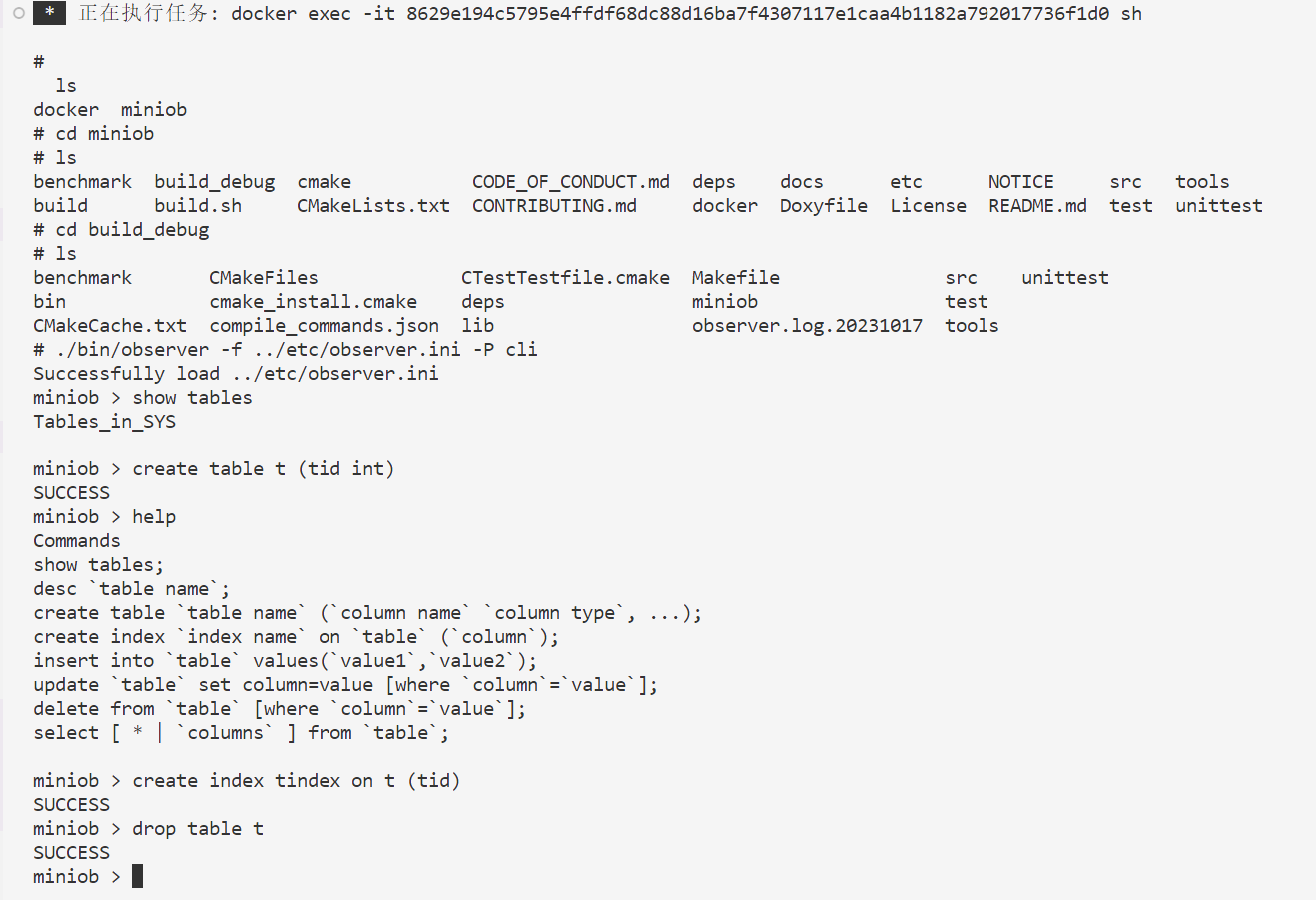

编译通过后你可以在目录看到 build 或者build_debug 文件 然后可以进去调试

示例代码:

cd build_debug

./bin/observer -f ../etc/observer.ini -P cli

#这会以直接执行命令的方式启动服务端程序,可以直接输入命令,不需要客户端。所有的请求都会以单线程的方式运行,配置项中的线程数不再有实际意义。

示例图(ps:drop table功能一开始没有实习,需要您自己去尝试实现)

您也可以启动服务端后再启用客户端,也可以实现类似效果 在vscode中操作为 再次attach shell新建一个终端 参考文档:https://oceanbase.github.io/miniob/how_to_run.html

以监听TCP端口的方式启动服务端程序

./bin/observer -f ../etc/observer.ini -p 6789

这会以监听6789端口的方式启动服务端程序。 启动客户端程序:

./bin/obclient -p 6789

这会连接到服务端的6789端口。

编辑日期 2023-10-17

本篇文章介绍如何使用Docker来开发MiniOB。

MiniOB 依赖的第三方组件比较多,搭建开发环境比较繁琐,建议同学们直接使用我们提供的Docker环境进行开发。

首先要确保本地已经安装了Docker。 如果对Docker还不太熟悉,可以先在网上大致了解一下。

我们提供了原始的Dockerfile,也有已经打包好的镜像,可以选择自己喜欢的方式。 自行构建参考本文档。

- 使用docker hub 镜像运行

docker run --privileged -d --name=miniob oceanbase/miniob

此命令会创建一个新的容器,然后可以执行下面的命令进入容器:

docker exec -it miniob /usr/bin/zsh

Docker环境说明:

docker基于anolisos:8.6制作。

镜像包含:

- jsoncpp

- google test

- libevent

- flex

- bison(3.7)

- gcc/g++ (version=11)

- miniob 源码(/root/source/miniob)

docker中在/root/source/miniob目录下载了github的源码,可以根据个人需要,下载自己仓库的源代码,也可以直接使用git pull 拉取最新代码。 /root/source/miniob/build.sh 提供了一个编译脚本,以DEBUG模式编译miniob。

miniob调试篇

-- by caizj

调试c/c++程序,常用的有两种方式,一是打印日志调试,二是gdb调试,调试不仅可以定位问题,也可以用来熟悉代码。

miniob关键代码

首先,拿到一份陌生的代码,要先确定代码的大致结构,一些关键数据结构和方法,这里的技巧和经验不展开了

miniob的关键数据结构

部分关键数据结构:

parse_def.h:

struct Selects;//查询相关

struct CreateTable;//建表相关

struct DropTable;//删表相关

enum SqlCommandFlag;//sql语句对应的command枚举

union Queries;//各类dml和ddl操作的联合

table.h

class Table;

db.h

class Db;

miniob的关键接口

部分关键接口

RC parse(const char *st, Query *sqln);//sql parse入口

ExecuteStage::handle_request

ExecuteStage::do_select

DefaultStorageStage::handle_event

DefaultHandler::create_index

DefaultHandler::insert_record

DefaultHandler::delete_record

DefaultHandler::update_record

Db::create_table

Db::find_table

Table::create

Table::scan_record

Table::insert_record

Table::update_record

Table::delete_record

Table::scan_record

Table::create_index

打印日志调试

miniob提供的日志接口

deps/common/log/log.h:

#define LOG_PANIC(fmt, ...)

#define LOG_ERROR(fmt, ...)

#define LOG_WARN(fmt, ...)

#define LOG_INFO(fmt, ...)

#define LOG_DEBUG(fmt, ...)

#define LOG_TRACE(fmt, ...)

日志相关配置项observer.ini

LOG_FILE_NAME = observer.log

# LOG_LEVEL_PANIC = 0,

# LOG_LEVEL_ERR = 1,

# LOG_LEVEL_WARN = 2,

# LOG_LEVEL_INFO = 3,

# LOG_LEVEL_DEBUG = 4,

# LOG_LEVEL_TRACE = 5,

# LOG_LEVEL_LAST

LOG_FILE_LEVEL=5

LOG_CONSOLE_LEVEL=1

gdb调试

调试工具有很多种,但是它们的关键点都是类似的,比如关联到进程、运行时查看变量值、单步运行、跟踪变量等。GDB是在Linux环境中常用的调试工具。其它环境上也有类似的工具,比如LLDB,或者Windows可能使用Visual Studio直接启动调试。Java的调试工具是jdb。

另外,很多同学喜欢使用Visual Studio Code(vscode)开发项目,vscode提供了很多插件,包括调试的插件,这些调试插件支持gdb、lldb等,可以按照自己的平台环境,设置不同的调试工具。

这里介绍了gdb的基本使用,其它工具的使用方法类似。

-

Attach进程

[caizj@localhost run]$ gdb -p `pidof observer` GNU gdb (GDB) Red Hat Enterprise Linux 8.2-15.el8 Copyright (C) 2018 Free Software Foundation, Inc. (gdb) -

设置断点

(gdb) break do_select Breakpoint 1 at 0x44b636: file /home/caizj/source/stunning-engine/src/observer/sql/executor/execute_stage.cpp, line 526. (gdb) info b Num Type Disp Enb Address What 1 breakpoint keep y 0x000000000044b636 in ExecuteStage::do_select(char const*, Query*, SessionEvent*) at /home/caizj/source/stunning-engine/src/observer/sql/executor/execute_stage.cpp:526(gdb) break Table::scan_record Breakpoint 2 at 0x50b82b: Table::scan_record. (2 locations) (gdb) inf b Num Type Disp Enb Address What 1 breakpoint keep y 0x000000000044b636 in ExecuteStage::do_select(char const*, Query*, SessionEvent*) at /home/caizj/source/stunning-engine/src/observer/sql/executor/execute_stage.cpp:526 2 breakpoint keep y <MULTIPLE> 2.1 y 0x000000000050b82b in Table::scan_record(Trx*, ConditionFilter*, int, void*, void (*)(char const*, void*)) at /home/caizj/source/stunning-engine/src/observer/storage/common/table.cpp:421 2.2 y 0x000000000050ba00 in Table::scan_record(Trx*, ConditionFilter*, int, void*, RC (*)(Record*, void*)) at /home/caizj/source/stunning-engine/src/observer/storage/common/table.cpp:426 (gdb) -

继续执行

(gdb) c Continuing. -

触发断点

执行:miniob > select * from t1;

[Switching to Thread 0x7f51345f9700 (LWP 54706)] Thread 8 "observer" hit Breakpoint 1, ExecuteStage::do_select (this=0x611000000540, db=0x6040000005e0 "sys", sql=0x620000023080, session_event=0x608000003d20) at /home/caizj/source/stunning-engine/src/observer/sql/executor/execute_stage.cpp:526 526 RC rc = RC::SUCCESS; (gdb) -

单步调式

575 std::vector<TupleSet> tuple_sets; (gdb) next 576 for (SelectExeNode *&node: select_nodes) { (gdb) n 577 TupleSet tuple_set; (gdb) 578 rc = node->execute(tuple_set); (gdb) -

跳入 跟踪到函数内部

(gdb) s SelectExeNode::execute (this=0x60700002ce80, tuple_set=...) at /home/caizj/source/stunning-engine/src/observer/sql/executor/execution_node.cpp:43 43 CompositeConditionFilter condition_filter; (gdb) -

打印变量

(gdb) p tuple_set $3 = (TupleSet &) @0x7f51345f1760: {tuples_ = std::vector of length 0, capacity 0, schema_ = { fields_ = std::vector of length 0, capacity 0}} (gdb) -

watch变量

(gdb) n 443 RC rc = RC::SUCCESS; (gdb) n 444 RecordFileScanner scanner; (gdb) n 445 rc = scanner.open_scan(*data_buffer_pool_, file_id_, filter); (gdb) watch -l rc Hardware watchpoint 3: -location rc (gdb) c Continuing. Thread 8 "observer" hit Hardware watchpoint 3: -location rc Old value = SUCCESS New value = RECORD_EOF 0x000000000050c2de in Table::scan_record (this=0x60f000007840, trx=0x606000009920, filter=0x7f51345f12a0, limit=2147483647, context=0x7f51345f11c0, record_reader=0x50b74a <scan_record_reader_adapter(Record*, void*)>) at /home/caizj/source/stunning-engine/src/observer/storage/common/table.cpp:454 454 for ( ; RC::SUCCESS == rc && record_count < limit; rc = scanner.get_next_record(&record)) { (gdb) -

结束函数调用

(gdb) finish Run till exit from #0 0x000000000050c2de in Table::scan_record (this=0x60f000007840, trx=0x606000009920, filter=0x7f51345f12a0, limit=2147483647, context=0x7f51345f11c0, record_reader=0x50b74a <scan_record_reader_adapter(Record*, void*)>) at /home/caizj/source/stunning-engine/src/observer/storage/common/table.cpp:454 -

结束调试

(gdb) quit A debugging session is active. Inferior 1 [process 54699] will be detached. Quit anyway? (y or n) y Detaching from program: /home/caizj/local/bin/observer, process 54699 [Inferior 1 (process 54699) detached]

Visual Studio Code 调试

代码中已经为vscode配置了launch.json,可以直接启动调试。 launch.json中有两个调试配置,一个是Debug,一个是LLDB。其中Debug使用cppdbg,会自动探测调试工具gdb或lldb,而LLDB会使用lldb调试工具。通常情况下,大家使用Debug就可以了,但是我在测试过程中发现cppdbg不能在macos上正常工作,因而增加了LLDB的配置,以便在macos上调试,如果使用macos的同学,可以使用LLDB配置启动调试程序。

功能模块设计说明

- Miniob架构

- 存储实现

- Double Write Buffer

- 事务

- 持久化

- SQL Parser

- 如何新增支持一种新类型SQL

- 表达式解析

- B+树实现

- 并发B+树实现

- 线程池模型

- 通讯协议简介

- Doxy文档

MiniOB代码架构框架设计和说明

MiniOB代码结构说明

背景

MiniOB旨在帮助不太熟悉数据库设计和实现的同学快速掌握和深入学习数据库内核。我们希望通过MiniOB的培训,学生能够理解不同数据库内核模块的功能和它们之间的联系。这个项目主要面向在校学生,对模块的设计和实现进行了简化处理,以便于他们更好地理解和学习。

MiniOB架构介绍

- 网络模块(NET Service):负责与客户端交互,收发客户端请求与应答;

- SQL解析(Parser):将用户输入的SQL语句解析成语法树;

- 语义解析模块(Resolver):将生成的语法树,转换成数据库内部数据结构;

- 查询优化(Optimizer):根据一定规则和统计数据,调整/重写语法树;

- 计划执行(Executor):根据语法树描述,执行并生成结果;

- 存储引擎(Storage Engine):负责数据的存储和检索;

- 事务管理(MVCC):管理事务的提交、回滚、隔离级别等。当前事务管理仅实现了MVCC模式,因此直接以MVCC展示;

- 日志管理(Redo Log):负责记录数据库操作日志;

- 记录管理(Record Manager):负责管理某个表数据文件中的记录存放;

- B+ Tree:表索引存储结构;

- 会话管理:管理用户连接、调整某个连接的参数;

- 元数据管理(Meta Data):记录当前的数据库、表、字段和索引元数据信息;

- 客户端(Client):作为测试工具,接收用户请求,向服务端发起请求。

各模块工作原理介绍

服务端启动过程

虽然代码是模块化的,并且面向对象设计思想如此流行,但是很多同学还是喜欢从main函数看起。那么就先介绍一下服务端的启动流程。

main函数参考 main@src/observer/main.cpp。启动流程大致如下:

解析命令行参数 parse_parameter@src/observer/main.cpp

加载配置文件 Ini::load@deps/common/conf/ini.cpp

初始化日志 init_log@src/observer/init.cpp

初始化网络服务 init_server@src/observer/main.cpp

启动网络服务 Server::serve@src/net/server.cpp

建议把精力更多的留在核心模块上,以更快的了解数据库的工作原理。

网络模块

网络模块代码参考src/observer/net,主要是Server类。 当前支持TCP socket和Unix socket,TCP socket可以跨主机通讯,需要服务端监听特定端口。Unix socket只能在本机通讯,测试非常方便。 在处理具体连接的网络IO请求时,会有具体的线程模型来处理,当前支持一对一连接线程模型和线程池模型,可以参考文档MiniOB线程模型。 网络服务启动后,会监听端口(TCP)或Unix连接,当接收到新的连接,会将新的连接描述字加入网络线程模型中。 线程模型会在进程运行时持续监听对应socket上新请求的到达,然后将请求交给具体的处理模块。

SQL解析

SQL解析模块是接收到用户请求,开始正式处理的第一步。它将用户输入的数据转换成内部数据结构,一个语法树。

解析模块的代码在src/observer/sql/parser下,其中lex_sql.l是词法解析代码,yacc_sql.y是语法解析代码,parse_defs.h中包含了语法树中各个数据结构。

对于词法解析和语法解析,原理概念可以参考《编译原理》。

其中词法解析会把输入(这里比如用户输入的SQL语句)解析成成一个个的“词”,称为token。解析的规则由自己定义,比如关键字SELECT,或者使用正则表达式,比如"[A-Za-z_]+[A-Za-z0-9_]*" 表示一个合法的标识符。

对于语法分析,它根据词法分析的结果(一个个token),按照编写的规则,解析成“有意义”的“话”,并根据这些参数生成自己的内部数据结构。比如SELECT * FROM T,可以据此生成一个简单的查询语法树,并且知道查询的columns是"*",查询的relation是"T"。

NOTE:在查询相关的地方,都是用关键字relation、attribute,而在元数据中,使用table、field与之对应。

更多相关内容请参考 MiniOB SQL语法解析。

语义解析

语法解析会将用户发来的SQL文本内容,解析为一个文本描述的语法树,语义解析(Resolver)将语法树中的一些节点,比如表名、字段名称等,转换为内部数据结构中的真实对象。

解析可以做的更多,比如在解析表字段映射的过程中,可以创建Tuple,将字段名直接转换为使用更快的Field或数字索引的方式来访问某一行数据的字段。当前没有做此优化,每次都是在执行过程中根据字段名字来查找特定的字段,参考类 ProjectTuple。

优化

优化决定SQL执行效率非常重要的一环,通常会根据一定的规则,对SQL语法树做等价调整,再根据一些统计数据,比如表中的数据量、索引情况等,来选择更好的执行计划。

MiniOB中的执行计划优化仅实现了简单的框架,可以参考 OptimizeStage。

计划执行

顾名思义,计划执行就是按照优化后生成的执行计划原意执行,获取SQL结果。

当前查询语句被转换成了火山执行计划,执行时按照火山模型算子中,通过执行算子的 next 方法获取每行的执行结果。

对于DDL等操作,SQL最终被转换为各种Command,由CommandExecutor来执行。

计划执行的代码在src/observer/sql/executor/下,主要参考execute_stage.cpp的实现。

元数据管理模块

元数据是指数据库一些核心概念,包括db、table、field、index等,记录它们的信息。比如db,记录db文件所属目录;field,记录字段的类型、长度、偏移量等。代码文件分散于src/observer/storage/table,field,index中,文件名中包含meta关键字。

客户端

这里的客户端提供了一种测试miniob的方法。从标准输入接收用户输入,将请求发给服务端,并展示返回结果。这里简化了输入的处理,用户输入一行,就认为是一个命令。

通信协议

MiniOB 采用TCP通信,支持两种通讯协议,分别是纯文本模式和MySQL通讯协议,详细设计请参考 MySQL 通讯协议设计。 对于纯文本模式,客户端与服务端发送数据时,使用普通的字符串来传递数据,使用'\0'字符作为每个消息的终结符。

注意:测试程序也使用这种方法,请不要修改协议,后台测试程序依赖这个协议。 注意:返回的普通数据结果中不要包含'\0',也不支持转义处理。

为了方便测试,MiniOB 支持不使用客户端,可以直接启动后在终端输入命令的方式做交互,在启动 observer 时,增加 -P cli 参数即可,更多信息请参考 如何运行MiniOB。

参考

- 《数据库系统概念》

- 《数据库系统实现》

- 《flex_bison》 flex/bison手册

- flex开源源码

- bison首页

- cmake官方手册

- libevent官网

- OceanBase数据库文档

- OceanBase开源网站

附录-编译安装测试

编译

参考 如何构建MiniOB 文件。

运行服务端

参考 如何运行MiniOB。

MiniOB 存储实现

本节将从存储层面介绍 MiniOB 的实现。

MiniOB 框架简介

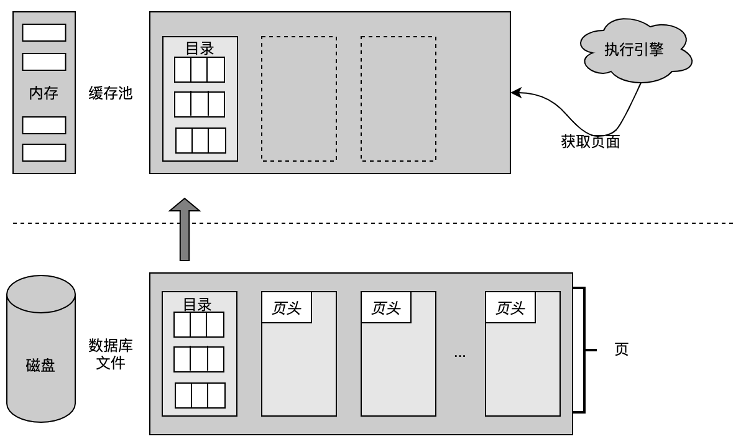

首先回顾一下 MiniOB 的框架,在 MiniOB 概述章节已经简单的介绍过,本节重点介绍执行器(Executor)访问的存储引擎。

存储引擎控制整个数据、记录是如何在文件和磁盘中存储,以及如何跟内部 SQL 模块之间进行交互。存储引擎中有三个关键模块:

-

Record Manager:组织记录一行数据在文件中如何存放。

-

Buffer Pool:文件跟内存交互的关键组件。

-

B+Tree:索引结构。

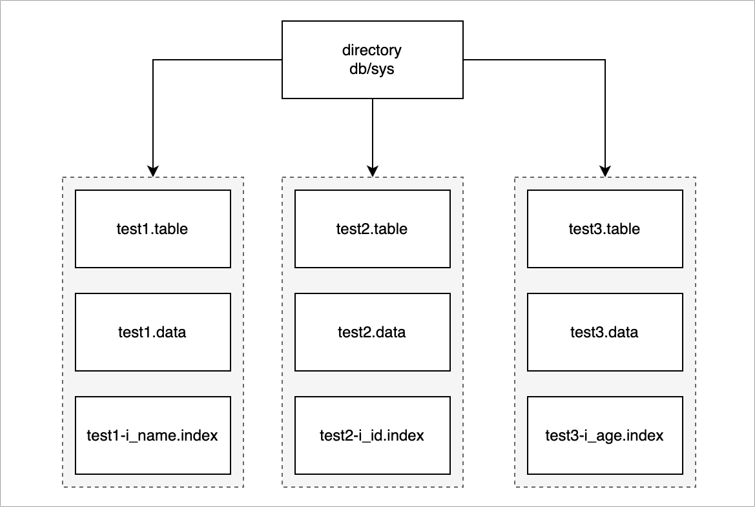

MiniOB 文件管理

首先介绍 MiniOB 中文件是怎么存放,文件需要管理一些基础对象,如数据结构、表、索引。数据库在 MiniOB 这里体现就是一个文件夹,如下图所示,最上面就是一个目录,MiniOB 启动后会默认创建一个 sys 数据库,所有的操作都默认在 sys 中。

一个数据库下会有多张表。上图示例中只有三张表,接下来以 test1 表为例介绍一下表里都存放什么内容。

-

test1.table:元数据文件,这里面存放了一些元数据。如:表名、数据的索引、字段类型、类型长度等。

-

test1.data:数据文件,真正记录存放的文件。

-

test1-i_name.index:索引文件,索引文件有很多个,这里只展示一个示例。

MiniOB Buffer Pool 模块介绍

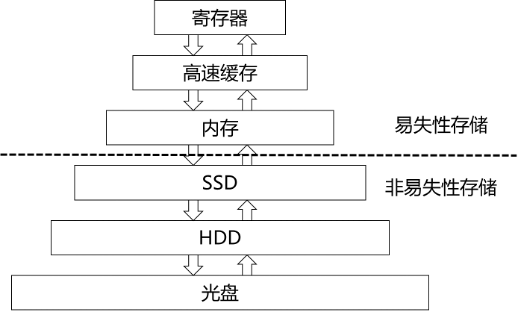

Buffer Pool 在传统数据库里是非常重要的基础组件。

首先来了解一下为什么要有一个 Buffer Pool ,数据库的数据是存放在磁盘里的,但不能直接从磁盘中读取数据,而是需要先把磁盘的数据读取到内存中,再在 CPU 做一些运算之后,展示给前端用户。写入也是一样的,一般都会先写入到内存,再把内存中的数据写入到磁盘。这种做法也是一个很常见的缓存机制。

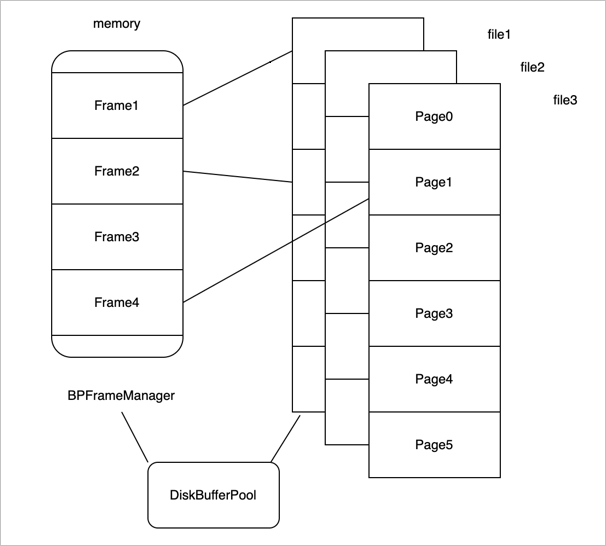

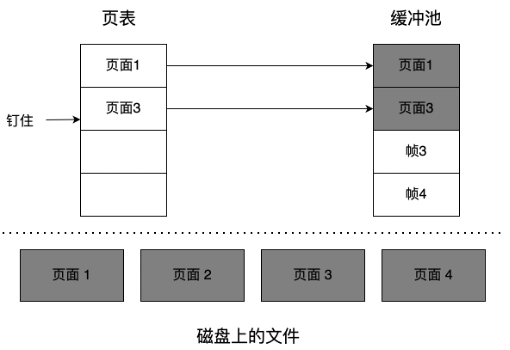

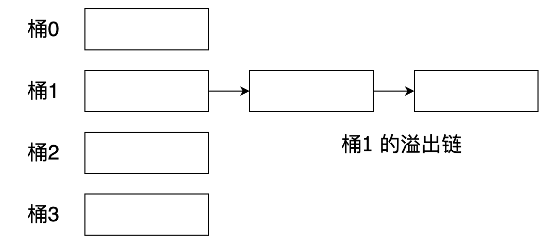

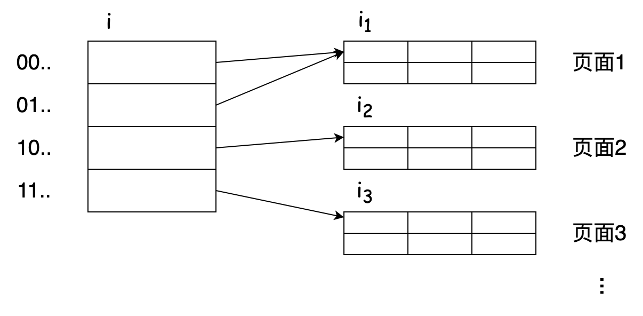

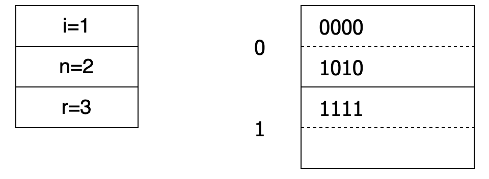

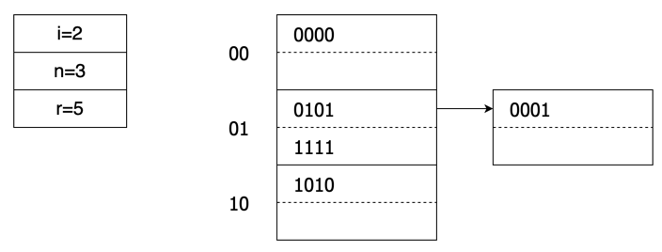

接着来看 Buffer Pool 在 MiniOB 中是如何组织的。如上图所示,左边是内存,把内存拆分成不同的帧(frame)。假如内存中有四个 frame,对应了右边的多个文件,每个文件按照每页来划分,每个页的大小都是固定的,每个页读取时是以页为单位跟内存中的一个 frame 相对应。

Buffer Pool 在 MiniOB 里面组织的时候,一个 DiskBufferPool 对象对应一个物理文件。所有的 DiskBufferPool 都使用一个内存页帧管理组件 BPFrameManager,他是公用的。

再来看下读取文件时,怎么跟内存去做交互的。如上图所示,frame1 关联了磁盘中一个文件的页面,frame2 关联了另一个页面,frame3 是空闲页面,没有关联任何磁盘文件,frame4 也关联了一个页面。

比如现在要去读取 file3 的 Page3 页面,首先需要从 BPFrameManager 里面去找一个空闲的 frame,很明显,就是 frame3,然后再把 frame3 跟它关联起来,把 Page3 的数据读取到 frame3 里。现在内存中的所有 frame 都对应了物理页面。

如果再去读取一个页面,如 Page5,这时候已经找不到内存了,通常有两种情况:

-

内存还有空闲空间,可以再申请一个 frame,跟 Page5 关联起来。

-

内存没有空闲空间,还要再去读 Page4,已经没有办法去申请新的内存了。此时就需要从现有的 frame 中淘汰一个页面,比如把 frame1 淘汰掉了,然后把 frame1 跟 Page4 关联起来,再把 Page4 的数据读取到 frame1 里面。淘汰机制也是有一些淘汰条件和算法的,可以先做简单的了解,暂时先不深入讨论细节。

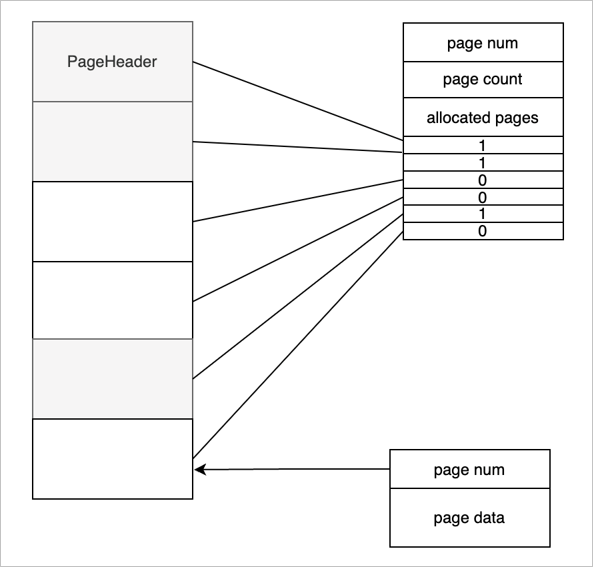

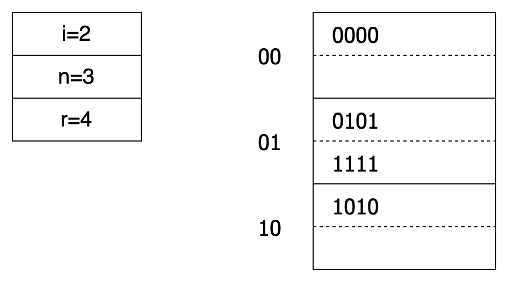

再来看一下,一个物理的文件上面都有哪些组织结构,如上图所示。

-

文件上的第一页称为页头或文件头。文件头是一个特殊的页面,这个页面上会存放一个页号,这个页号肯定都是零号页,即 page num 是 0。

-

page count 表示当前的文件一共有多少个页面。

-

allocated pages 表示已经分配了多少个页面。如图所示标灰的是已经分配的三个页面。

-

Bitmap 表示每一个 bit 位当前对应的页面的分配状态,1 已分配页面,0 空闲页面。

当前这一种组织结构是有一个缺陷的,整个文件能够支持的页面的个数受页面大小的限制,也就是说能够申请的页面的个数受页面大小的限制的。有兴趣的,可以思考一下怎么能实现一个无限大或支持更大页面的算法。

接下来介绍一下普通页面(除 PageHeader 外),普通页面对 Buffer Pool 来说,第一个字段是用四字节的 int 来表示,就是 page num。接下来是数据,这个数据是由使用 Buffer Pool 的一些模块去控制。比如 Record Manage 或 B+Tree,他们会定义自己的结构,但第一个字段都是 page num,业务模块使用都是 page data 去做组织。

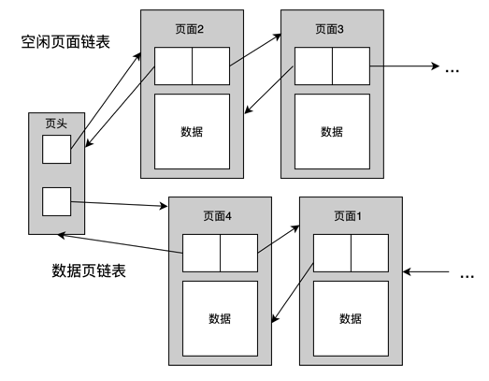

MiniOB 记录管理

记录管理模块(Record Manager)主要负责组织记录在磁盘上的存放,以及处理记录的新增与删除。需要尽可能高效的利用磁盘空间,尽量减少空洞,支持高效的查找和新增操作。

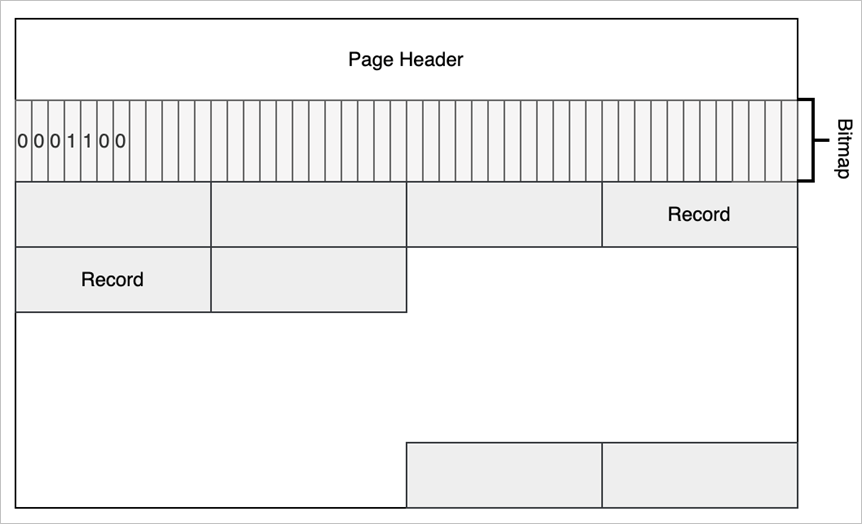

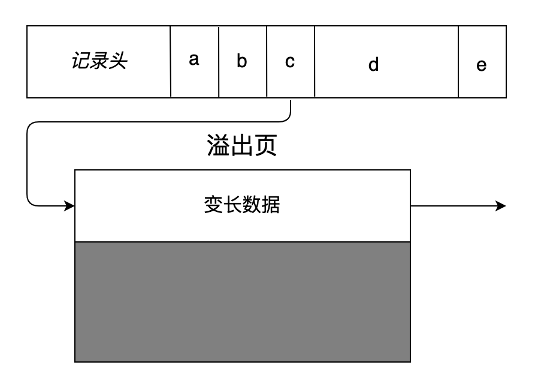

MiniOB 的 Record Manager 做了简化,有一些假设,记录通常都是比较短的,加上页表头,不会超出一个页面的大小。另外记录都是固定长度的,这个简化让学习 MiniOB 变得更简单一点。

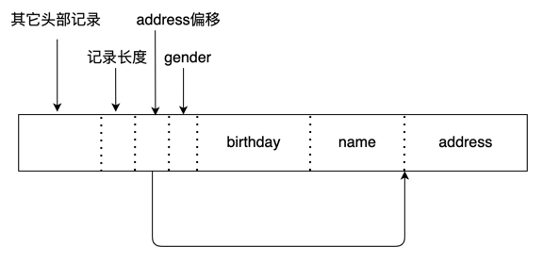

上面的图片展示了 MiniOB 的 Record Manager 是怎么实现的,以及 Record 在文件中是如何组织的。

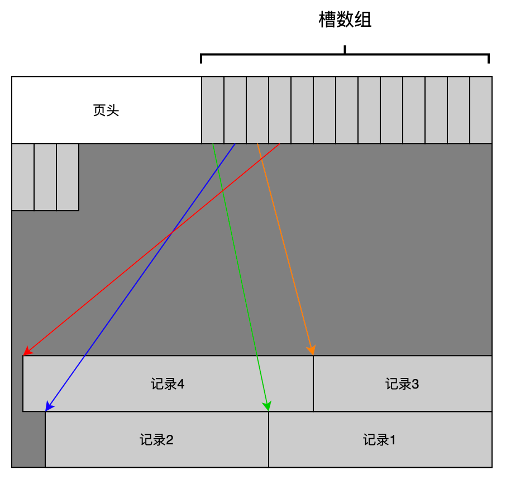

Record Manage 是在 Buffer Pool 的基础上实现的,比如 page0 是 Buffer Pool 里面使用的元数据,Record Manage 利用了其他的一些页面。每个页面有一个头信息 Page Header,一个 Bitmap,Bitmap 为 0 表示最近的记录是不是已经有有效数据;1 表示有有效数据。Page Header 中记录了当前页面一共有多少记录、最多可以容纳多少记录、每个记录的实际长度与对齐后的长度等信息。

MiniOB Double Write Buffer 实现

当前MiniOB的问题

因为buffer内的数据页比文件系统的数据页要大,所以在进行刷盘操作时,可能会发生如下场景:

当数据库准备刷新脏页时,需要多次IO才能加数据页全部写入磁盘。

但当执行完第一次IO时,数据库发生意外宕机,导致此时才刷了一个文件系统里的页,这种情况被称为写失效(partial page write)。

此时重启后,磁盘上的页就是不完整的数据页,就算使用redo log也无法进行恢复。

Double Write Buffer解决的问题

在数据库进行脏页刷新时,如果此时宕机,有可能会导致磁盘数据页损坏,丢失我们重要的数据。此时就算重做日志也是无法进行恢复的,因为重做日志记录的是对页的物理修改。

Double Write其实就是在重做日志前,用户需要一个页的副本,当写入失效发生时,先通过页的副本来还原该页,再进行重做,这就是double write。

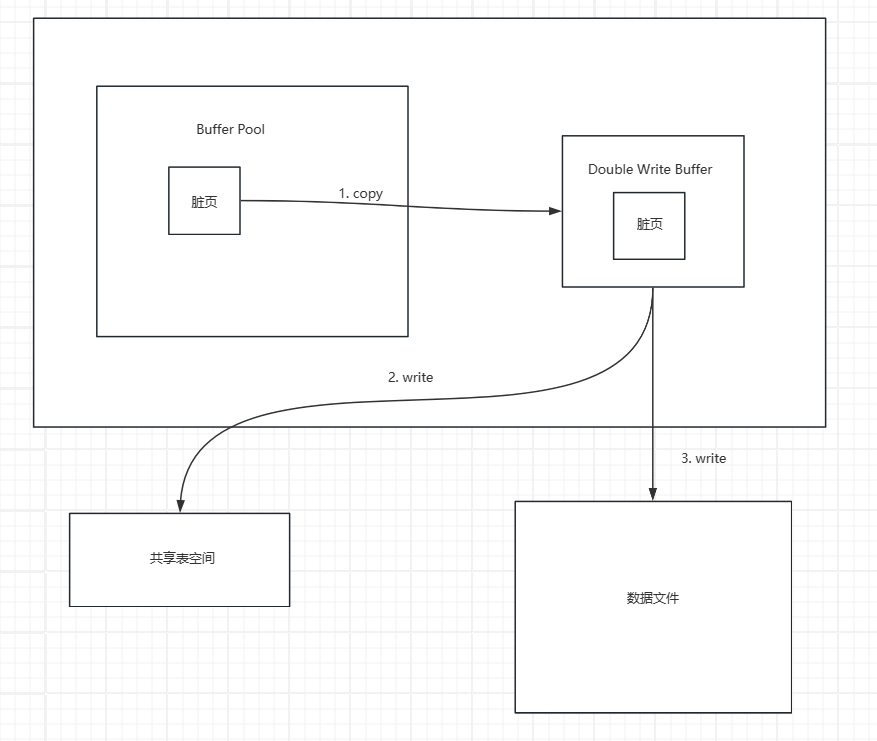

Double Write Buffer架构

Double Write Buffer 工作流程

- 添加页面 :当buffer pool要刷脏页时,不直接写磁盘,而是把脏页添加到double write buffer中,double write buffer再将页面写入共享表空间。

- 读取页面 :当buffer pool要读取页面时,先查看double write buffer中是否存在该页面,若存在,则直接拷贝,若不存在,则从磁盘中读取页面。

- 写入页面 :当double write buffer装满时,double write buffer会先同步磁盘,防止缓冲写带来的问题。再将页面写入对应的数据文件中。

- 崩溃恢复 :当数据库重启恢复时,先读取共享表空间中的文件,若该页面未损坏,则直接拷贝至磁盘中对应的数据页面,若页面损坏,则忽略该页面。此举可以保证数据库在恢复时数据文件中的页面是完好的。

Double Write Buffer的问题

Double write buffer 它是在物理文件上的一个buffer, 其实也就是file,所以它会导致系统有更多的fsync操作,而因为硬盘的fsync性能问题,所以也会影响到数据库的整体性能。

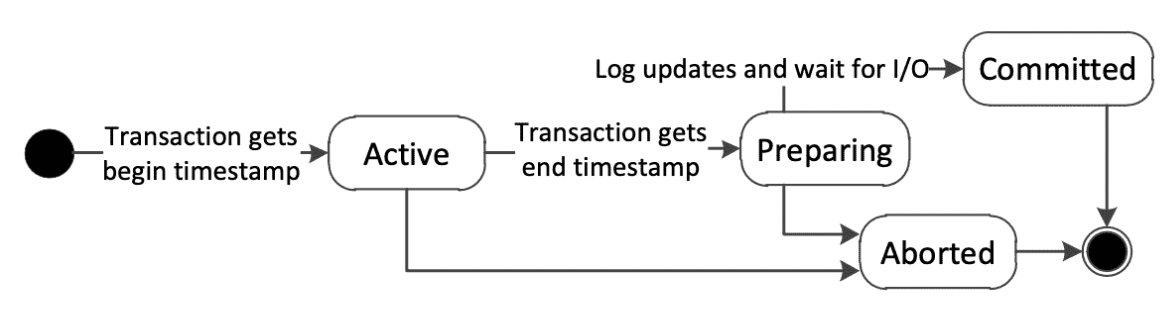

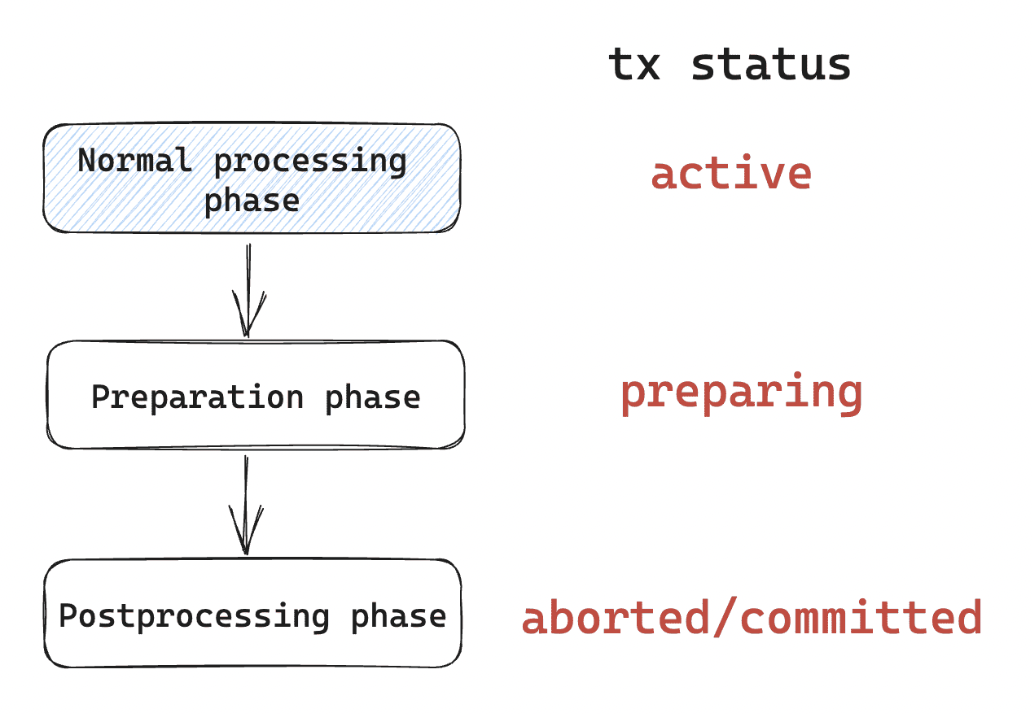

本篇文档介绍 MiniOB 中的事务模块是如何工作的。

背景

事务是数据库中非常基础的一个模块,也是非常核心的功能。事务有一些基本的概念,叫做ACID,分别是原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)和持久性(Durability)。如果你对事务的基本概念不太清楚,建议先学习了解事务的基本概念,比如学习事务处理章节,或者在网上搜索更多资料。

MiniOB 中的事务

实现简介

MiniOB 作为一个帮助学习数据库的代码,为了使其学习起来更简单,实现了两种类型的事务。一个叫做Vacuous,另一个叫做MVCC,可以在启动observer时,选择特定的事务模块。

Vacuous(真空)

顾名思义,这个事务模块,将不会做任何事务相关的处理,这保留了原始的简单性,有利于学习其它模块时,简化调试。

MVCC

多版本并发控制,是一种常见的事务实现。著名的MySQL数据库也支持MVCC,OceanBase也实现了此机制。

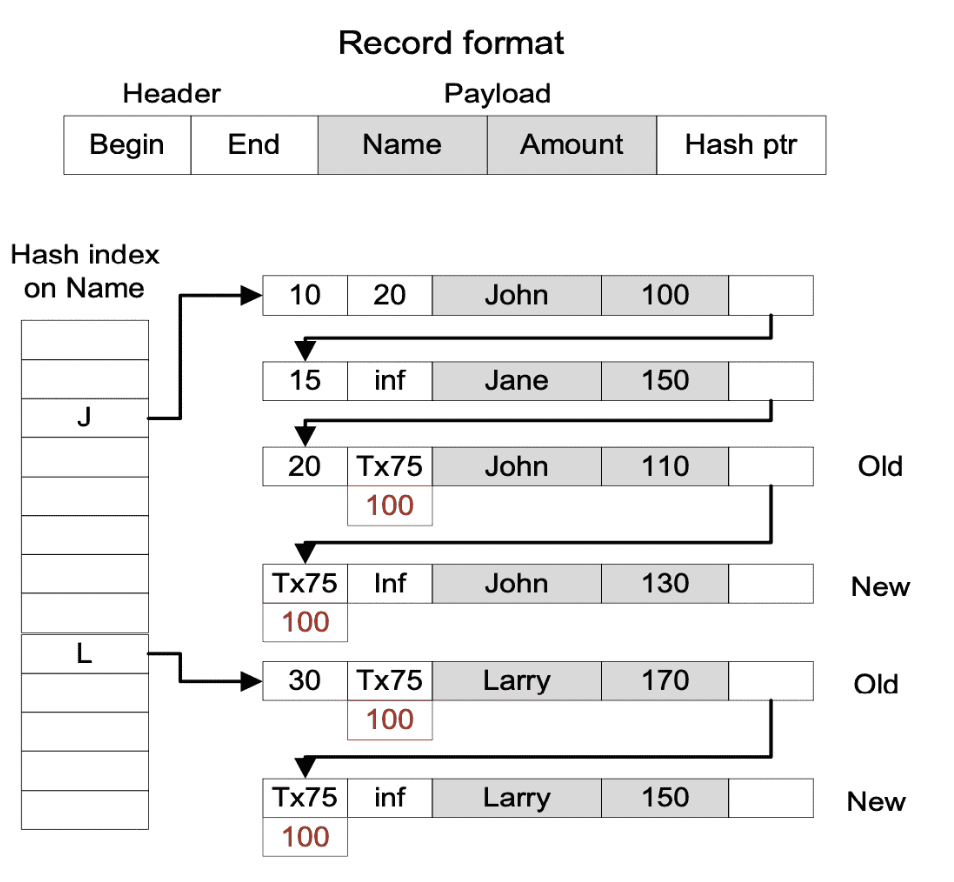

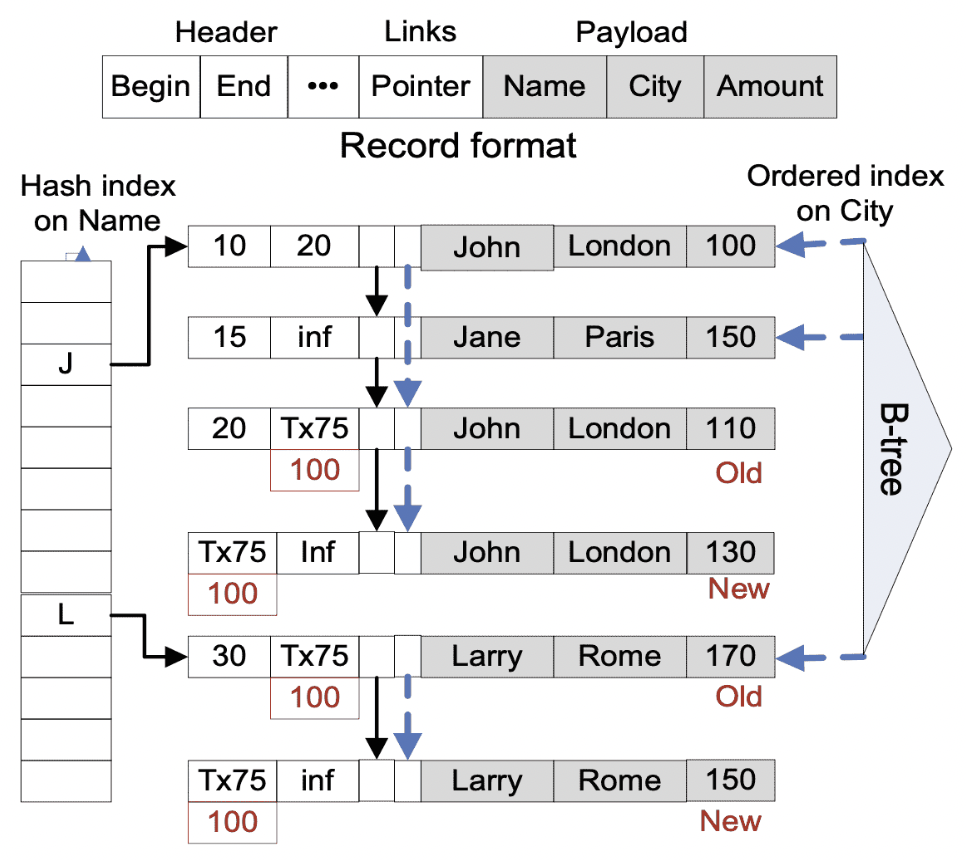

简单来说,MVCC 会在修改数据——MiniOB当前支持插入和删除——时,不会直接在现有的数据上修改,而是创建一个新的行记录,将旧数据复制出来,在新数据上做修改。并将新旧数据使用链表的方式串联起来。每个数据都会有自己的版本号(或者称为时间戳),而版本号通常使用单调递增的数字表示,每个事务根据自己的版本号与数据的版本号,来判断当前能够访问哪个版本的数据。由此可见,MVCC 一个优点就是可以提高只读事务的并发度,它不与其它的写事务产生冲突,因为它访问旧版本的数据就可以了。

NOTE: 不同的数据库,会有不同的实现方式。对MVCC感兴趣的同学,可以阅读一些相关的论文。

如何运行与测试

当前MiniOB支持两种类型的事务模型,并且默认情况下是Vacuous,即不开启事务特性。

测试MVCC

编译时增加选项 -DCONCURRENCY=ON:

cmake -DCONCURRENCY=ON ..

然后在build目录执行 make。编译完成后启动 observer 服务端进程。

也可以使用 bash build.sh -DCONCURRENCY=ON 来编译

可以在启动observer时,增加 -t mvcc 选项来开启MVCC,假设当前目录是build(或build_debug之类):

./bin/observer -f ../etc/observer.ini -s miniob.sock -t mvcc

-f 是配置文件,-s 指使用unix socket,-t 指定使用的事务模型

启动observer后,可以使用obclient连接observer:

./bin/obclient -s miniob.sock

可以开启多个客户端。在命令行界面执行 begin 可以开启事务,执行 commit 提交事务,rollback 回滚事务。

更多的实现原理

事务代码位于 src/observer/storage/trx 目录下,代码很少。

事务模型选择

trx.h 文件中有一个抽象类 TrxKit,它可以根据运行时参数传入的名字来创建对应的 VacuousTrxKit 和 MvccTrxKit。这两个类可以创建相应的事务对象,并且按照需要,初始化行数据中事务需要的额外表字段。当前 Vacuous 什么字段都不需要,而MVCC会额外使用一些表字段。

事务接口

不同的事务模型,使用了一些统一的接口,这些接口定义在 Trx 中。

事务本身相关的操作

- start_if_need。开启一个事务。在SQL请求处理过程中,通常需要开启一个事务;

- commit。提交一个事务;

- rollback。回滚一个事务。

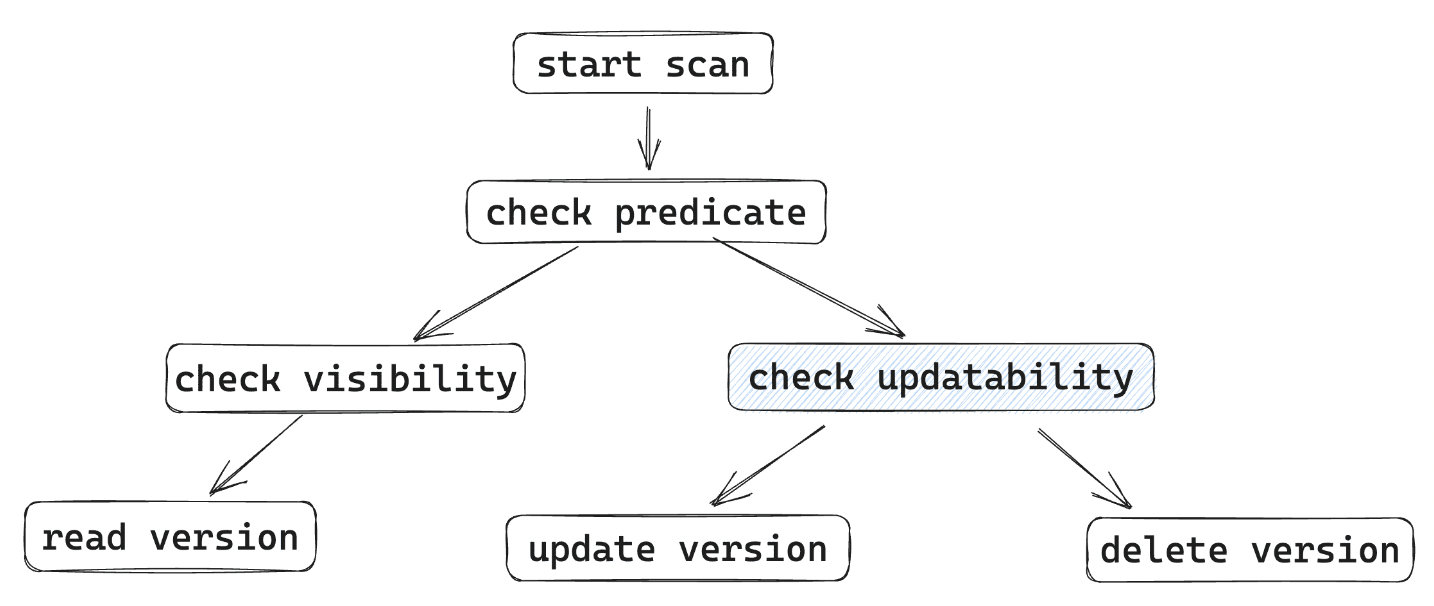

行数据相关的操作

- insert_record。插入一行数据。事务可能需要对记录做一些修改,然后调用table的插入记录接口。提交之前插入的记录通常对其它事务不可见;

- delete_record。删除一行数据。与插入记录类似,也会对记录做一些修改,对MVCC来说,并不是真正的将其删除,而是让他对其它事务不可见(提交后);

- visit_record。访问一行数据。当遍历记录,访问某条数据时,需要由事务来判断一下,这条数据是否对当前事务可见,或者事务有访问冲突。

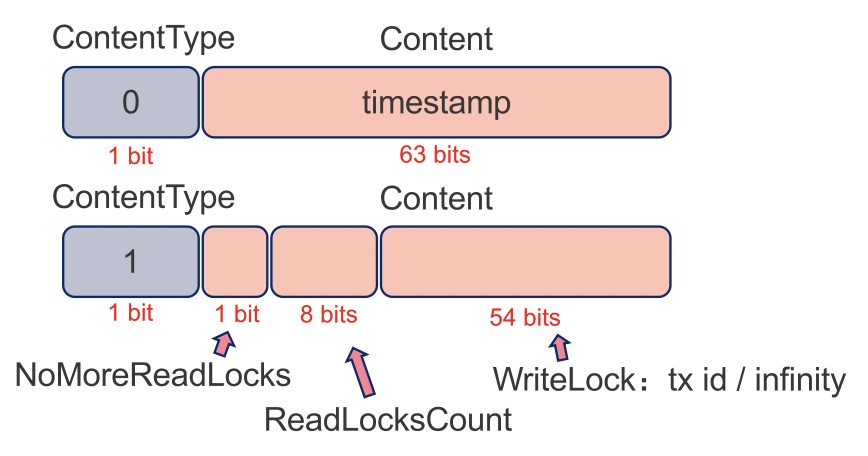

MVCC 相关实现

版本号与可见性

与常见的MVCC实现方案相似,这里也使用单调递增的数字来作为版本号。并且在表上增加两个额外的字段来表示这条记录有效的版本范围。两个版本字段是begin_xid和end_xid。每个事务在开始时,就会生成一个自己的版本号,当访问某条记录时,判断自己的版本号是否在该条记录的版本号的范围内,如果在,就是可见的,否则就不可见。

有些文章或者某些数据库实现中,使用"时间戳"来表示版本号。如果可以保证时间戳也是单调递增的,那这个时间戳确实更好可以作为版本号,并且在分布式系统中,比单纯的单调递增数字更好用。

记录版本号与事务版本号

行数据上的版本号,是事务设置的,这个版本号也是事务的版本号。一个写事务,通常会有两个版本号,在启动时,会生成一个版本号,用来在运行时做数据的可见性判断。在提交时,会再生成一个版本号,这个版本号是最终设置在记录上的。

trx start:

trx_id = next_id()

read record: is_visible(trx_id, record_begin_xid, record_end_xid)

trx commit:

commit_id = next_id()

foreach updated record: update record begin/end xid with commit_id

Q:为什么一定要在提交时生成一个新的版本号?只用该事务之前的版本号不行吗?会有什么问题?

版本号与插入删除

新插入的记录,在提交后,它的版本号是 begin_xid = 事务提交版本号,end_xid = 无穷大。表示此数据从当前事务开始生效,对此后所有的新事务都可见。

而删除相反,begin_xid 保持不变,而 end_xid 变成了当前事务提交的版本号。表示这条数据对当前事务之后的新事务,就不可见了。

记录还有一个中间状态,就是事务刚插入或者删除,但是还没有提交时,这里的修改对其它事务应该都是不可见的。比如新插入一条数据,只有当前事务可见,而新删除的数据,只有当前事务不可见。需要使用一种特殊的方法来标记,当然也是在版本号上做动作。对插入的数据,begin_xid 改为 (-当前事务版本号)(负数),删除记录将end_xid改为 (-当前事务版本号)。在做可见性判断时,对负版本号做特殊处理即可。

假设某个事务运行时trx id是 Ta,提交时是 Tc

| operation | trx state | begin xid | end xid |

|---|---|---|---|

| inserted | committed | Tc | +∞ |

| deleted | committed | some trx_id | Tc |

| insert | uncommit | -Ta | +∞ |

| delete | uncommit | some trx_id | -Ta |

并发冲突处理

MVCC很好的处理了只读事务与写事务的并发,只读事务可以在其它事务修改了某个记录后,访问它的旧版本。但是写事务与写事务之间,依然是有冲突的。这里解决的方法简单粗暴,就是当一个写事务想要修改某个记录时,如果看到有另一个事务也在修改,就直接回滚。如何判断其它事务在修改?判断begin_xid或end_xid是否为负数就可以。

隔离级别

我们通常在聊事务隔离级别时,都会说脏读(Read Uncommitted)、读提交(Read Committed)、可重复读(Repeatable Read)和可串行化(Serializable),说这些时也通常都会提到大名鼎鼎的MySQL。但实际上隔离级别不止是这4种。 不过这里也没有对隔离级别做特殊的处理,让它顺其自然。

Q: 通过上面的描述,你知道这里的MVCC是什么隔离级别吗?

遗留问题和扩展

当前的MVCC是一个简化版本,还有一些功能没有实现,并且还有一些已知BUG。同时还可以扩展更多的事务模型。

-

事务提交时,对外原子可见

当前事务在提交时,会逐个修改之前修改过的行数据,调整版本号。这造成的问题是,在某个时刻,有些行数据的版本号已经修改了,有些还没有。那可能会存在一个事务,能够看到已经修改完成版本号的行,但是看不到未修改的行。 比如事务A,插入了3条数据,在提交的时候,逐个修改版本号,某个情况下可能会存在下面的场景(假设A的事务ID是90,commit id是100):

record begin xid end xid data R1 100 +∞ ... R2 100 +∞ ... R3 -90 +∞ ... 此时有一个新的事务,假设事务号是 110,那么它可以看到记录R1和R2,但是看不到R3,因为R3从记录状态来看,还没有提交。

-

垃圾回收

随着数据库进程的运行,不断有事务更新数据,不断产生新版本的数据,会占用越来越多的资源。此时需要一种机制,来回收对任何事务都不再可见的数据,这称为垃圾回收。垃圾回收也是一个很有趣的话题,实现方式有很多种。最常见的是,开启一个或多个后台线程,定期的扫描所有的行数据,检查它们的版本。如果某个数据对当前所有活跃事务都不可见,那就认为此条数据是垃圾,可以回收掉。当然,这种回收方法最简单,也是最低效的,同学们如何优化或者实现新的回收方法。

-

多版本存储

当前miniob仅实现了插入和删除,并不支持更新操作。而插入和删除最多会存在两个版本的数据,从实现上来看,最多需要一条数据就可以。这大大简化了MVCC的实现。但是也因此没有涉及到MVCC非常核心的多版本数据存储问题。如何合理的存储多个版本的数据,对数据库的性能影响也是巨大的。比如多个版本数据串联时,使用从新到旧,还是从旧到新。两种方式都有合理性,适用于不同的场景。另外还有,多版本的数据存储在哪里?内存还是磁盘,是与原有的数据放在同一个存储空间,还是规划单独的空间,各有什么优缺点,都适用于什么场景。还有,更新数据时,复制整行数据,还是仅记录更新的字段。各有什么优缺点,各适用于什么场景。

-

持久化事务

持久性是事务的基本要素之一,是指事务修改后的数据,在数据库重启或者出现异常时,能够从磁盘中将数据恢复出来。除了将修改的数据直接写入到磁盘,还有一个常用的技术手段是WAL,比如Redo日志和Undo日志。那么什么情况下使用Redo,什么时候使用Undo,以及如果只使用Redo或者只使用Undo会有什么问题。另外还有如何存储这些日志,B+树的持久化怎么处理等。有兴趣的同学可以再了解一下

Steal/No-Steal和Force/No-Force的概念。 -

MVCC的并发控制

如前文描述,这里的写事务并发冲突处理过于简单粗暴,以至于可以避免的冲突却没有避免。

-

基于锁的并发控制

MVCC的并发控制通常认为是乐观事务,就是我们认为此系统中事务之间大部分情况下不会存在冲突。但是在OLTP系统中,访问冲突可能是非常频繁发生的,这时候使用悲观事务,效率会更高一点。常见的悲观事务实现方法就是基于锁来实现。假设使用记录锁(行锁)来实现并发,在读数据时加读锁,写时加写锁,也可以实现多种级别的隔离机制。另外,还可以将使用基于锁的机制与MVCC结合起来,实现更好的并发控制。

顺便提一下一个常见的问题,就是在使用行锁时,如何与页面锁(latch)协调? 大家都知道,latch 都是短锁,在latch保护范围内,都不应该出现长期等待的事情。另外,latch没有死锁检测,不处理锁冲突。而行锁是一种长锁,需要做锁冲突处理,可能需要等待。那在拿着某个latch时,需要等待行锁时,如何处理?

这是很多做了CMU 15445课程的同学没有考虑的问题,15445 课程中将

Lock Manager模块单独拎出来让同学们做练习。但是当行锁与latch同时工作时,它的复杂度将提升好几个量级。

进一步学习

事务是非常复杂非常有趣的,相关的话题也已经有非常多的研究。如果对事务感兴趣,可以在了解数据库整体实现基础之上,深入研究事务的实现原理。 这里推荐一些介绍数据库入门的书籍:

- 《数据库系统概念》该书是数据库领域的经典教材之一,涵盖了数据库基本概念、关系型数据库设计、事务处理、并发控制等方面的内容,也可以着重阅读事务相关的内容

- 《数据库系统实现》:该书是一本数据库系统实现方面的教材,讲解了数据库系统的核心组成部分,包括事务处理、索引、查询优化等方面的内容,对事务处理机制进行了较为细致的讲解

- 《MySQL技术内幕:InnoDB存储引擎》:该书是一本MySQL数据库方面的重要教材,对InnoDB存储引擎的事务处理机制进行了详细的阐述,包括事务的隔离级别、MVCC实现、锁机制等方面。

想直接上手看工业届的事务实现原理,欢迎阅读:

内功深厚想要直接阅读源码:OceanBase 事务源码

还有一些著名开放课程,理论结合实践,比如

如果上面的还感觉太浅,可以持续找一些事务的论文研读:

-

A Critique of ANSI SQL Isolation Levels 该论文针对ANSI SQL标准中隔离级别的定义进行了深入的分析,提出了一些改进的建议。天天看到RC/RR名词的,可以看看这篇论文,了解更详细一点。

-

Granularity of Locks and Degrees of Consistency in a Shared Data Base 这也是一个又老又香的论文,提出了基于锁的并发控制。

-

An Empirical Evaluation of InMemory Multi-Version Concurrency Control 介绍MVCC可扩展性的。通过这篇论文可以对MVCC有非常清晰的认识。

-

Scalable Garbage Collection for In-Memory MVCC Systems 这里对各种垃圾回收算法做了说明,并且有些创新算法。

大家看了这些论文会发现,都是一些陈年老论文。数据库领域发展这么多年了,技术依然不过时。

如果这些还不够,可以问问ChatGPT还有啥资料。如果觉得单机上的玩腻了,可以再看看分布式事务,总之希望你能玩得愉快。

本文介绍 MiniOB 中的 clog 模块是如何工作的。

背景

持久化(Durability) 是事务中非常重要的一个模块,也是最复杂的一个模块,实现持久化才能保证数据不丢失。而持久化同时还要保证事务的原子性与数据完整性。如果对事务的一些概念不太了解,建议先学习了解事务的基本概念,比如学习事务处理章节,或者在网上搜索更多资料。

MiniOB 日志设计与实现

实现简介

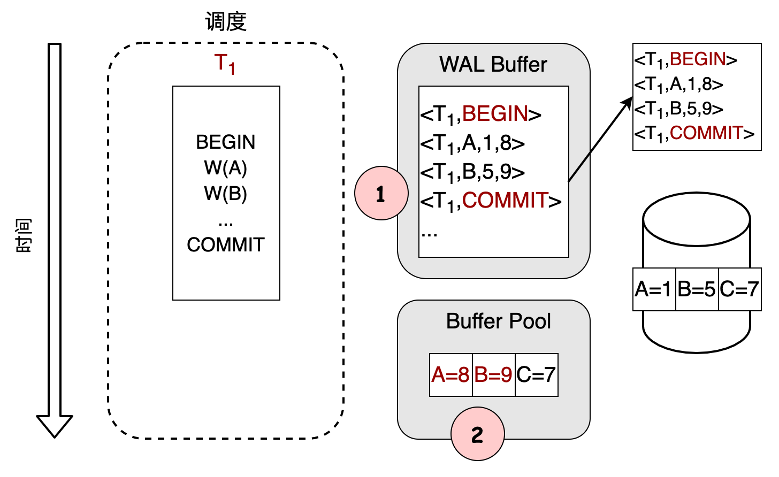

MiniOB 本身使用堆表保存数据,B+树作为索引基础结构。与传统数据库一样,使用 buffer pool manager 管理堆表与索引数据在内存与磁盘中的存放。我们将表数据文件和索引文件(B+树),都使用分页模式进行管理,即在磁盘存储时,它是一个大文件,在读取和写入时,都按照固定大小的页来操作。当我们对数据库数据做修改时,不管修改的内容比较多(几十兆字节)还是比较少(几个字节),我们都会按照修改数据内容所在页面为单元进行操作,包括数据在内存中的修改、持久化到磁盘以及记录相关的日志。当我们对文件内容进行修改时,就会先记录日志,称为Writing Ahead Log(WAL),每次修改后的页面刷新到磁盘之前,都确保对应的日志已经写入到磁盘。

如何运行与测试

以mvcc模式启动miniob:

./bin/observer -f ../etc/observer.ini -s miniob.sock -t mvcc -d disk

其中 -d 参数指定了记录日志的方式,disk 表示将日志记录到磁盘中,vacuous 表示不记录日志。

客户端连接做操作,就可以看到 miniob/db/sys/clog 文件在增长。

如何测试日志恢复流程?

observer运行过程中产生了一些日志,这时执行 kill -9 pidof observer 将服务端进行强制杀死,然后再使用上面的启动命令将服务端启动起来即可。启动时,就会进入到恢复流程。

可以使用 clog_dump 程序读取日志文件,查看日志内容。

(base) build_debug $ ./bin/clog_dump miniob/db/sys/clog/clog_0.log

begin dump file miniob/db/sys/clog/clog_0.log

lsn=1, size=12, module_id=3:TRANSACTION, operation_type:2:COMMIT, trx_id:1, commit_trx_id: 2

lsn=2, size=12, module_id=0:BUFFER_POOL, buffer_pool_id=1, page_num=1, operation_type=0:ALLOCATE

lsn=3, size=16, module_id=2:RECORD_MANAGER, buffer_pool_id:1, operation_type:0:INIT_PAGE, page_num:1, record_size:20

lsn=4, size=36, module_id=2:RECORD_MANAGER, buffer_pool_id:1, operation_type:1:INSERT, page_num:1, slot_num:0

lsn=5, size=20, module_id=3:TRANSACTION, operation_type:0:INSERT_RECORD, trx_id:3, table_id: 0, rid: PageNum:1, SlotNum:0

lsn=6, size=36, module_id=2:RECORD_MANAGER, buffer_pool_id:1, operation_type:3:UPDATE, page_num:1, slot_num:0

lsn=7, size=12, module_id=3:TRANSACTION, operation_type:2:COMMIT, trx_id:3, commit_trx_id: 4

lsn=8, size=36, module_id=2:RECORD_MANAGER, buffer_pool_id:1, operation_type:1:INSERT, page_num:1, slot_num:1

lsn=9, size=20, module_id=3:TRANSACTION, operation_type:0:INSERT_RECORD, trx_id:5, table_id: 0, rid: PageNum:1, SlotNum:1

设计与实现

MiniOB 的持久化模块代码放在 clog 目录中。 CLog 的命名取自 OceanBase 中的日志模块,全称是 commit log。

日志模块设计

日志接口

日志模块对外的接口是 LogHandler,它定义了日志的写入、读取、恢复等接口。有两个实现模式,一个是 DiskLogHandler,一个是 VacuousLogHandler。前者是将日志写入到磁盘中,后者是不记录日志。VacuousLogHandler 虽然也是当前默认的日志记录方式,但它主要是为了方便测试。我们这里只介绍 DiskLogHandler。

日志写入

在程序正常运行过程中,调用DiskLogHandler 的append接口,将日志写入到日志缓冲区(LogEntryBuffer)。DiskLogHandler会启动一个后台线程,不停地将日志缓冲区中的日志写入到磁盘中。

日志缓冲

日志缓冲 LogEntryBuffer 的设计很简单,使用一个列表来记录每条日志。这里是一个优化点,感兴趣的同学欢迎提交PR。

日志文件

为了防止单个日志文件过大,DiskLogHandler 在每个日志文件中存放固定个数的日志,当日志文件满了,会创建新的日志文件。日志文件的命名规则是 clog_0.log、clog_1.log、clog_2.log...。管理日志文件的类是 LogFileManager,负责创建文件、枚举日志文件等,LogFileWriter 负责将日志写入文件,LogFileReader 负责从文件中读取日志。注意,当前没有删除日志文件的接口。

日志内容

日志文件中存放的是一条条数据,写入的时候也是一条条写入的,那这一条日志在代码中就是 LogEntry。一个 LogEntry 包含一个日志头 LogHeader。一个日志头包含日志序列号LSN、不包含日志头的数据大小(size)和日志所属模块(module_id)。

日志序列号 LSN: Log Sequence Number,一个单调递增的数字,每生成一条新的日志,就会加1。并且在对应的磁盘文件页面中,也会记录页面对应日志编号。这样从磁盘恢复时,如果某个页面的LSN比当前要重做的日志LSN要小,就需要重做,否则就不需要重做。

日志数据大小 size: 不包含日志头的日志大小,在 LogEntry 中,通过 payload_size 获取。

日志所属模块 module_id: 持久化模块不仅仅为事务服务,其它的模块,比如B+树,也需要依赖日志来保证数据的完整性和一致性。我们将日志按照模块来划分,在重做时各个模块处理自己的数据。

当前一共有四个模块(参考 LogModule),每个模块负责组织自己的数据内容。在LogEntry中都表述为一个二进制数组 data,在读取和重放时,每个模块自己负责解析具体的数据。

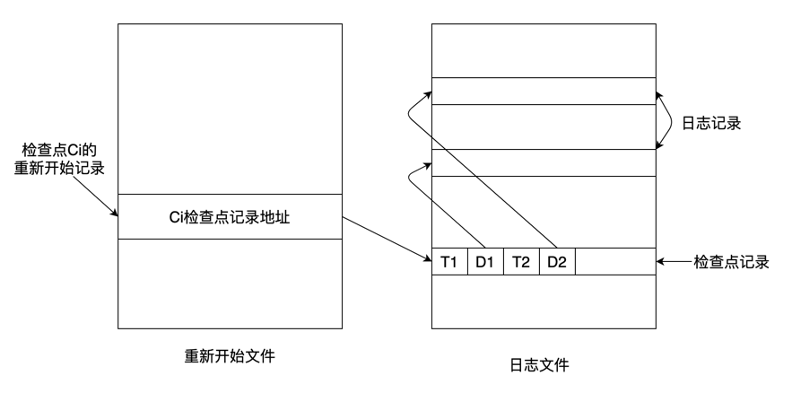

系统快照

我们为了防止日志无限增长,或者减少日志恢复时间,会以不同的方式创建一个系统快照,我们就可以把日志快照之前的日志清除或减少日志恢复时间。

MiniOB的系统快照是在当前没有任何页面更新操作时执行的,其将所有的表相关的文件数据都刷新到磁盘中,然后记录当前日志编号(LSN),作为一次完整的系统快照,代码可以参考 Db::sync。

每次执行完一个DDL任务时,就会执行一次快照操作。 注意,执行快照时(包括DDL),由操作者自己确保当前没有其它任何正在进行的操作,比如插入、删除以及其他的DDL。MiniOB当前并没有做DDL相关的并发控制。

日志重做

当系统出现异常,比如coredump、掉电等,重启后,需要读取本次磁盘中的日志来恢复没有写入磁盘文件中的数据。

通常我们会从一个一致性点开始读取日志重做,一致性点就是最新的一次系统快照。

重做的过程比较简单,我们会把每条日志读取出来(DiskLogHandler::replay),按照日志头中的模块来划分执行每个模块的重放接口(IntegratedLogReplayer::replay)。

Buffer Pool 模块的日志

Buffer Pool 模块对页面数据几乎没有修改,除了分配新的页面和释放页面。Buffer Pool会将文件的第一个页面当做元数据页面,记录当前文件大小、页面分配情况等,也就是说Buffer Pool需要记录的日志有两类(BufferPoolOperation):分配页面、释放页面,并且修改的页面都是第一个页面。我们实现了一个辅助类来帮助记录相关的日志 BufferPoolLogHandler。

Record Manager 模块的日志

Record Manager 负责在表普通数据上进行增删改查记录,也就是行数据管理。除了增删改会对页面进行修改,Record Manager还增加了一类特殊的日志,就是初始化空页面。与 Buffer Pool 日志实现类似,Record Manager 的日志实现在 record_log.h/.cpp 文件中。

B+ 树模块的日志

相对于Buffer Pool和Record Manager来说,B+树的日志要复杂很多。因为Buffer Pool和Record Manager每次修改数据时不会超过一个页面,那我们使用一条简单的日志就可以保证数据的完整性。但是B+树不同,B+树的一次修改可能会涉及多个页面。比如一次插入操作,如果叶子节点满了,就需要分裂成两个页面,然后在它们的父节点上插入一个节点,此时父节点也可能会满导致需要分裂。依次类推,一个插入操作可能会影响多个页面。而我们必须要保证在程序运行时和异常宕机重启通过日志恢复后,还能保持一致性,即这个操作完全执行成功,所有受到影响的页面都恢复,或者恢复到这个操作没有执行的状态,相当于没有插入过这条数据。

MiniOB的解决方法很简单。在每次操作过程中,所有更新过的页面在操作结束之前,都不会刷新到磁盘中。并且我们会把所有页面更新的数据都记录到一个日志中,并且在记录日志时,同时记录页面更新前的数据在内存中,即undo日志。这样,如果某次操作中间过程由于某种原因失败了,我们可以通过undo日志将数据都恢复过来。在宕机重启时,我们每次重做一条B+树日志,也可以完整的恢复出一个操作相关联的所有数据。

将一次操作所有的更新都记录在一个日志中,并可以保证一次操作要么全部成功要么全部失败,我们称为一个MiniTransaction,可以参考代码 BplusTreeMiniTransaction。在其它数据库中,我们也可以看到类似的概念,比如InnoDB中的mini trans,还有些系统称之为系统事务,与用户事务区分开。

B+树涉及到需要记录日志的类型很多,可以参考 bplus_tree::LogOperation。由于每个类型的大小和具体数据都不一样,我们使用各种 Handler 辅助类来帮助序列化反序列化日志,可以参考 LogEntryHandler及其子类。与Buffer Pool和Record Manager不同,这个类增加了 rollback 接口,用于在运行过程中利用Undo数据执行回滚操作。

事务日志

相对于前面介绍的几个模块的日志,事务日志是完全不同的一个层面的内容。Buffer Pool 等模块记录日志是为了确保系统底层数据不会出现不一致的情况,是系统“自己”发起的。而事务不同,事务是用户发起的。事务日志相对于前面几个“系统”日志,有几个不同的地方:

- 由用户发起的,除了系统方面的原因需要回滚,提交或回滚由用户控制的;

- 理论上持续时间任意长。用户可能开启一个事务,但是长时间不提交;

- 事务日志不关联具体的页面,而系统日志都与具体的页面数据修改相关;

- 事务的大小不确定。系统日志通常都是很小的,但是事务日志可能会很大,比如用户增加或删除了几千万条数据。

MiniOB 的事务日志并没有记录每次操作具体的数据,而只是记录操作了什么,比如插入了一条数据,会记录在哪个表的哪个位置上插入了一条数据。具体的数据日志是在Record Manager中记录的。也就是说,整个事务日志是一个逻辑日志,而不是物理日志。同时,MiniOB的整个日志系统是分层的,事务日志依赖Record Manager和B+树,而这两个模块会依赖Buffer Pool。

MiniOB 提供了两种事务模型,MVCC(MvccTrx)和Vacuous(VacuousTrx)。MVCC是多版本并发控制,Vacuous本意是不支持事务,因此也不会记录事务日志。这里仅介绍MVCC模式下的事务日志。

MVCC 相关的日志代码可以参考 mvcc_trx_log.h/.cpp。在一个事务中,我们记录用户执行过什么,比如插入一条数据、删除一条数据与提交或回滚事务,操作类型参考 MvccTrxLogOperation。每条事务日志会包含一个事务头 MvccTrxLogHeader,记录事务ID、操作类型等。在事务提交时,一定会等对应的所有事务日志都写入到磁盘中后,才会返回。

与B+树操作类似,事务也有提交和回滚的概念。但是它们的实现方式不同。通常我们认为,B+树涉及到的数据量比较少,所有操作过的数据,会记录undo日志在内存中,在操作过程中,不会记录日志到磁盘上,在提交时,也不会强制要求将对应的日志刷新到磁盘上。而事务日志不同,因为事务日志的大小不确定、持续时间不确定,我们会在操作执行过程中就会生成一条条日志,通过日志模块写入到缓冲区或者磁盘上。在提交时,为了给用户保证提交的事务不丢失,也必须等日志写入磁盘后再返回。由于在进行过程中就有一部分日志会写入到磁盘上,所以即使事务失败了,我们也会记录一条回滚的日志。

事务的重做

由于事务日志中并不真正的记录修改过的数据,只是记录做过什么操作,也只有不完整的事务,才需要做回滚操作。不完整的事务回滚时,将曾经做过的操作执行一遍逆过程即可。完整的事务,不需要做任何动作,因为不管是提交还是回滚,它的动作都已经真实的处理过了。重做的代码可以参考 MvccTrxLogReplayer 和事务相关的代码 MvccTrx::redo。

一些缺陷和遗留问题

页面丢失的风险

当前设计的分层设计,事务依赖Record Manager和B+树,Record Manager和B+树依赖Buffer Pool,让整体上看起来更清晰,代码也更简单,但是隐藏了一个问题。各层之间的配合与衔接就会出现一些问题。 比如Record Manager中插入了一条数据,此时我们需要申请一个新的页面。那么在日志中会记录:

- Buffer Pool分配了一个新的页面;

- Record Manager初始化了这个页面;

- Record Manager插入了一条数据。

假设在Record Manager在第2步时失败了,我们就会丢失一个页面。因为第2步的失败,是不会回滚第1步的操作,我们并没有把整个操作当做一个事务来处理。这个问题在B+树中也会出现。

日志缓冲设计过于简单

日志缓冲直接放在日志中,没有内存限制,可能会导致内存膨胀。 日志按条缓存,会导致内存碎片,对内存不友好。

页面原子写入问题

一个页面不管是8K还是4K,都存在原子写入问题,即我们现在无法保证一个页面完整的刷新到磁盘上。如果一个页面只写一半在磁盘上,会导致无法判断的一致性问题。这个问题在MySQL中也出现过。

日志文件删除问题

当前没有删除日志文件的接口,会导致日志文件无限增长。

写一半的日志

假设某个日志写入一半的时候停电了,那这个日志在恢复时肯定会失败。如果我们不对这条日志做处理,后面的日志接着文件写,后续这个日志文件就不能再恢复了。通常的处理方法是把这条日志给truncate掉。

扩展

-

ARIES: A Transaction Recovery Method Supporting Fine-Granularity Locking and Partial Rollbacks Using Write-Ahead Logging 该论文提出了ARIES算法,这是一种基于日志记录的恢复算法,支持细粒度锁和部分回滚,可以在数据库崩溃时恢复事务。如果想要对steal/no-force的概念有比较详细的了解,可以直接阅读该论文相关部分。

-

Shadow paging 除了日志做恢复,Shadow paging 是另外一种做恢复的方法。

-

Aether: A Scalable Approach to Logging 介绍可扩展日志系统的。

-

InnoDB之REDO LOG 非常详细而且深入的介绍了一下InnoDB的redo日志。

-

B+树恢复 介绍如何恢复B+树。

-

Principles and realization strategies of multilevel transaction management 介绍了多层事务管理的原理和实现策略。

这部分内容会介绍一些如何对miniob中的词法语法分析模块进行开发与调试,以及依赖的工具。

简介

SQL 解析分为词法分析与语法分析,与编译原理中介绍的类似。这里主要介绍如何扩展MiniOB的SQL解析器,并对词法分析和语法分析文件做一些简单的介绍。

词法分析

词法分析文件 lex_sql.l

词法分析的基本功能是读取文件或字符串的一个一个字符,然后按照特定的模式(pattern)去判断是否匹配,然后输出一个个的token。比如对于 CALC 1+2,词法分析器会输出 CALC、1、+、2、EOF。

扩展功能时,我们最关心的是词法分析的模式如何编写以及flex如何去执行模式解析的。 在lex_sql.l文件中,我们可以看到这样的代码:

[\-]?{DIGIT}+ yylval->number=atoi(yytext); RETURN_TOKEN(NUMBER);

HELP RETURN_TOKEN(HELP);

DESC RETURN_TOKEN(DESC);

CREATE RETURN_TOKEN(CREATE);

DROP RETURN_TOKEN(DROP);

每一行都是一个模式,左边是模式,使用正则表达式编写,右边是我们返回的token,这里的token是枚举类型,是我们在yacc_sql.y中定义的。

[\-]?{DIGIT}+ 就是一个表示数字的正则表达式。

HELP 表示完全匹配"HELP" 字符串。

flex 在匹配这些模式时有一些规则,如果输出的结果与自己的预期不符,可以使用这些规则检查一下,是否自己写的模式和模式中的顺序是否符合这些规则:

- 优先匹配最长的模式

- 如果有多个模式匹配到同样长的字符串,那么优先匹配在文件中靠前的模式

另外还有一些词法分析的知识点,都在lex_sql.l中加了注释,不多做赘述,在这里罗列提示一下。

- flex 根据编写的 .l 规则文件,和指定的命令生成.c代码。不过miniob把.c文件改成了.cpp后缀;

%top{}的代码会放在flex生成的代码最开头的地方;%{ %}中的代码会被移动到flex生成的代码中;- flex提供了一些选项,可以在命令行中指定,也可以在.l文件中,使用 %option指定;

- flex 中编写模式时,有一些变量是预定义的,yylval就是返回值,可以认为是yacc中使用%union定义的结构; yytext 是解析的当前token的字符串,yyleng 是token的长度,yycolumn 是当前的列号,yylineno 是当前行号;

- 如果需要每个token在原始文本中的位置,可以使用宏定义 YY_USER_ACTION,但是需要自己编写代码记录才能传递给yacc;

%% %%之间的代码是模式匹配代码,之后的代码会被复制到生成代码的最后。

语法分析

语法分析文件 yacc_sql.y

语法分析的基本功能是根据词法分析的结果,按照语法规则,生成语法树。

与词法分析类似,语法分析工具(这里使用的是bison)也会根据我们编写的.y规则文件,生成.c代码,miniob 这里把.c代码改成了.cpp代码,因此.y文件中可以使用c++的语法和标准库。

类似词法分析,我们在扩展语法分析时,最关心的也只有规则编写的部分。

在yacc_sql.y文件中,我们可以看到这样的代码:

expression_list:

expression

{

$$ = new std::vector<Expression*>;

$$->emplace_back($1);

}

| expression COMMA expression_list {

if ($3 != nullptr) {

$$ = $3;

} else {

$$ = new std::vector<Expression *>;

}

$$->emplace_back($1);

}

;

这个规则描述表达式列表的语法,表达式列表可以是单个表示,或者"单个表达式 逗号 表达式列表"的形式,第二个规则是一个递归的定义。 可以看到,多个规则模式描述使用 "|" 分开。

为了方便说明,我这里再换一个语句:

create_table_stmt: /*create table 语句的语法解析树*/

CREATE TABLE ID LBRACE attr_def attr_def_list RBRACE

{

$$ = new ParsedSqlNode(SCF_CREATE_TABLE);

CreateTableSqlNode &create_table = $$->create_table;

create_table.relation_name = $3;

free($3);

std::vector<AttrInfoSqlNode> *src_attrs = $6;

if (src_attrs != nullptr) {

create_table.attr_infos.swap(*src_attrs);

}

create_table.attr_infos.emplace_back(*$5);

std::reverse(create_table.attr_infos.begin(), create_table.attr_infos.end());

delete $5;

}

;

每个规则描述,比如create_table_stmt 都会生成一个结果,这个结果在.y中以 "$$" 表示,某个语法中描述的各个token,按照顺序可以使用 "$1 $2 $3" 来引用,比如ID 就是 $3, attr_def 是 $5。"$n" 的类型都是 YYSTYPE。YYSTYPE 是bison根据.y生成的类型,对应我们的规则文件就是 %union,YYSTYPE 也是一个union结构。比如 我们在.y文件中说明 %type <sql_node> create_table_stmt,表示 create_table_stmt 的类型对应了 %union 中的成员变量 sql_node。我们在 %union 中定义了 ParsedSqlNode * sql_node;,那么 create_table_stmt 的类型就是 ParsedSqlNode *,对应了 YYSTYPE.sql_node。

%union 中定义的数据类型,除了简单类型,大部分是在parse_defs.h中定义的,表达式Expression是在expression.h中定义的,Value是在value.h中定义的。

由于在定义语法规则时,这里都使用了左递归,用户输入的第一个元素会放到最前面,因此在计算得出最后的结果时,我们需要将列表(这里很多使用vector记录)中的元素逆转一下。

语法分析中如何使用位置信息

首先我们要在.y文件中增加%locations,告诉bison我们需要位置信息。其次需要与词法分析相配合,需要词法分析返回一个token时告诉语法分析此token的位置信息,包括行号、token起始位置和结束位置。与访问规则结果 $$ 类似,访问某个元素的位置信息可以使用 @$、 @1、@2 等。

词法分析中,yylineno记录当前是第几行,不过MiniOB当前没有处理多行文本。yycolumn记录当前在第几列,yyleng记录当前token文本的长度。词法分析提供了宏定义 YY_USER_INIT 可以在每次解析之前执行一些代码,而 YY_USER_ACTION 宏在每次解析完token后执行的代码。我们可以在YY_USER_INIT宏中对列号进行初始化,然后在YY_USER_ACTION计算token的位置信息,然后使用 yylloc 将位置信息传递给语法分析。而在引用 @$ 时,就是引用了 yylloc。

这些宏定义和位置的引用可以参考lex_sql.l和yacc_sql.y,搜索相应的关键字即可。

如果觉得位置信息传递和一些特殊符号 $$或 @$ 等使用感到困惑,可以直接看 flex和bison生成的代码,会让自己理解的更清晰。

如何编译词法分析和语法分析模块

在 src/observer/sql/parser/ 目录下,执行以下命令:

./gen_parser.sh

将会生成词法分析代码 lex_sql.h 和 lex_sql.cpp,语法分析代码 yacc_sql.hpp 和 yacc_sql.cpp。

注意:flex 使用 2.5.35 版本测试通过,bison使用3.7版本测试通过(请不要使用旧版本,比如macos自带的bision)。

注意:当前没有把lex_sql.l和yacc_sql.y加入CMakefile.txt中,所以修改这两个文件后,需要手动生成c代码,然后再执行编译。

如果使用visual studio code,可以直接选择 "终端/Terminal" -> "Run task..." -> "gen_parser",即可生成代码。

如何调试词法分析和语法分析模块

代码中可以直接使用日志模块打印日志,对于yacc_sql.y也可以直接使用gdb调试工具调试。

参考

本文介绍如何新增一种类型的SQL语句。

当前的SQL实现已经比较复杂,这里以新增一个简单的SQL语句为例,介绍如何新增一种类型的SQL语句。 在介绍如何新增一种类型的SQL语句之前,先介绍一下MiniOB的SQL语句的执行流程。

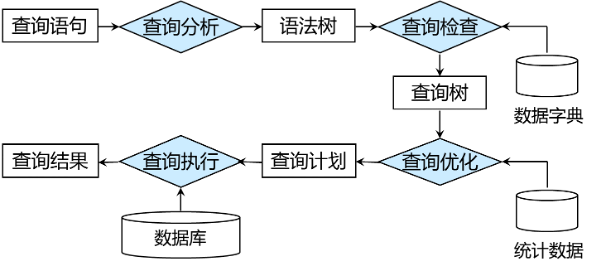

SQL语句执行流程

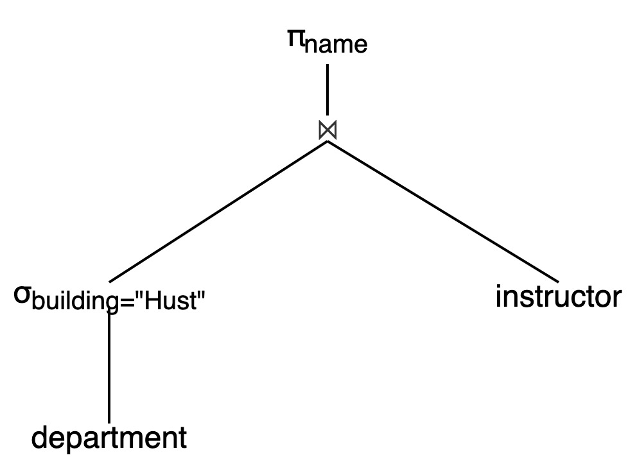

MiniOB的SQL语句执行流程如下图所示:

左侧是执行流程节点,右侧是各个执行节点输出的数据结构。

┌──────────────────┐ ┌──────────────────┐

│ SQL │ ---> │ String │

└────────┬─────────┘ └──────────────────┘

│

┌────────▼─────────┐ ┌──────────────────┐

│ Parser │ ---> │ ParsedSqlNode |

└────────┬─────────┘ └──────────────────┘

│

│

┌────────▼─────────┐ ┌──────────────────┐

│ Resolver │ ---> │ Statement │

└────────┬─────────┘ └──────────────────┘

│

│

┌────────▼─────────┐ ┌──────────────────┐

│ Transformer │ ---> │ LogicalOperator |

└────────┬─────────┘ │ PhysicalOperator │

│ │ or │

┌────────▼─────────┐ │ CommandExecutor |

│ Optimizer │ ---> │ │

└────────┬─────────┘ └──────────────────┘

│

┌────────▼─────────┐ ┌──────────────────┐

│ Executor │ ---> │ SqlResult │

└──────────────────┘ └──────────────────┘

- 我们收到了一个SQL请求,此请求以字符串形式存储;

- 在Parser阶段将SQL字符串,通过词法解析(lex_sql.l)与语法解析(yacc_sql.y)解析成ParsedSqlNode(parse_defs.h);

- 在Resolver阶段,将ParsedSqlNode转换成Stmt(全称 Statement, 参考 stmt.h);

- 在Transformer和Optimizer阶段,将Stmt转换成LogicalOperator,优化后输出PhysicalOperator(参考 optimize_stage.cpp)。如果是命令执行类型的SQL请求,会创建对应的 CommandExecutor(参考 command_executor.cpp);

- 最终执行阶段 Executor,工作量比较少,将PhysicalOperator(物理执行计划)转换为SqlResult(执行结果),或者将CommandExecutor执行后通过SqlResult输出结果。

新增一种类型的SQL语句

这里将以CALC类型的SQL为例介绍。

CALC 不是一个标准的SQL语句,它的功能是计算给定的一个四则表达式,比如:

CALC 1+2*3

CALC 在SQL的各个流程中,与SELECT语句非常类似,因此在增加CALC语句时,可以参考SELECT语句的实现。

首先在Parser阶段,我们需要考虑词法分析和语法分析。CALC 中需要新增的词法不多,简单的四则运算中只需要考虑数字、运算符号和小括号即可。在增加CALC之前,只有运算符号没有全部增加,那我们加上即可。参考 lex_sql.l。

"+" |

"-" |

"*" |

"/" { return yytext[0]; }

在语法分析阶段,我们参考SELECT相关的一些解析,在yacc_sql.y中增加CALC的一些解析规则,以及在parse_defs.h中SELECT解析后的数据类型,编写CALC解析出来的数据类型。 当前CALC是已经实现的,可以直接在parse_defs.h中的类型定义。 yacc_sql.y中需要增加calc_stmt,calc_stmt的类型,以及calc_stmt的解析规则。由于calc_stmt涉及到表达式运算,所以还需要增加表达式的解析规则。具体可以参考yacc_sql.y中关于calc的代码。

在语法解析结束后,输出了CalcSqlNode,后面resolver阶段,将它转换为Stmt,这里就是新增CalcStmt。通常在resolver阶段会校验SQL语法树的合法性,比如查询的表是否存在,运算类型是否正确。在CalcStmt中,逻辑比较简单,没有做任何校验,只是将表达式记录下来,并且认为这里的表达式都是值类型的计算。

在Transformer和Optmize阶段,对于查询类型的SQL会生成LogicalOperator和PhysicalOperator,而对于命令执行类型的SQL会生成CommandExecutor。CALC是查询类型的SQL,参考SELECT的实现,在SELECT中,有PROJECT、TABLE_SCAN等类型的算子,而CALC比较简单,我们新增CalcLogicalOperator和CalcPhysicalOperator。

由于具有执行计划的SQL,在Executor阶段,我们仅需要给SqlResult设置对应的TupleSchema即可,可以参考ExecuteStage::handle_request_with_physical_operator。

总结一下,新增一种类型的SQL,需要在以下几个地方做修改:

- 词法解析,增加新的词法规则(lex_sql.l);

- 语法解析,增加新的语法规则(yacc_sql.y);

- 增加新的SQL语法树类型(parse_defs.h);

- 增加新的Stmt类型(stmt.h);

- 增加新的LogicalOperator和PhysicalOperator(logical_operator.h, physical_operator.h, optimize_stage.cpp,如果有需要);

- 增加新的CommandExecutor(command_executor.cpp,如果有需要);

- 设置SqlResult的TupleSchema(execute_stage.cpp,如果有需要)。

本文介绍如何解析表达式

介绍

表达式是SQL操作中非常基础的内容。

我们常见的表达式就是四则运算的表达式,比如1+2、3*(10-3)等。在常见的数据库中,比如MySQL、OceanBase,可以运行 select 1+2、select 3*(10-3),来获取这种表达式的结果。但是同时在SQL中,也可以执行 select 1、select field1 from table1,来查询一个常量或者一个字段。那我们就可以把表达式的概念抽象出来,认为常量、四则运算、表字段、函数调用等都是表达式。

MiniOB 中的表达式实现

当前MiniOB并没有实现上述的所有类型的表达式,而是选择扩展SQL语法,增加了 CALC 命令,以支持算术表达式运算。这里就以 CALC 支持的表达式为例,介绍如何在 MiniOB 中实现表达式。

本文的内容会有一部分与 如何新增一种类型的SQL语句 重复,但是这里会更加详细的介绍表达式的实现。

这里假设大家对 MiniOB 的SQL运行过程有一定的了解,如果没有,可以参考 如何新增一种类型的SQL语句 的第一个部分。

在介绍实现细节之前先看下一个例子以及它的执行结果:

CALC 1+2

执行结果:

1+2

3

注意这个表达式输出时会输出表达式的原始内容。

SQL 语句

MiniOB 从客户端接收到SQL请求后,会创建 SessionEvent,其中 query_ 以字符串的形式保存了SQL请求。

比如 CALC 1+2,记录为"CALC 1+2"。

SQL Parser

Parser部分分为词法分析和语法分析。

如果对词法分析语法分析还不了解,建议先查看 SQL Parser。

词法分析

算术表达式需要整数、浮点数,以及加减乘除运算符。我们在lex_sql.l中可以看到 NUMBER 和 FLOAT的token解析。运算符的相关模式匹配定义如下:

"+" |

"-" |

"*" |

"/" { return yytext[0]; }

语法分析

因为 CALC 也是一个完整的SQL语句,那我们先给它定义一个类型。我们定义一个 CALC 语句可以计算多个表达式的值,表达式之间使用逗号分隔,那 CalcSqlNode 定义应该是这样的:

struct CalcSqlNode

{

std::vector<Expression *> expressions;

};

在 yacc_sql.y 文件中,我们增加一种新的语句类型 calc_stmt,与SELECT类似。它的类型也是sql_node:

%type <sql_node> calc_stmt

接下来分析 calc_stmt 的语法规则。

calc_stmt:

CALC expression_list

{

$$ = new ParsedSqlNode(SCF_CALC); // CALC的最终类型还是一个ParsedSqlNode

std::reverse($2->begin(), $2->end()); // 由于左递归的原因,我们需要得出列表内容后给它反转一下

// 直接从 expression_list 中拿出数据到目标结构中,省的再申请释放内存

$$->calc.expressions.swap(*$2);

delete $2; // expression_list 本身的内存不要忘记释放掉

}

;

CALC expression_list CALC 仅仅是一个关键字。expression_list 是表达式列表,我们需要对它的规则作出说明,还要在%union和 %type 中增加其类型说明。

%union {

...

std::vector<Expression *> *expression_list;

...

}

...

%type <expression_list> expression_list

expression_list 的规则如下:

expression_list:

expression // 表达式列表可以是单个表达式

{

$$ = new std::vector<Expression*>;

$$->emplace_back($1);

}

// 表达式列表也可以是逗号分隔的多个表达式,使用递归定义的方式说明规则

| expression COMMA expression_list

{

if ($3 != nullptr) {

$$ = $3;

} else {

$$ = new std::vector<Expression *>; // 表达式列表的最终类型

}

$$->emplace_back($1); // 目标结果中多了一个元素。

}

;

expression 的规则会比较简单,加减乘除,以及负号取反。这里与普通的规则不同的是,我们需要关心运算符的优先级,以及负号运算符的特殊性。

优先级规则简单,乘除在先,加减在后,如果有括号先计算括号的表达式。

%left '+' '-'

%left '*' '/'

%left 表示左结合,就是遇到指定的符号,先跟左边的符号结合。而定义的顺序就是优先级的顺序,越靠后的优先级越高。

负号运算符的特殊性除了它的优先级,还有它的结合性。普通的运算,比如 1+2,是两个数字即两个表达式,一个运算符。而负号的表示形式是 -(1+2),即一个符号,一个表达式。

%nonassoc UMINUS

表示 UMINUS 是一个一元运算符,没有结合性。在.y中,放到了 %left '*' '/' 的后面,说明优先级比乘除运算符高。

expression 的规则如下:

expression '+' expression {

$$ = create_arithmetic_expression(ArithmeticExpr::Type::ADD, $1, $3, sql_string, &@$);

}

| expression '-' expression {

$$ = create_arithmetic_expression(ArithmeticExpr::Type::SUB, $1, $3, sql_string, &@$);

}

| expression '*' expression {

$$ = create_arithmetic_expression(ArithmeticExpr::Type::MUL, $1, $3, sql_string, &@$);

}

| expression '/' expression {

$$ = create_arithmetic_expression(ArithmeticExpr::Type::DIV, $1, $3, sql_string, &@$);

}

| LBRACE expression RBRACE { // '(' expression ')'

$$ = $2;

$$->set_name(token_name(sql_string, &@$));

}

// %prec 告诉yacc '-' 负号预算的优先级,等于UMINUS的优先级

| '-' expression %prec UMINUS {

$$ = create_arithmetic_expression(ArithmeticExpr::Type::NEGATIVE, $2, nullptr, sql_string, &@$);

}

| value {

$$ = new ValueExpr(*$1);

$$->set_name(token_name(sql_string, &@$));

delete $1;

}

;

create_arithmetic_expression 是一个创建算术表达式的函数,它的实现在.y文件中,不再罗列。

表达式的名称,需要在输出结果中展示出来。我们知道当前的SQL语句,也知道某个token的开始列号与截止列号,就可以计算出来这个表达式对应的SQL命令输入是什么。在 expression 规则描述中,就是 $$->set_name(token_name(sql_string, &@$));,其中 sql_string 就是当前的SQL语句,@$ 是当前的token的位置信息。

抽象表达式类型

上面语法分析中描述的都是算术表达式,但是真实的SQL语句中,像字段名、常量、比较运算、函数、子查询等都是表达式。我们需要定义一个基类,然后派生出各种表达式类型。

这些表达式的定义已经在expression.h中定义,但是没有在语法解析中体现。更完善的做法是在 select 的属性列表、where 条件、insert 的 values等语句中,都使用表达式来表示。

'-' 缺陷

由于在词法分析中,负号'-'与数字放在一起时,会被认为是一个负值数字,作为一个完整的token返回给语法分析,所以当前的语法分析无法正确的解析下面的表达式:

1 -2;

这个表达式的结果应该是 -1,但是当前的语法分析会认为是两个表达式,一个是1,一个是-2,这样就无法正确的计算出结果。 当前修复此问题的成本较高,需要修改词法分析的规则,所以暂时不做处理。

MiniOB B+Tree 实现

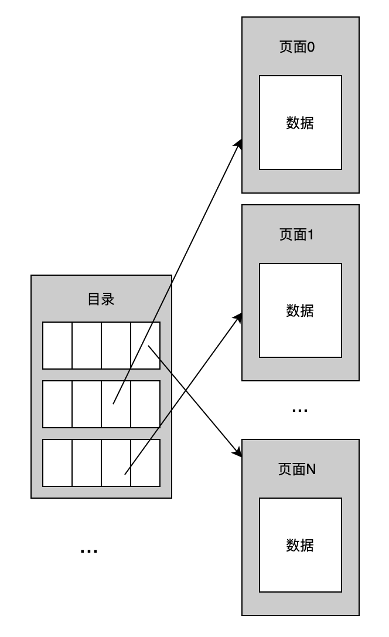

简介

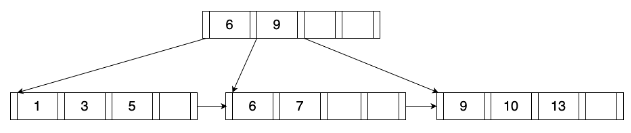

在基本的逻辑上,MiniOB 的 B+Tree 和 B+Tree 是一致的,查询和插入都是从根逐层定位到叶结点,然后在叶结点内获取或者插入。如果插入过程发生叶结点满的情况,同样会进行分裂,并向上递归这一过程。

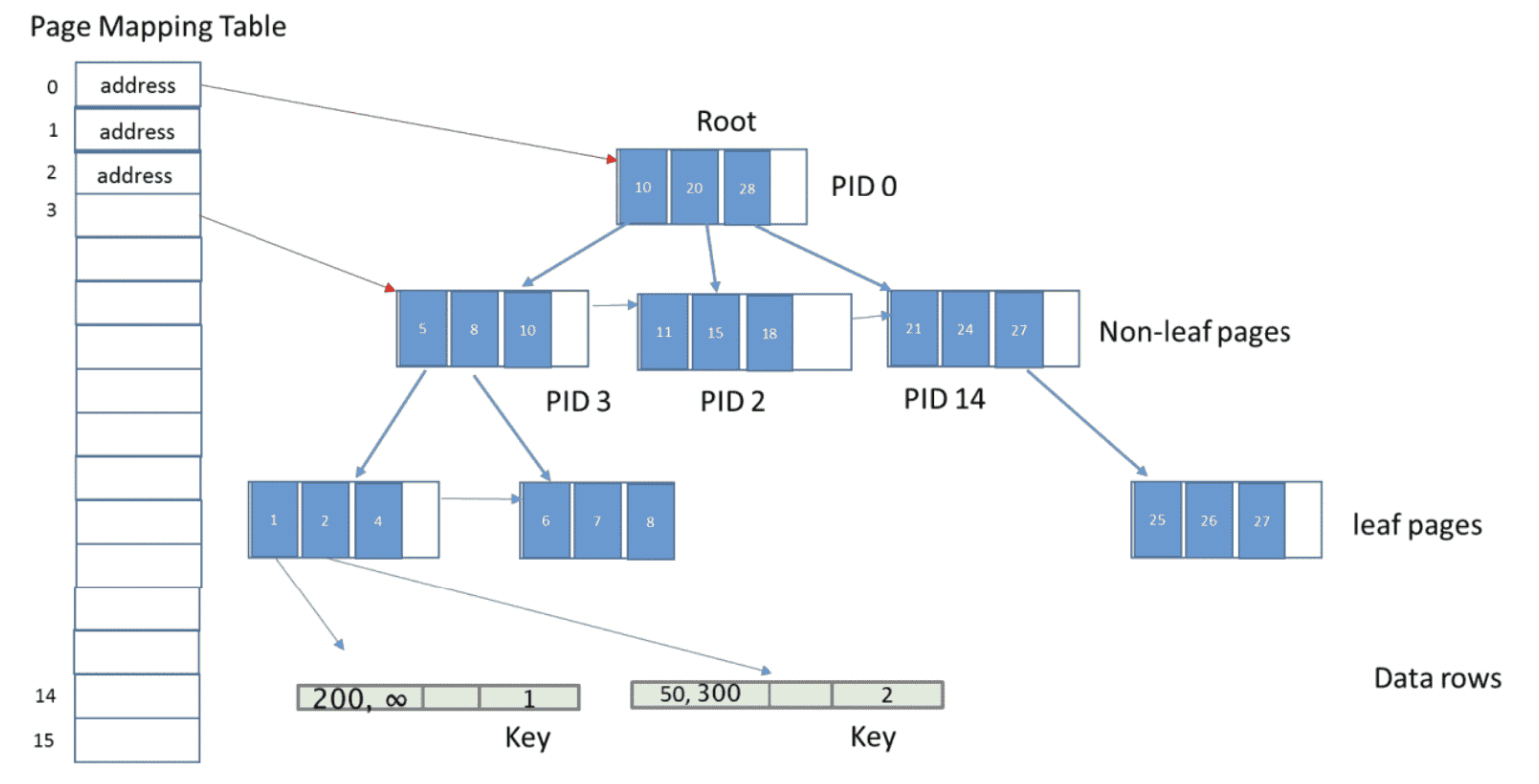

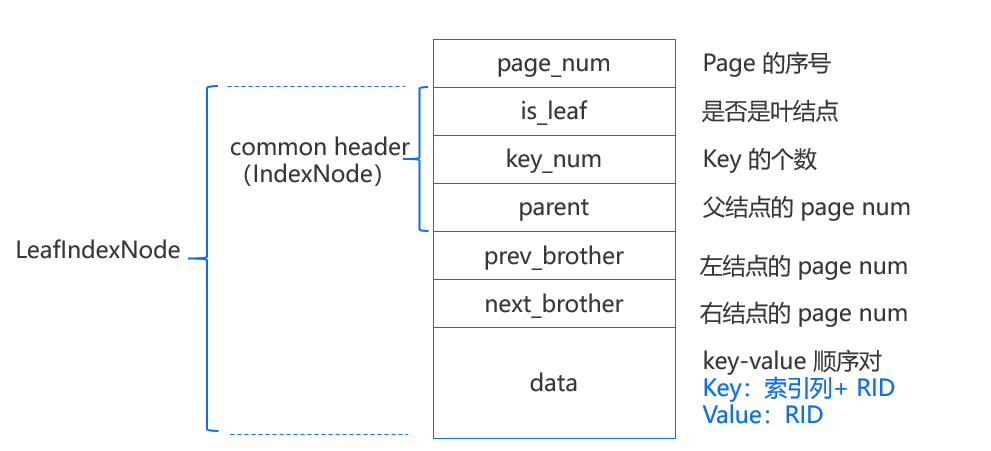

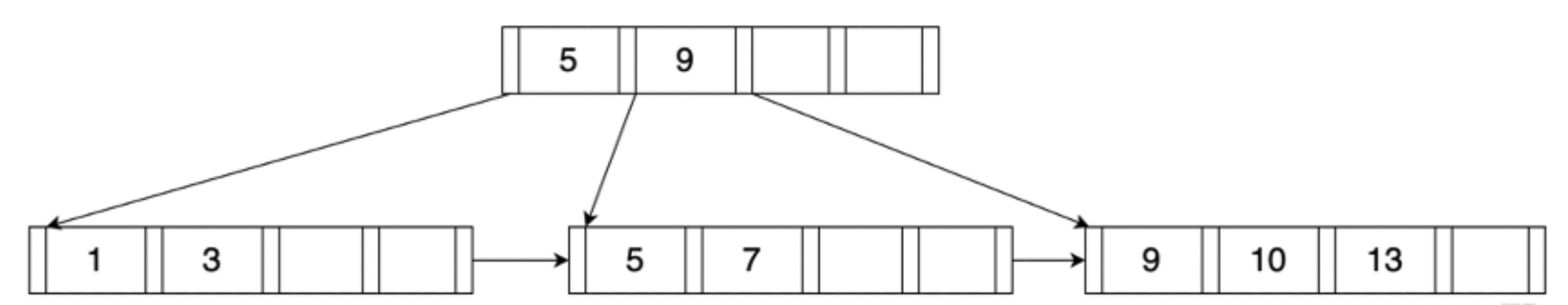

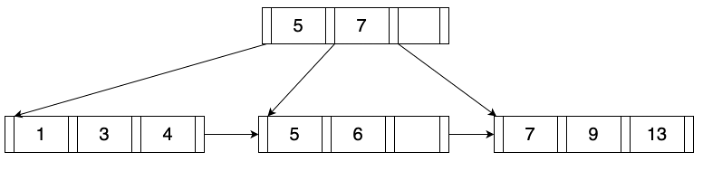

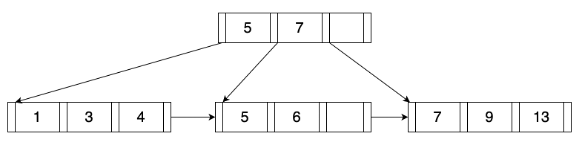

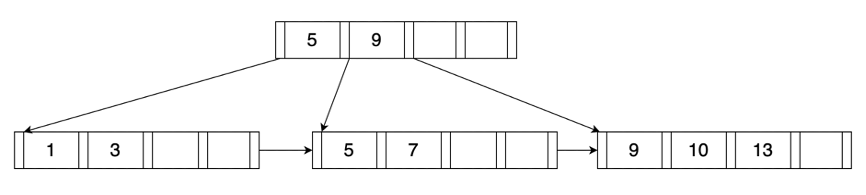

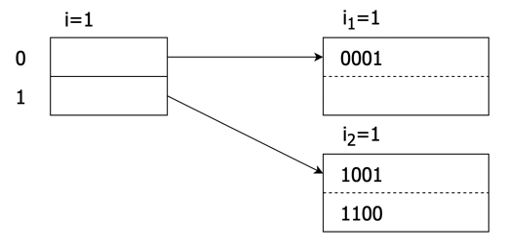

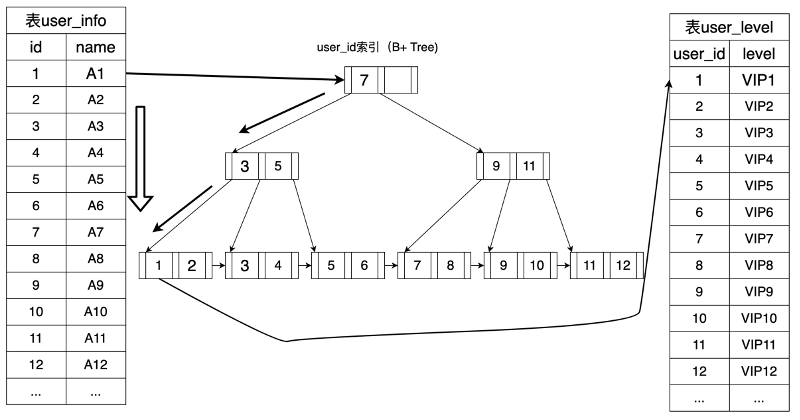

如上图,每个结点组织成一个固定大小的 page,之前介绍过每个 page 首先有一个 page_num 表示 page 在文件中的序号,每个结点 page 都有一个common header 实现为 IndexNode 结构,其中包括 is_leaf(是否为叶结点)、key_num(结点中 key 的个数)、parent(结点父结点的 page num),当 parent=-1 时表示该结点没有父结点。

除此之外,Leaf page 还有 prev_brother(左结点的 page num)和 next_brother(右结点的 page num),这两项用于帮助遍历。最后 page 所剩下的空间就顺序存放键值对,叶结点所存放的 key 是索引列的值加上 RID(该行数据在磁盘上的位置),Value 则为 RID,也就是说键值数据都是存放在叶结点上的,和 B+Tree 中叶结点的值是指向记录的指针不同。

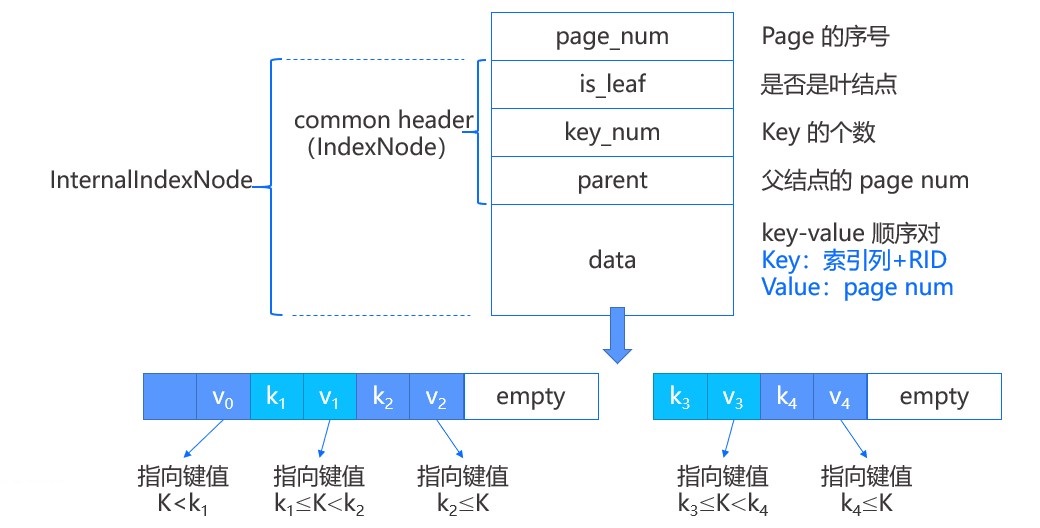

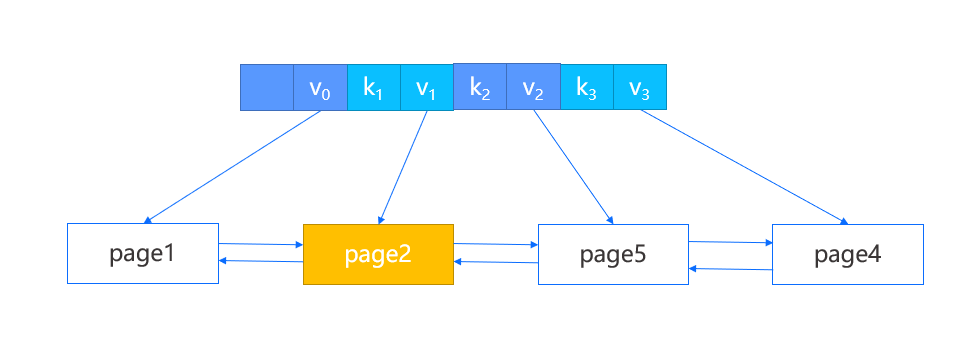

内部结点和叶结点有两点不同,一个是没有左右结点的 page num;另一个是所存放的值是 page num,也就是标识了子结点的 page 位置。如上图所示,键值对在内部结点是这样表示的,第一个键值对中的键是一个无效数据,真正用于比较的只有 k1 和 k2。

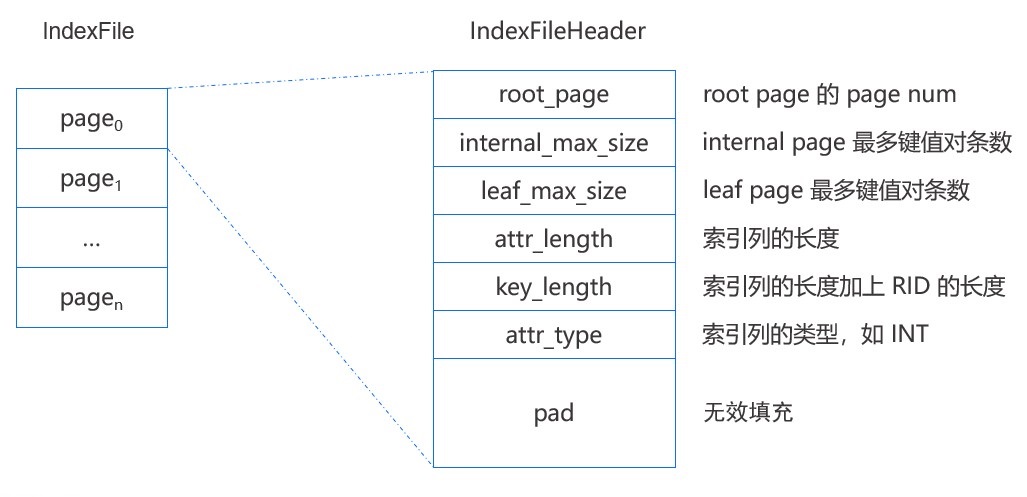

所有的结点(即 page)都存储在外存的索引文件 IndexFile 中,其中文件的第一个 page 是索引文件头,存储了一些元数据,如 root page 的 page num,内部结点和叶子结点能够存储键值对的最大个数等。

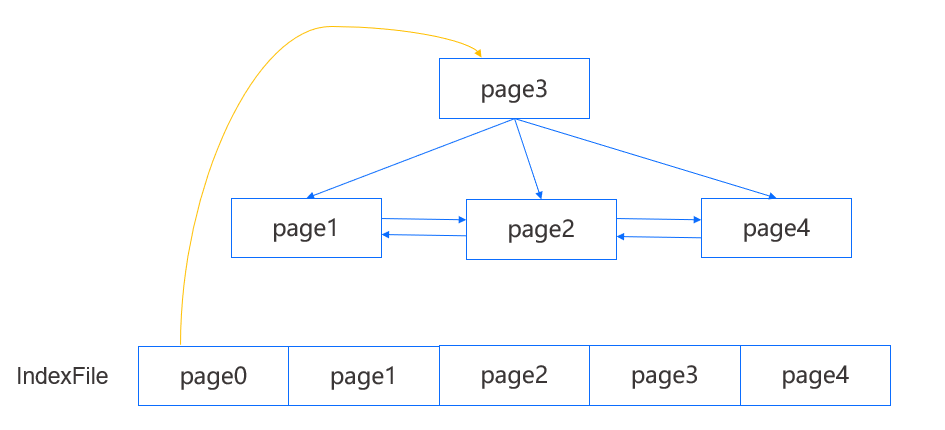

上图是一个简单的 MiniOB B+Tree 示例,其中叶结点能够访问到左右结点,并且每个结点能够访问到父结点。我们能够从 IndexFile 的第一个 page 得到 root page,而在知道一棵 B+Tree 的 root page 以后就足够访问到任意一个结点了。查询时我们会从 root page 开始逐层向下定位到目标叶结点,在每个 page 内遍历搜索查找键。

插入

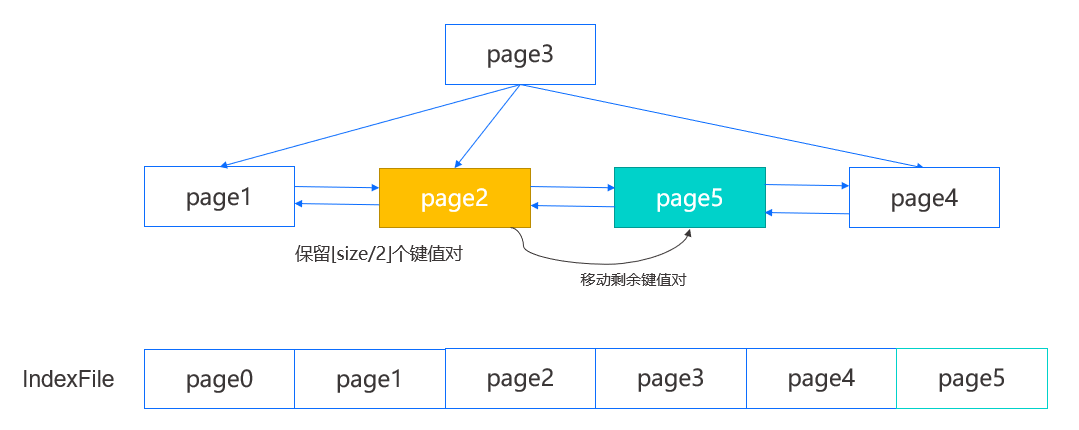

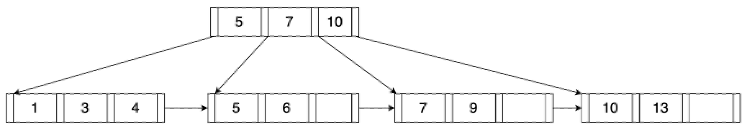

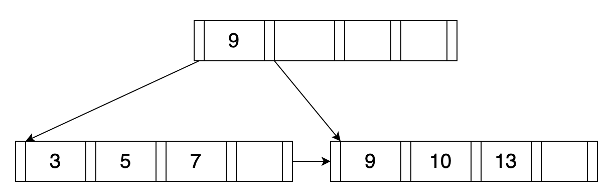

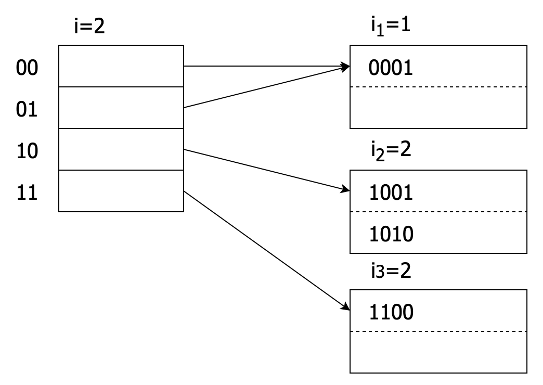

在插入时,我们首先定位到叶结点,如下图中的 page2,然后在结点内定位一个插入位置,如果结点未满,那么将键值对插入指定位置并向后移动部分数据即可;如果结点已满,那么需要对其进行分裂。

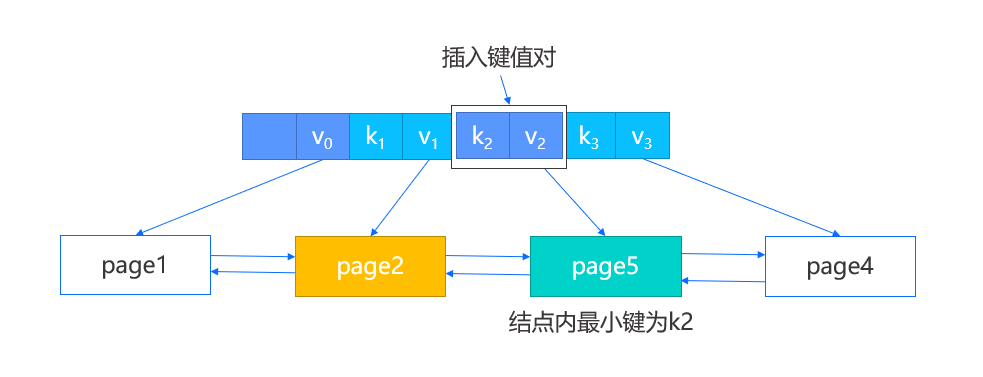

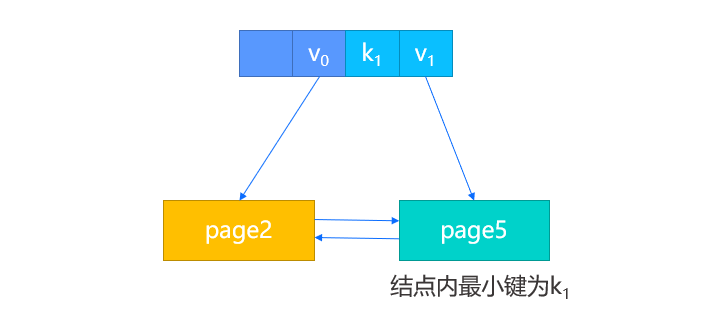

我们将先创建一个新的右兄弟结点,即 page5,然后在原结点内保留前一半的键值对,剩余的键值对则移动到新结点,并修改 page2 的后向 page num,page5 的前后向 page num 以及 page4 的前向 page num,再根据之前定位的插入位置判断是插入 page2 还是 page5 ,完成叶结点的插入。

此外,由于我们新增了结点,我们需要在父结点也插入新的键值对,这一步将涉及到原结点,新结点以及新结点中的最小键,分为以下两种情况:

-

有父结点,那么直接将新结点中的最小键以及新结点的 page num 作为键值对插入父结点即可。

-

假设此时没有父结点,那么我们将创建一个新的根结点,除了把新结点键值对插入,还会将原结点的 page num 作为第一个键值对的值进行插入。

如果父结点的键值对插入同样触发了分裂,我们将按上述的步骤递归执行。

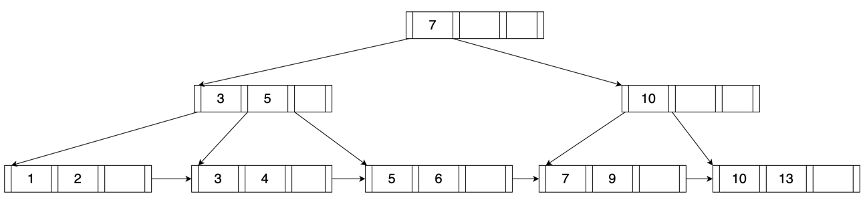

删除

正常的删除操作我们就不再介绍,这里介绍一些涉及结点合并的特殊情况。

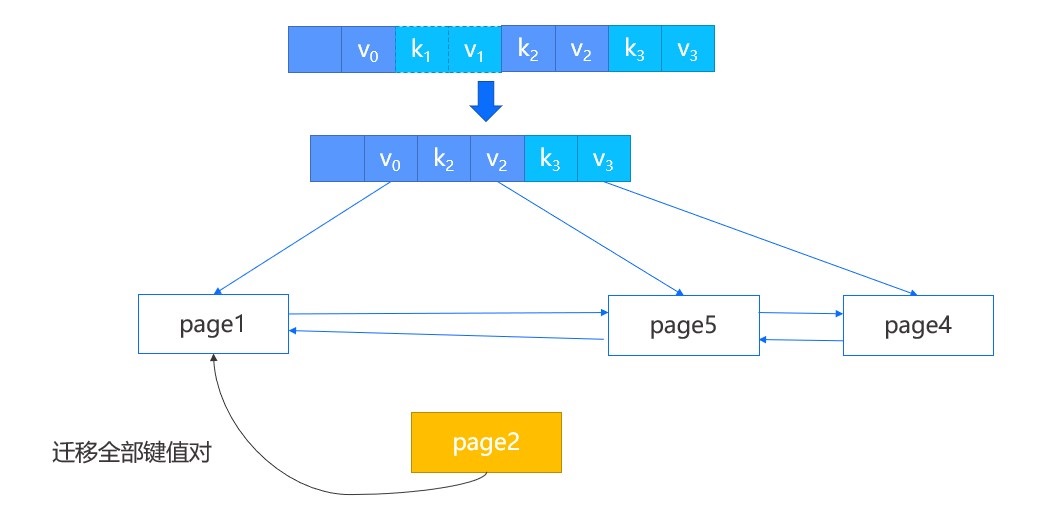

首先在结点内删除键值对,然后判断其中的键值对数目是否小于一半,如果是则需要进行特殊处理。比如 page2 中删除一个键值对,导致其键值对数目小于一半,此时通过它的父结点找到该结点的左兄弟,如果是最左边的结点,则找到其右兄弟。

-

如果两个结点的所有键值对能容纳在一个结点内,那么进行合并操作,将右结点的数据迁移到左结点,并删除父结点中指向右结点的键值对。

-

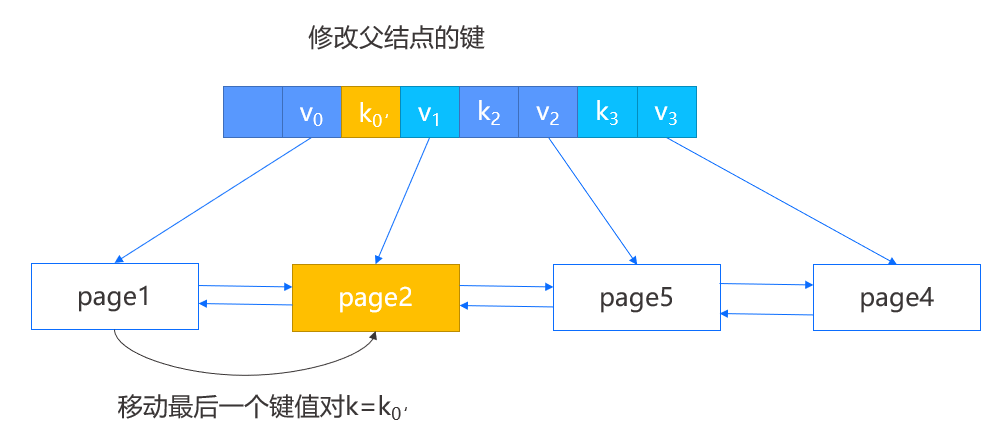

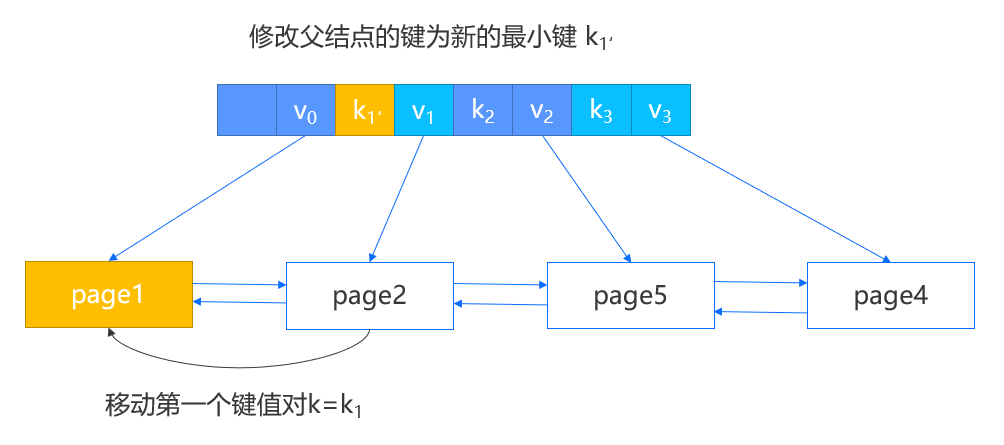

如果两个结点的所有键值对不能容纳在一个结点内,那么进行重构操作。

-

当所删除键值对的结点不是第一个结点时,那么选择将左兄弟的最后一个键值对移动到当前结点,并修改父结点中指向当前结点的键。

-

当所删除键值对的结点是第一个结点时,那么选择将右兄弟的第一个键值对移动到当前结点,并修改父结点中指向右兄弟的键。

-

在上述两种操作中,合并操作会导致父结点删除键值对,因此会向上递归地去判断是否需要再次的合并与重构。

MiniOB 是 OceanBase 联合华中科技大学推出的一款用于教学的小型数据库系统,希望能够帮助数据库爱好者系统性的学习数据库原理与实战。

B+ 树介绍

B+ 树是传统数据库中常见的索引数据结构,比如MySQL、PostgreSQL都实现了B+树索引。B+ 树是一个平衡多叉树,层级少(通常只有3层)、数据块(内部节点/叶子节点)大小固定,是一个非常优秀的磁盘数据结构。关于B+ 树的原理和实现,网上有非常多的介绍,就不在此聒噪。这里将介绍如何实现支持并发操作的B+树以及MiniOB中的实现。

B+树的并发操作

在多线程并发操作时,通常使用的手段是加锁,这里的实现方法也是这样。不过在学习并发B+树实现原理之前,需要对B+树的实现比较熟悉,有兴趣的同学可以网上搜索一下。

Crabing Protocol

在操作B+树时加对应的读写锁是一种最简单粗暴但是有效的方法,只是这样实现效率不高。于是就有一些研究创建了更高效的并发协议,并且会在协议设计上防止死锁的发生。

B+树是一个树状的结构,并且所有的数据都是在叶子节点上,每次操作,几乎都是从根节点开始向下遍历,直到找到对应的叶子节点。然后在叶子节点执行相关操作,如果对上层节点会产生影响,必须需要重新平衡,那就反方向回溯调整节点。 Crabing协议是从根节点开始加锁,找到对应的子节点,就加上子节点的锁。一直循环到叶子节点。在拿到某个子节点锁时,如果当前节点是“安全的”,那就可以释放上级节点的锁。

什么是“安全的” 如果在操作某个节点时,可以确定这个节点上的动作,不会影响到它的父节点,那就说是“安全的”。 B+树上节点的操作有三个:插入、删除和查询。

- 插入:一次仅插入一个数据。如果插入一个数据后,这个节点不需要分裂,就是当前节点元素个数再增加一个,也不会达到一个节点允许容纳的最大个数,那就是安全的。不会分裂就不会影响到父节点。

- 删除:一次仅删除一个数据。如果删除一个数据后,这个节点不需要与其它节点合并,就是当前节点元素个数删除一个后,也不会达到节点允许容纳的最小值,那就是安全的。不需要合并就不会影响到父节点。

- 查询:读取数据对节点来说永远是安全的。

B+树的操作除了上述的插入、删除和查询,还有一个扫描操作。比如遍历所有的数据,通常是从根节点,找到最左边的叶子节点,然后从向右依次访问各个叶子节点。此时与加锁的顺序,与之前描述的几种方式是不同的,那为了防止死锁,就需要对遍历做特殊处理。一种简单的方法是,在访问某个叶子节点时,尝试对叶子节点加锁,如果判断需要等待,那就退出本次遍历扫描操作,重新来一遍。当然这种方法很低效,有兴趣的同学可以参考[2],了解更高效的扫描加锁方案。

问题:哪种场景下,扫描加锁可能会与更新操作的加锁引起死锁? 问题:请参考[2],给出一个遍历时不需要重试的加锁方案。

MiniOB实现

MiniOB的B+树并发实现方案与上个章节描述的方法是一致的。这里介绍一些实现细节。

在这里假设同学们对B+树的实现已经有了一定的了解。

B+树与Buffer Pool

B+树的数据是放在磁盘上的,但是直接读写磁盘是很慢的一个操作,因此这里增加一个内存缓冲层,叫做Buffer Pool。了解数据库实现的同学对这个名词不会陌生。在MiniOB中,Buffer Pool的实现是 class DiskBufferPool。对Buffer Pool实现不太了解也没关系,这里接单介绍一下。

DiskBufferPool 将一个磁盘文件按照页来划分(假设一页是8K,但是不一定),每次从磁盘中读取文件或者将数据写入到文件,都是以页为单位的。在将文件某个页面加载到内存中时,需要申请一块内存。内存通常会比磁盘要小很多,就需要引入内存管理。在这里引入Frame(页帧)的概念(参考 class Frame),每个Frame关联一个页面。FrameManager负责分配、释放Frame,并且在没有足够Frame的情况下,淘汰掉一些Frame,然后将这些Frame关联到新的磁盘页面。

那如何知道某个Frame关联的页面是否可以释放,然后可以与其它页面关联?

如果这个Frame没有任何人使用,就可以重新关联到其它页面。这里使用的方法是引用计数,称为 pin_count。每次获取某个Frame时,pin_count就加1,操作完释放时,pin_count减1。如果pin_count是0,就可以将页面数据刷新到磁盘(如果需要的话),然后将Frame与磁盘文件的其它数据块关联起来。

为了支持并发操作,Frame引入了读写锁。操作B+树时,就需要加对应的读写锁。

B+ 树的数据保存在磁盘,其树节点,包括内部节点和叶子节点,都对应一个页面。当对某个节点操作时,需要申请相应的Frame,pin_count加1,然后加读锁/写锁。由于访问子节点时,父节点的锁可能可以释放,也可能不能释放,那么需要记录下某个某个操作在整个过程中,加了哪些锁,对哪些frame 做了pin操作,以便在合适的时机,能够释放掉所有相关的资源,防止资源泄露。这里引入class LatchMemo 记录当前访问过的页面,加过的锁。

问题:为什么一定要先执行解锁,再执行unpin(frame引用计数减1)?

处理流程

B+树相关的操作一共有4个:插入、删除、查找和遍历/扫描。这里对每个操作的流程都做一个汇总说明,希望能帮助大家了解大致的流程。

插入操作 除了查询和扫描操作需要加读锁,其它操作都是写锁。

- leaf_node = find_leaf // 查找叶子节点是所有操作的基本动作

memo.init // memo <=> LatchMemo,记录加过的锁、访问过的页面

lock root page

- node = crabing_protocal_fetch_page(root_page)

loop: while node is not leaf // 循环查找,直到找到叶子节点

child_page = get_child(node)

- node = crabing_protocal_fetch_page(child_page)

frame = get_page(child_page, memo)

lock_write(memo, frame)

node = get_node(frame)

// 如果当前节点是安全的,就释放掉所有父节点和祖先节点的锁、pin_count

release_parent(memo) if is_safe(node)

- insert_entry_into_leaf(leaf_node)

- split if node.size == node.max_size

- loop: insert_entry_into_parent // 如果执行过分裂,那么父节点也会受到影响

- memo.release_all // LatchMemo 帮我们做资源释放

删除操作 与插入一样,需要对操作的节点加写锁。

- leaf_node = find_leaf // 查找的逻辑与插入中的相同

- leaf_node.remove_entry

- node = leaf_node

- loop: coalesce_or_redistribute(node) if node.size < node.min_size and node is not root

neighbor_node = get_neighbor(node)

// 两个节点间的数据重新分配一下

redistribute(node, neighbor_node) if node.size + neighbor_node.size > node.max_size

// 合并两个节点

coalesce(node, neighbor_node) if node.size + neighbor_node.size <= node.max_size

memo.release_all

查找操作 查找是只读的,所以只加读锁

- leaf_node = find_leaf // 与插入的查找叶子节点逻辑相同。不过对所有节点的操作都是安全的

- return leaf_node.find(entry)

- memo.release_all

扫描/遍历操作

- leaf_node = find_left_node

loop: node != nullptr

scan node

node_right = node->right // 遍历直接从最左边的叶子节点,一直遍历到最右边

return LOCK_WAIT if node_right.try_read_lock // 不直接加锁,而是尝试加锁,一旦失败就返回

node = node_right

memo.release_last // 释放当前节点之前加到的锁

根节点处理

前面描述的几个操作,没有特殊考虑根节点。根节点与其它节点相比有一些特殊的地方:

- B+树有一个单独的数据记录根节点的页面ID,如果根节点发生变更,这个数据也要随着变更。这个数据不是被Frame的锁保护的;

- 根节点具有一定的特殊性,它是否“安全”,就是根节点是否需要变更,与普通节点的判断有些不同。

按照上面的描述,我们在更新(插入/删除)执行时,除了对节点加锁,还需要对记录根节点的数据加锁,并且使用独特的判断是否“安全的”方法。

在MiniOB中,可以参考LatchMemo,是直接使用xlatch/slatch对Mutex来记录加过的锁,这里可以直接把根节点数据保护锁,告诉LatchMemo,让它来负责相关处理工作。

判断根节点是否安全,可以参考IndexNodeHandler::is_safe中is_root_node相关的判断。

如何测试

想要保证并发实现没有问题是在太困难了,虽然有一些工具来证明自己的逻辑模型没有问题,但是这些工具使用起来也很困难。这里使用了一个比较简单的方法,基于google benchmark框架,编写了一个多线程请求客户端。如果多个客户端在一段时间内,一直能够比较平稳的发起请求与收到应答,就认为B+树的并发没有问题。测试代码在bplus_tree_concurrency_test.cpp文件中,这里包含了多线程插入、删除、查询、扫描以及混合场景测试。

其它

有条件的开启并发

MiniOB是一个用来学习的小型数据库,为了简化上手难度,只有使用-DCONCURRENCY=ON时,并发才能生效,可以参考 mutex.h中class Mutex和class SharedMutex的实现。当CONCURRENCY=OFF时,所有的加锁和解锁函数相当于什么都没做。

并发中的调试

死锁是让人非常头疼的事情,我们给Frame增加了调试日志,并且配合pin_count的动作,每次加锁、解锁以及pin/unpin都会打印相关日志,并在出现非预期的情况下,直接ABORT,以尽早的发现问题。这个调试能力需要在编译时使用条件 -DDEBUG=ON 才会生效。

以写锁为例:

void Frame::write_latch(intptr_t xid)

{

{

std::scoped_lock debug_lock(debug_lock_); // 如果非DEBUG模式编译,什么都不会做

ASSERT(pin_count_.load() > 0, // 加锁时,pin_count必须大于0,可以想想为什么?

"frame lock. write lock failed while pin count is invalid. "

"this=%p, pin=%d, pageNum=%d, fd=%d, xid=%lx, lbt=%s", // 这里会打印各种相关的数据,帮助调试

this, pin_count_.load(), page_.page_num, file_desc_, xid, lbt()); // lbt会打印出调用栈信息

ASSERT(write_locker_ != xid, "frame lock write twice." ...);

ASSERT(read_lockers_.find(xid) == read_lockers_.end(),

"frame lock write while holding the read lock." ...);

}

lock_.lock();

write_locker_ = xid;

LOG_DEBUG("frame write lock success." ...); // 加锁成功也打印一个日志。注意日志级别是DEBUG

}

参考

[2] Concurrency of Operations on B-Trees

[3] MySQL/MariaDB mini trans相关代码

本篇文档介绍 MiniOB 中的线程池模型。

简介

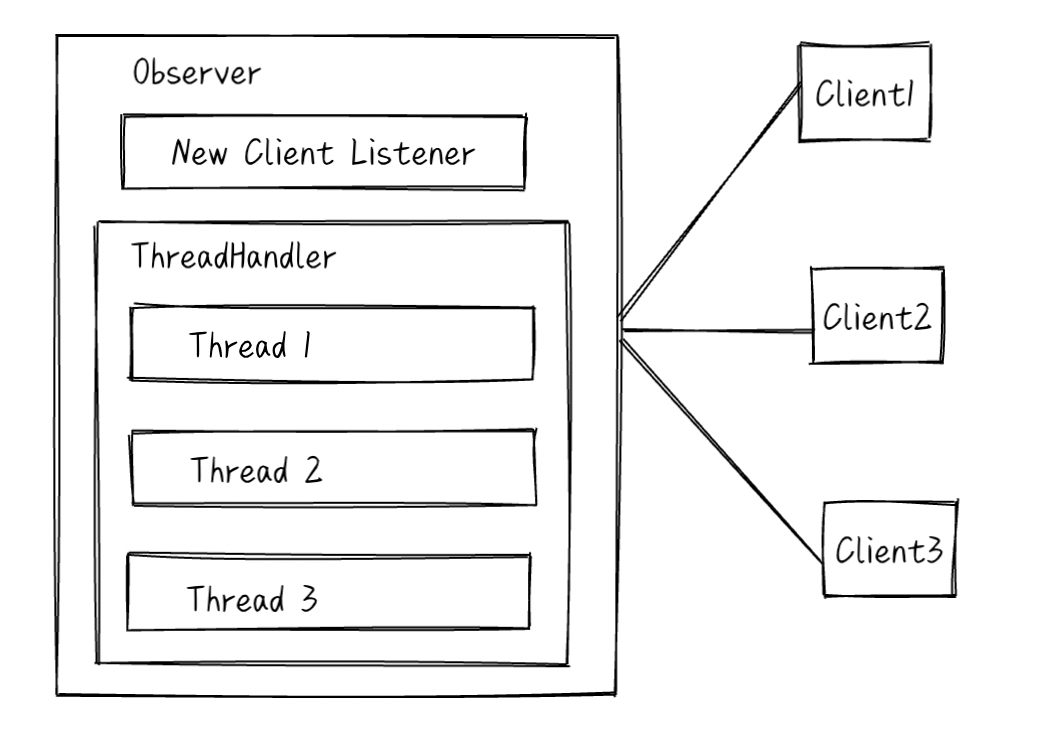

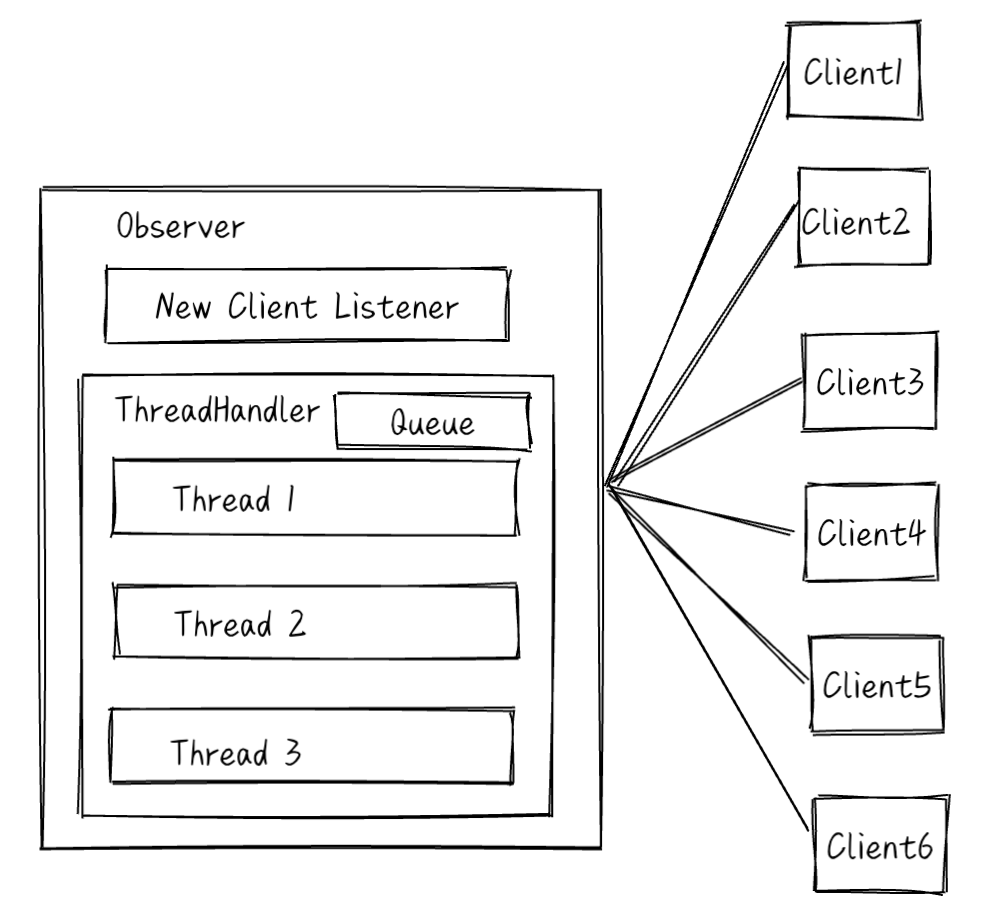

多线程是提高系统资源利用率的一种常用手段,也是我们学习软件开发进阶的必经之路。 MiniOB 实现了一个可扩展的线程模型,当前支持两种线程池模型:

- 一个连接一个线程;

- 一个线程池处理所有连接。

这种设计是模仿了MySQL/MariaDB的线程模型设计。

线程模型设计

命令行参数

当前MiniOB的线程池模型通过命令行接口指定使用哪种类型:

# 一个连接一个线程(默认)

observer -T=one-thread-per-connection

# 一个线程池处理所有连接

observer -T=java-thread-pool

ThreadHandler::create 会根据传入的名字创建对应的 ThreadHandler 对象。

线程池模型做什么

这个模型并不负责所有的任务,只处理客户端发来的请求。包括监听客户端是否有消息到达、处理SQL请求与返回应答、关闭连接等。

线程模型并不负责监听新的客户端连接,这是在主线程中做的事情,参考 NetServer::serve。当有新的连接到达时,会调用 ThreadHandler::new_connection,线程模型按照自己的模型设计来处理新来的连接。

一个连接一个线程

OneThreadPerConnectionThreadHandler 会为每个连接创建一个线程,这个线程负责监听这个连接是否有消息到达、处理SQL请求与返回应答、关闭连接等。

线程池模型

JavaThreadPoolThreadHandler 会创建一个线程池,线程池中一个线程负责监听所有连接是否有消息到达。如果有消息到达,就将这个连接对象放入线程池任务队列中,等待线程池中的线程来处理。在某个连接的任务处理完成之前,不会监听它的新消息。

这个线程池使用libevent实现消息监听,参考 JavaThreadPoolThreadHandler::start。

这里解释一下为什么叫做JavaThreadPoolThreadHandler,因为这个线程池的设计是参考了Java的线程池设计,但是做了简化,参考 ThreadPoolExecutor。

ThreadPoolExecutor 是一个简单的可伸缩线程池。当任务比当前空闲线程多的时候,就会扩容。当某些线程空闲时间比较久,就会自动退出。

参考

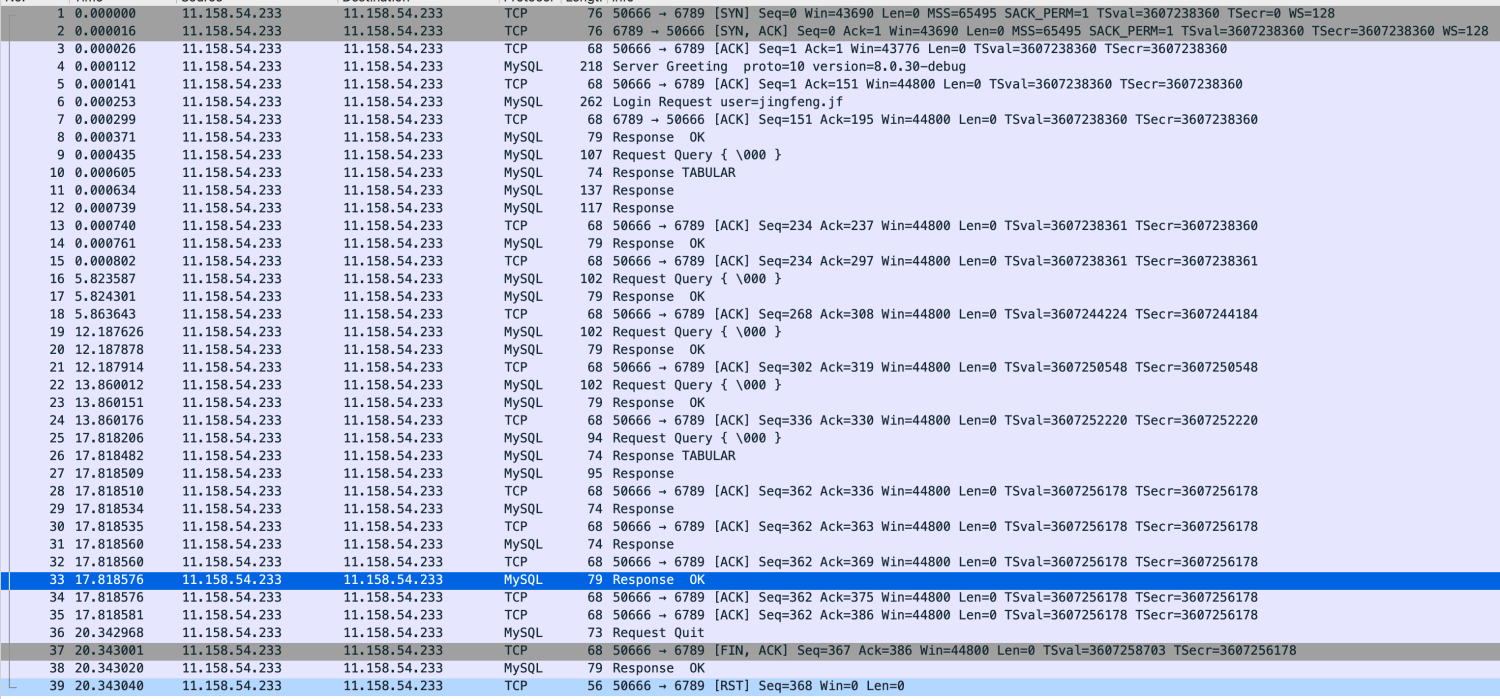

本篇文档介绍MySQL的通讯流程以及MiniOB对它的支持与实现

MiniOB 通讯协议简介

MiniOB 支持使用客户端/服务端模式,客户端与服务端需要通过通讯来交互。当前服务端支持普通的文本协议与MySQL协议。 普通的文本协议非常简单,每个请求和应答都使用字符串来传递,字符串以'\0'字符结尾,因此文本协议不能支持二进制数据的传输。 MySQL 是一个非常流行的开源数据库,它有非常丰富的周边生态工具,如果MiniOB可以支持MySQL协议,后续就可以逐步扩展支持这些工具。

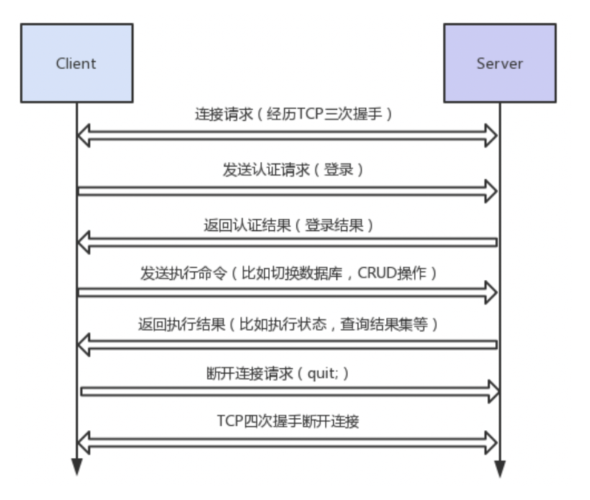

MySQL 通讯协议

MySQL 服务端与客户端交互的过程。

- 三次握手建立 TCP 连接。

- 建立 MySQL 连接,也就是认证阶段。 服务端 -> 客户端:发送握手初始化包 (Handshake Initialization Packet)。 客户端 -> 服务端:发送验证包 (Client Authentication Packet)。 服务端 -> 客户端:认证结果消息。

- 认证通过之后,客户端开始与服务端之间交互,也就是命令执行阶段。 客户端 -> 服务端:发送命令包 (Command Packet)。 服务端 -> 客户端:发送回应包 (OK Packet, or Error Packet, or Result Set Packet)。

- 断开 MySQL 连接。 客户端 -> 服务器:发送退出命令包。

- 四次握手断开 TCP 连接。

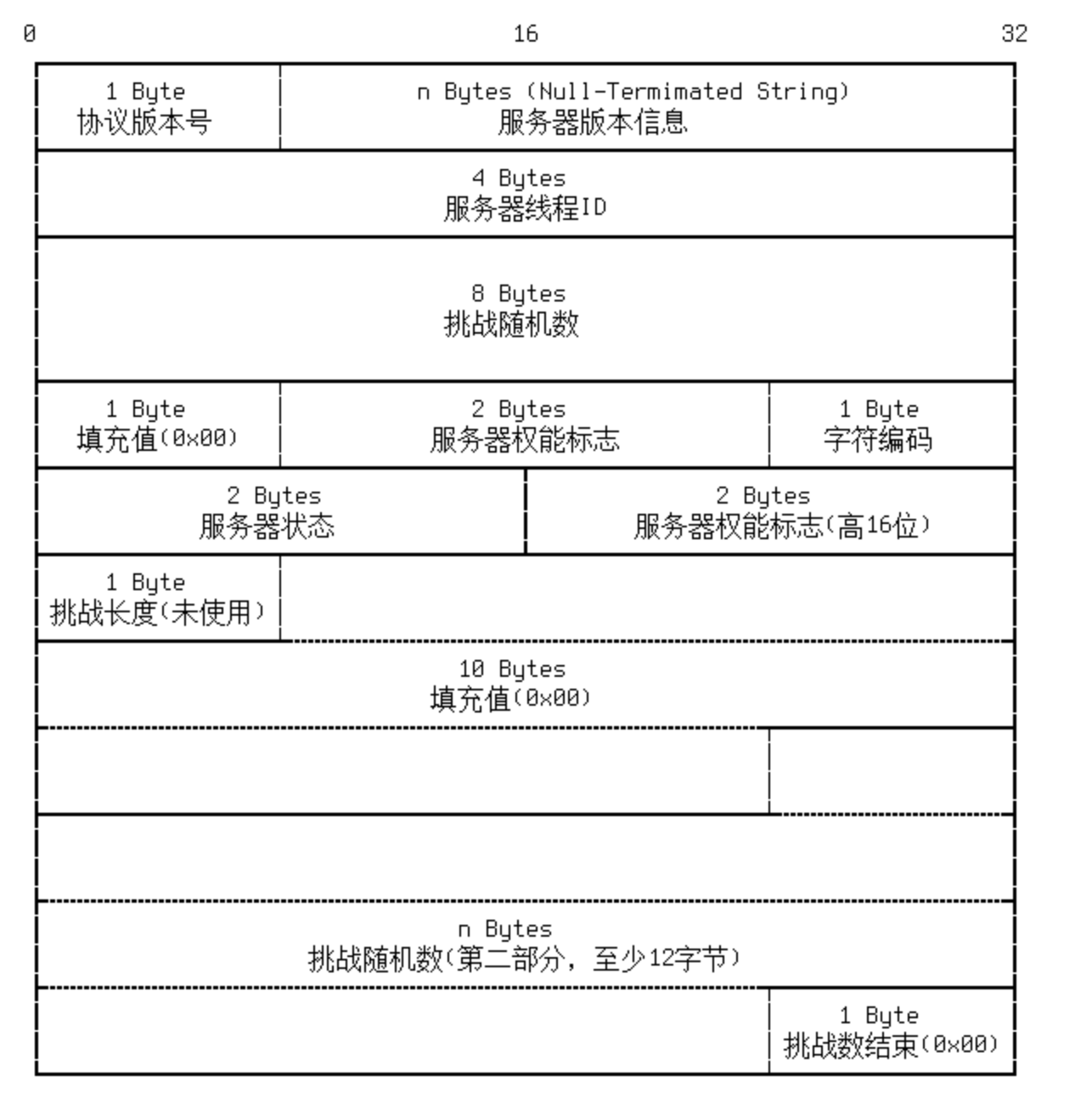

MySQL Packet

MySQL 协议通过packet来交互。每个packet都包含一个packet header和packet payload。 packet header包含payload的长度和当前消息包的sequence。sequence是从1开始,每发出一个消息包,sequence都会加1。 每个消息包都由一些字段构成,字段的类型有很多种,主要有整形和字符串。每种类型又有多种编码方式,比如字符串有固定长度的、以'\0'结尾的和带长度编码的。这些可以参考 mysql_communicator.cpp::store_xxx 函数。

注意,MySQL协议中数字都是小端编码。而MiniOB没有对大小端做处理,所以当前只能运行在小端的机器上。

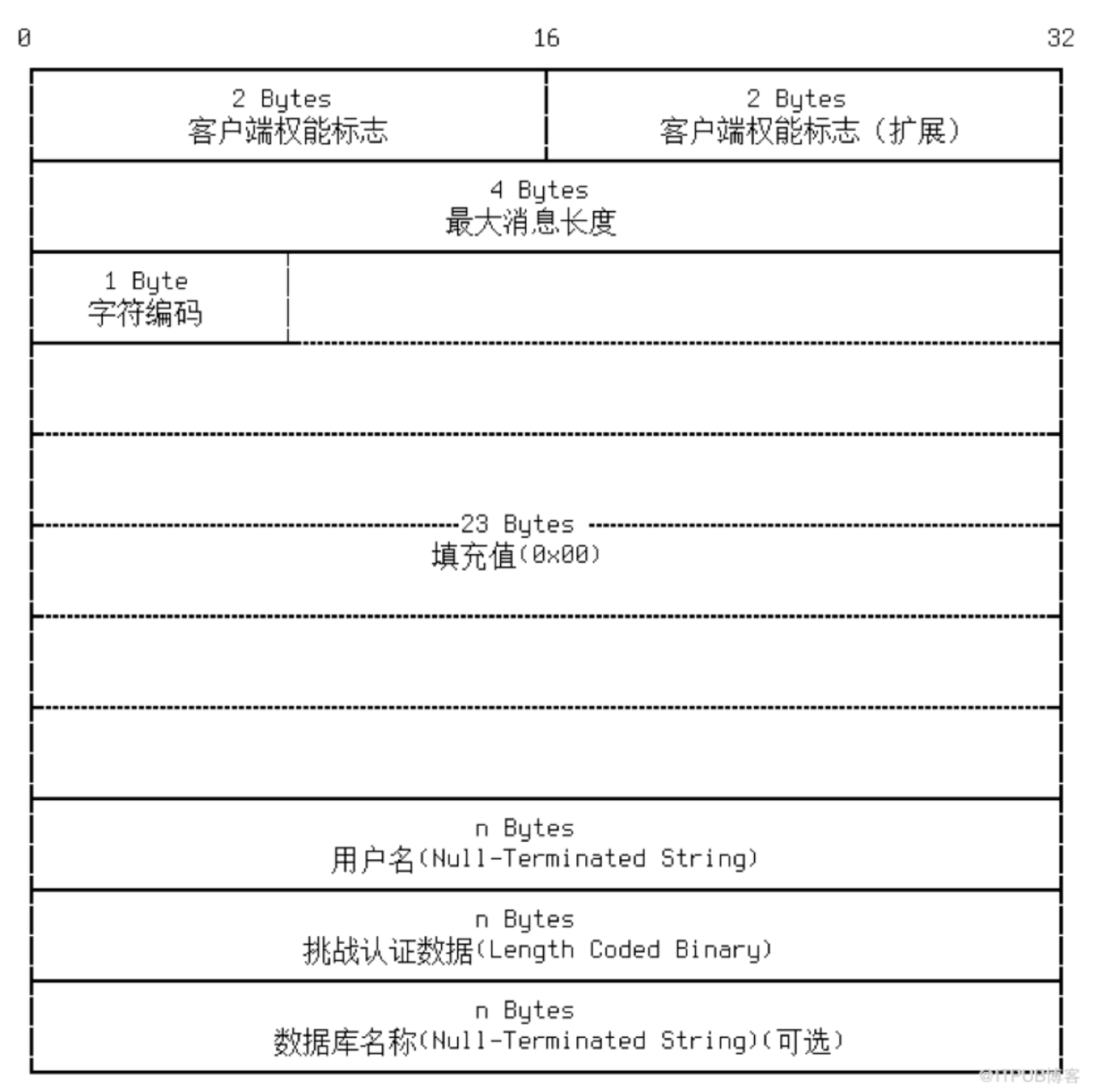

认证阶段

完成MySQL客户端与MiniOB的建连。 构造handshake包,解析验证包, 返回OK包,确保server与客户端的建连。

握手包handshake格式

在accept接收到新的连接时,server端需要先发起handshake握手包给客户端。

认证报文

这里有两次hash加密,基于随机挑战码和密码加密后返回给server端。

MyqlCommunicator::init是在刚接收到新的客户端连接时的接口,它会构造一个握手包发给客户端。在第一次接收客户端数据时,即在MysqlCommunicator::read_event中,如果判断还没有做过鉴权,就会做一个特殊处理,判断是否可以认证通过。不过当前MiniOB不会真的做密码验证。如果已经做过鉴权,就会认为接收的数据包是一个普通的命令消息。在接收到客户端的认证报文后,需要返回OK包给客户端。

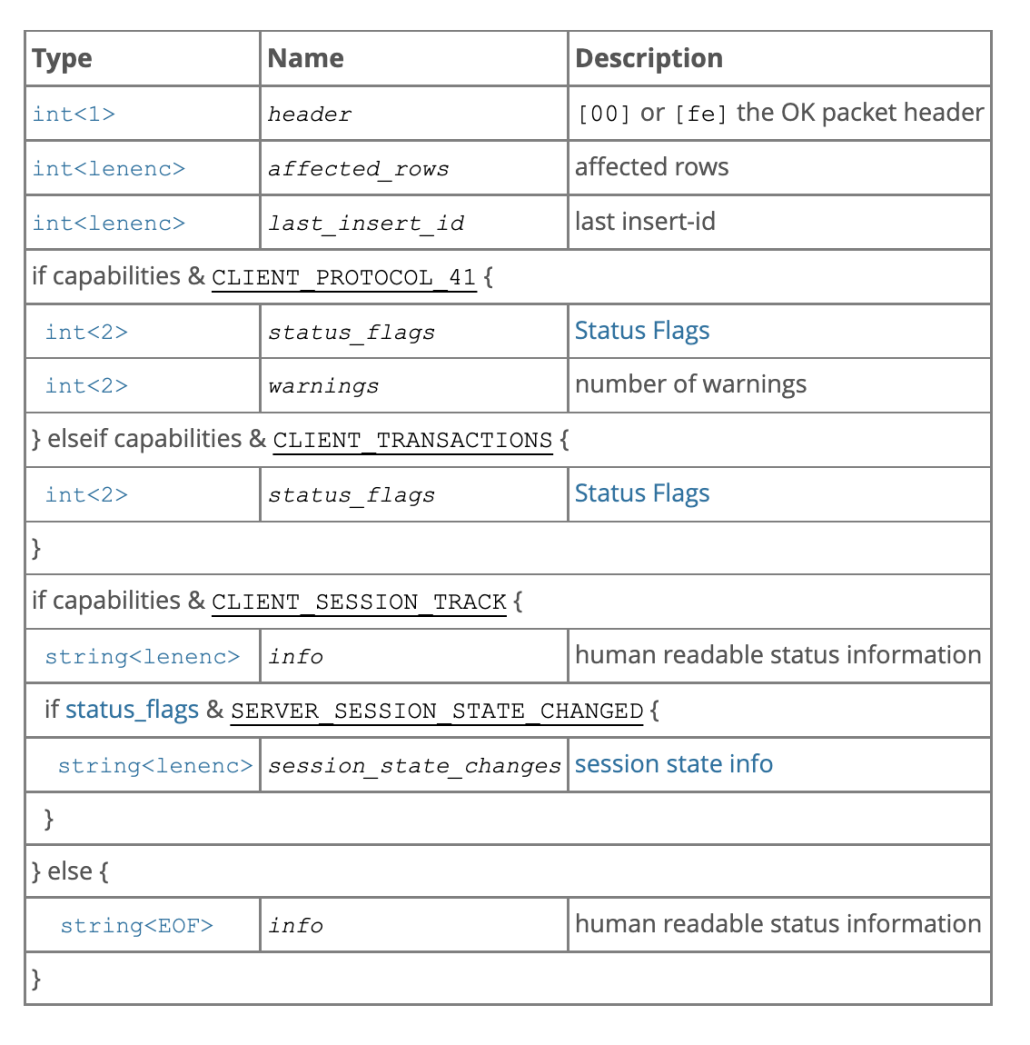

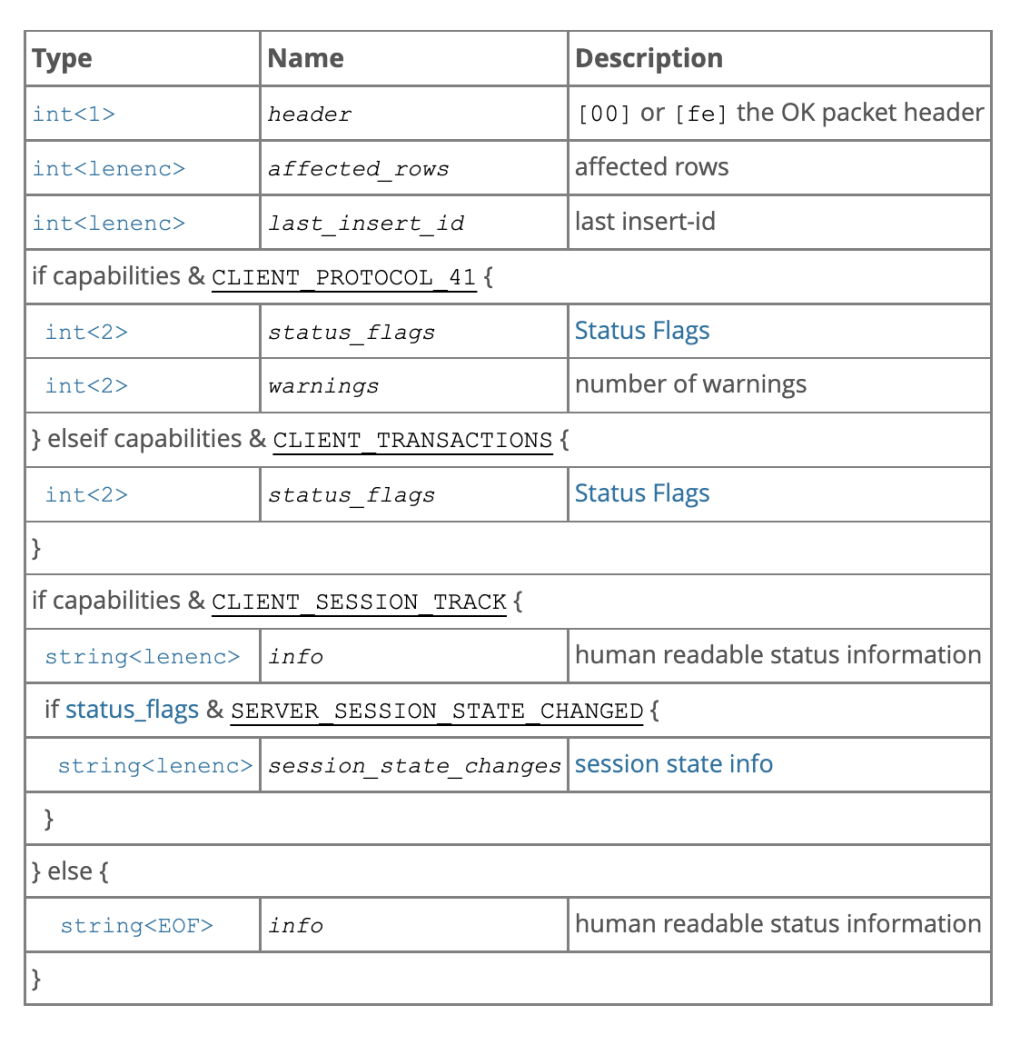

OK包报文

请求交互阶段

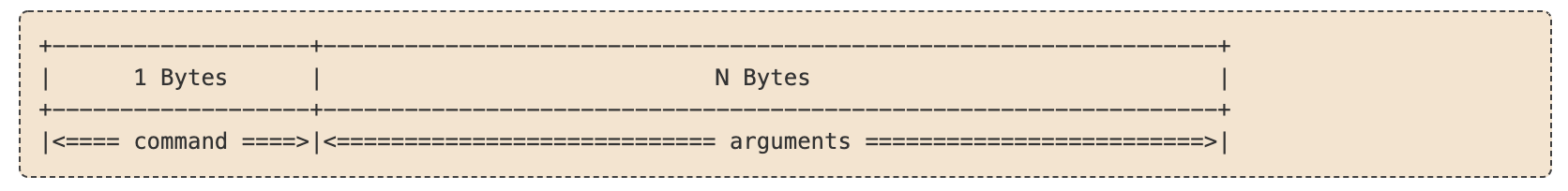

在完成鉴权后,客户端就可以发送普通的请求命令到服务端,比如 "select * from t;" 查询语句。

MiniOB 仅考虑支持普通的文本查询命令。普通的文本查询命令,包格式也符合MySQL Packet的要求。其payload的第一个字节是command,接着就是请求命令,也就是SQL语句。

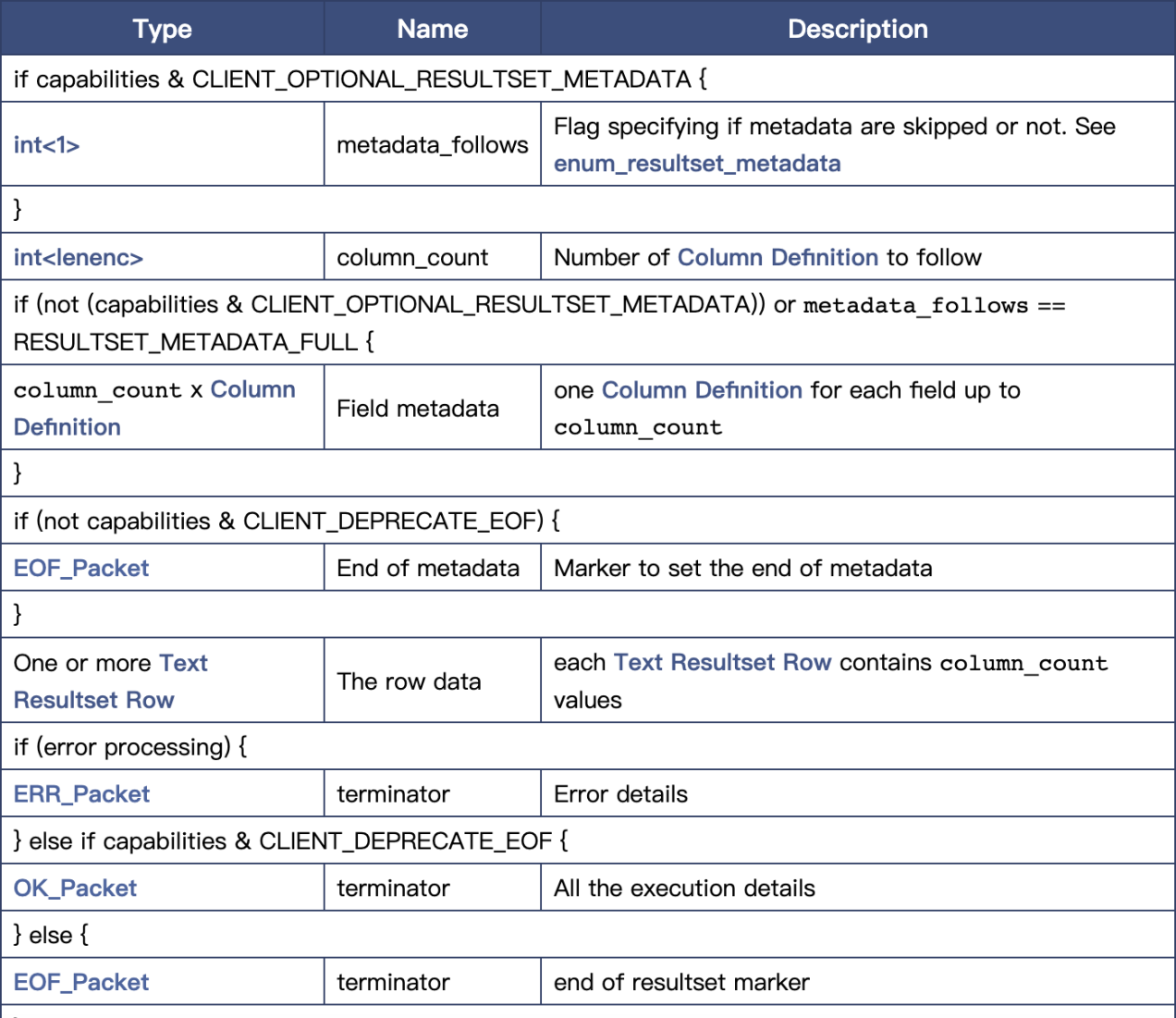

SQL请求的返回数据类型比较丰富,有OK、Error、EOF和ResultSet。 如果SQL请求不需要返回行数据,那直接返回处理结果即可,比如OK或者Error。 如果需要返回行数据,比如 "select * from t;" 查询请求,需要通过ResultSet包来返回客户端这些数据。有时候为了表示没有更多的数据,需要返回一个EOF包。

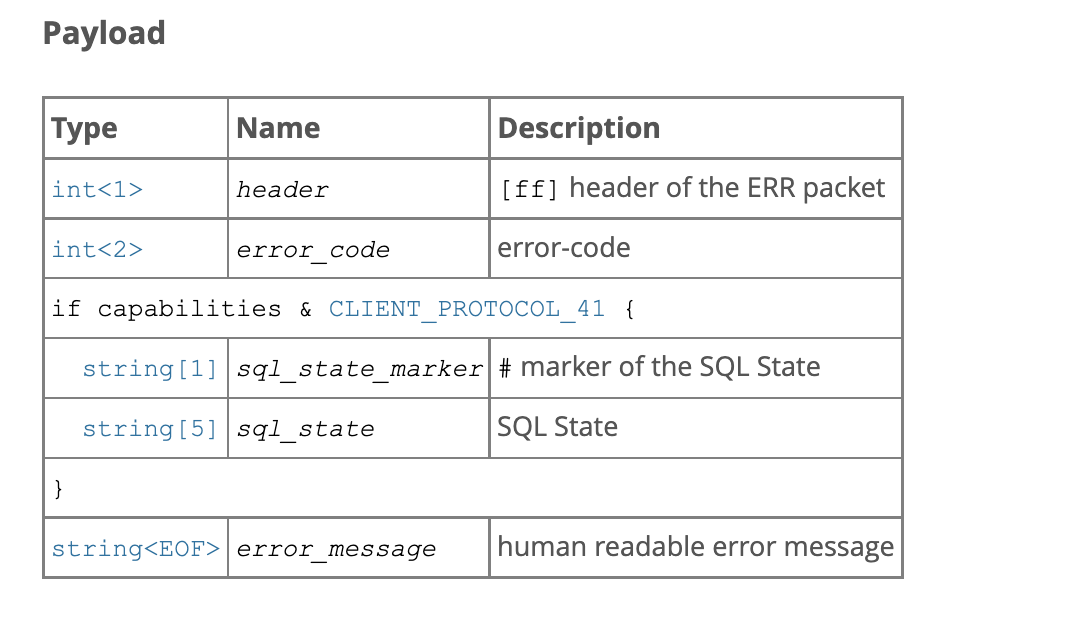

OK/EOF包

Error包

ResultSet

抓包

抓包可以很清晰的看到整个流程。

Doxy代码文档

注意 由于最新代码的事务模型与2022年已经不同,因此最新代码不能通过MiniOB-2022的训练营测试的basic用例,但是不影响做其它的用例测试。同学们遇到官方代码无法通过MiniOB-2022的basic用例,请忽略。

OceanBase 数据库大赛

2022 OceanBase 数据库大赛是由中国计算机学会(CCF)数据库专业委员会指导,OceanBase 与蚂蚁技术研究院学术合作团队联合举办的数据库内核实战赛事。本次大赛主要面向全国爱好数据库的高校学生,以“竞技、交流、成长”为宗旨,搭建基于赛事的技术交流平台,促进高校创新人才培养机制,不仅帮助学生从0开始系统化学习数据库理论知识,提升学生数据库实践能力,更能帮助学生走向企业积累经验,促进国内数据库人才的发展,碰撞出创新的火花。

更多详情, 请参考 OceanBase 大赛

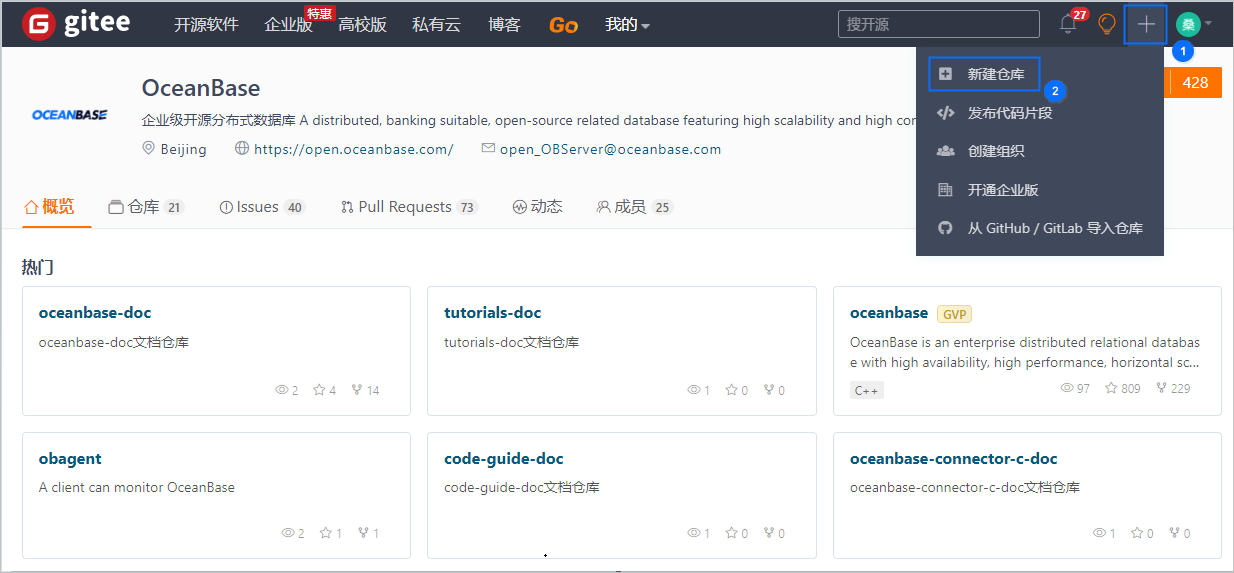

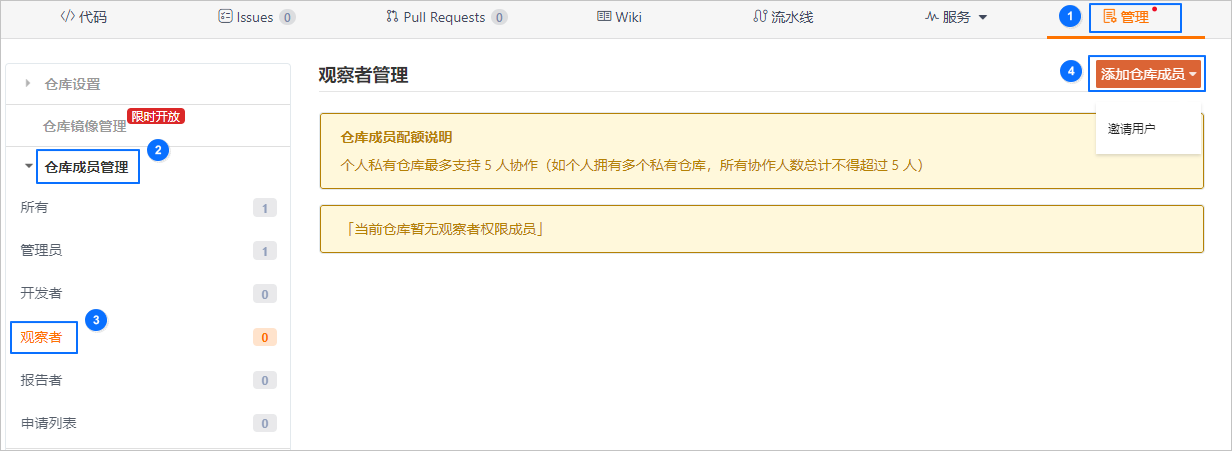

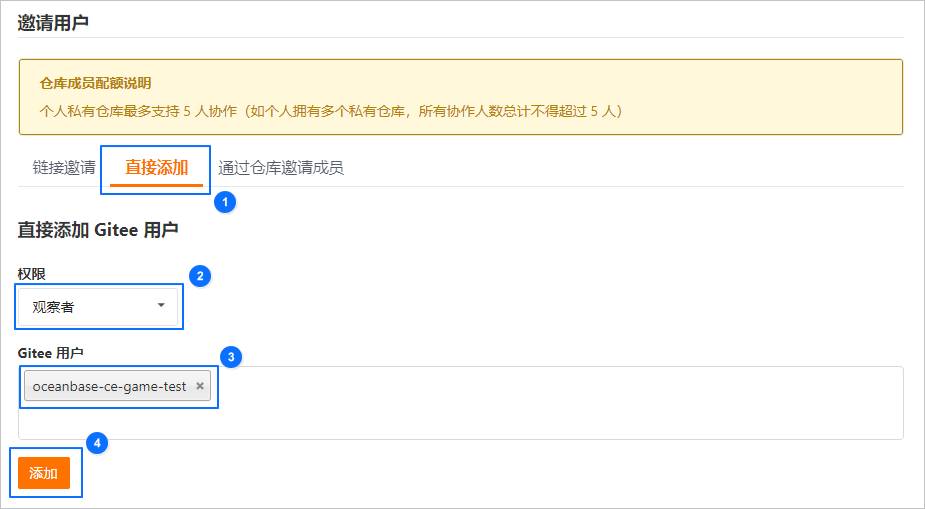

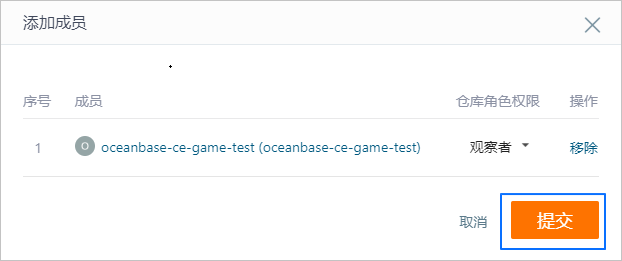

在开始参加大赛或者训练营之前,需要创建自己的代码仓库,这里有一个gitee的使用说明: 大赛手把手入门教程

作为参考,这里有第一届数据库大赛的题目介绍: 第一届数据库大赛题目介绍

还有往届选手给出了一些题解:

在参赛前,除了学习基础的理论知识,还可以使用OceanBase提供的训练营,来快速上手: 训练营

训练营是一个自动化黑盒测试平台。同学们可以按照题目的描述要求,基于MiniOB实现相应的SQL功能,然后将自己的代码提交至训练营做测试验证,最终得到测试结果。

当前训练营有两个MiniOB的题库,其中MiniOB是2021年OceanBase大赛的题库,MiniOB-2022是2022年数据库大赛的题库。题库中都会有basic测试用例,是MiniOB官方代码中既有的功能,通常不需要同学们做修改。此题目的目的是为了检测在实现新功能时,不破坏现有的功能。

注意 由于最新代码的事务模型与2022年已经不同,因此最新代码不能通过MiniOB-2022的训练营测试的basic用例,但是不影响做其它的用例测试。同学们遇到官方代码无法通过MiniOB-2022的basic用例,请忽略。

训练营的使用方法比较简单,不过这里也有一个小手册: 训练营使用手册

为了方便大家使用训练营时获取调试信息,这里有一个小手册: 训练营调试输出手册

注意,在训练营开始前,需要注意自己的程序输出需要满足一定的要求,请参考: 提交测试需要满足的输出要求

我们也收集了一些常见问题,可以参考: 常见问题

训练营建议: 训练营对同学们的大工程实战能力提升非常高,在现在有的几万行代码上需要添加非常多的功能,整个训练营完成后代码量很可观。因此,同学们在实现各种功能时,不要一直堆砌代码,需要不停的优化重构现有功能模块与架构,以使自己的代码能够稳步前进。

对于比赛和训练营测试后台,需要做一些输出约定,才能正确的进行测试。

*** 注意: 后台测试环境,依赖本章节的输出要求。如果输出格式不满足要求,有些case将无法通过***

输出是指服务端返回给客户端的数据。为了可以做测试,需要对输出的格式做约定。 NOTE:后台测试程序,是将预先编辑好的Case执行后,将执行结果与预期输出结果(预先编写完成)做对比,与mysql test工作原理类似,因此需要严格按照输出约束来输出。

这里虽然列出了很多约束条件,但是同学们并不需要担心,当前的实现已经满足了这些约束条件,或者给出了满足约束的帮助函数,只要按照要求使用即可。

-

语法解析错误,返回 FAILURE(只返回这个字符串,不带任何多余字符)。

-

对于DML和DDL操作,执行成功返回SUCCESS,失败返回FAILURE。更新和删除操作时没有数据变更,只要没有错误,输出也是SUCCESS。

-

对于QUERY操作,如果执行失败,返回FAILURE(包括语法错误)。否则按照下面的格式要求输出:列名显示和顺序说明:

- 单表查询,没有指定列名(select * from t) ,按照建表语句的顺序列出列名,列名不需要带表明

- 单表查询,指定了列名,按照指定的顺序输出列名,列名不需要带表名

- 表查询,没有指定列名(select * from t,t1),列名需要带表明,使用'.'分开。每张表的列名与建表时顺序保持一致,多张表按照from后指定的顺序依次排列

- 多表查询,指定列名,就按照指定的顺序排列

- 多表查询,有些指定列名,有些没有指定(select t1.*, t2.id from t1,t2)。没有指定的与建表时保持一致,否则按照指定的顺序排列 输出格式: 列名之间使用 ' | '分开,注意 '|'左右各有一个空格。输出列名后,第二行开始输出列值,值之间也使用' | '隔开。 注意:第一列和最后一列没有分隔符,也没有空格 如果没有数据,显示列名即可。

- 聚合函数字段输出,保留与输入相似的格式。比如select max(age) from t; 那么输出时,列名输出max(age)。注意,圆括号内没有空格。

-

所有输出不区分大小写

-

日期(date)输出格式使用:"YYYY-mm-DD"

-

输出的字符串不使用单引号双引号或其它括起来

-

浮点数输出,不要带后面多余的0,可以参考C sprintf的%g格式输出,保留两位小数。参考函数 double_to_str

FAQ

- 某张表或者某个查询结果一行数据都没有,但是依然需要输出表头信息

- 查询语句输入的字段名带了表名,比如select t.id from t; ,因为只有一张表,还是仅输出字段名称

- 测试不考察大小写,所以输入输出都不区分大小写

本篇文档介绍如何向训练营输出调试信息。

在使用训练营提交测试时,有时候会遇到本地环境没有问题,但是训练营上的输出总是不符合预期。但是训练营没有办法调试,这时候就需要在训练营上输出调试信息,以便于定位问题。

如何输出调试信息

可以参考文件 sql_debug.h,在需要输出调试信息的地方,调用sql_debug函数即可。sql_debug 的使用与打印日志类似,不过可以在向客户端输出正常结果后,再输出调试信息。

执行sql_debug同时会在日志中打印DEBUG级别的日志。

示例

CreateTableStmt::createTableScanPhysicalOperator::next

注意 由于训练营上能够容纳的信息有限,所以输出太多信息会被截断。

开关

每个连接都可以开启或关闭调试,可以参考 Session::sql_debug_。

在交互式命令行中,可以使用 set sql_debug=1 开启调试,使用 set sql_debug=0 关闭调试。

当前没有实现查看变量的命令。

示例

miniob > select * from t;

id

1

# get a tuple: 1

miniob > set sql_debug=0;

SUCCESS

miniob > select * from t;

id

1

miniob 题目

背景

这里的题目是2021年OceanBase数据库大赛初赛时提供的赛题。这些赛题的入门门槛较低, 适合所有参赛选手。 面向的对象主要是在校学生,数据库爱好者, 或者对基础技术有一定兴趣的爱好者, 并且考题对诸多模块做了简化,比如不考虑并发操作, 事务比较简单。 初赛的目标是让不熟悉数据库设计和实现的同学能够快速的了解与深入学习数据库内核,期望通过miniob相关训练之后,能够对各个数据库内核模块的功能与它们之间的关联有所了解,并能够在使用时,设计出高效的SQL, 并帮助降低学习OceanBase 内核的学习门槛。

题目介绍

预选赛,题目分为两类,一类必做题,一类选做题。选做题按照实现的功能计分。

计分规则:必做题和选做题都有分数。但是必做题做完后,选做题的分数才会进行累计。

作为练习,这些题目在单个实现时,是比较简单的。因为除了必做题,题目之间都是单独测试的。希望你能够在实现多个功能时,考虑一下多个功能之间的关联。比如实现了多字段索引,可以考虑下多字段索引的唯一索引、根据索引查询数据等功能。另外,可以给自己提高一点难度。比如在实现表查询时,可以想象内存中无法容纳这么多数据,那么如何创建临时文件,以及如何分批次发送结果到客户端。

必做题

| 名称 | 分值 | 描述 | 测试用例示例 |

|---|---|---|---|

| 优化buffer pool | 10 | 必做。实现LRU淘汰算法或其它淘汰算法。 题目没有明确的测试方法。同学可以通过这个简单的题目学习disk_buffer_pool的工作原理。 | |

| 查询元数据校验 select-meta | 10 | 必做。查询语句中存在不存在的列名、表名等,需要返回失败。需要检查代码,判断是否需要返回错误的地方都返回错误了。 | create table t(id int, age int); select * from t where name='a'; select address from t where id=1; select * from t_1000; select * from t where not_exists_col=1; |

| drop table drop-table | 10 | 必做。删除表。清除表相关的资源。 注意:要删除所有与表关联的数据,不仅仅是在create table时创建的资源,还包括索引等数据。 | create table t(id int, age int); create table t(id int, name char); drop table t; create table t(id int, name char); |

| 实现update功能 update | 10 | 必做。update单个字段即可。 可以参考insert_record和delete_record的实现。目前能支持update的语法解析,但是不能执行。需要考虑带条件查询的更新,和不带条件的更新。 | update t set age =100 where id=2; update set age=20 where id>100; |